« Le prix de la Banque de Suède en sciences économiques en mémoire d'Alfred Nobel a été attribué cette année à William Nordhaus et à Paul Romer pour avoir intégré le changement climatique et l’innovation technologique à l’analyse macroéconomie de long terme. Nous passons en revue les réactions de plusieurs économistes à cette annonce.

Sur VoxEU, Kevin Bryan a évoqué comment les lauréats du prix Nobel d’économie de cette année ont élaboré leurs contributions et comment ces dernières sont liées entre elles. Cela faisait plusieurs années que l’on s’attendait à ce que Nordhaus et Romer reçoivent cette récompense, mais c’est le fait qu’ils l’aient reçue en même temps qui a surpris : Nordhaus est surtout connu pour ses travaux en économie environnementale et Romer pour sa théorie de la croissance endogène. Mais après réflexion, les liens entre leurs travaux apparaissent évidents.

Avec Romer, nous avons un modèle d’équilibre général pour réfléchir aux raisons pour lesquelles les gens produisent de nouvelles technologies. La connexion avec Nordhaus se fait avec un problème qui est à la fois provoqué et résolu par la croissance. La croissance en tant qu’objectif de politique économique n’était pas remise en cause dans les années soixante, mais au début des années soixante-dix les inquiétudes environnementales font leur apparition. Les « modèles d’évaluation intégrés » ont de l’épargne endogène à la Solow et précisent l’arbitrage entre croissance économique et changement climatique, mais met aussi en évidence l’importance critique du taux d’escompte social et des micro-estimations du coût d’ajustement au changement climatique. (…)

Martin Sandbu affirme qu’au cours de notre existence, les changements technologique et environnemental ont transformé la façon par laquelle nos économies fonctionnent. La prochaine fois que nous nous émerveillerons à propos de notre application de smartphone favorite ou que nous nous inquiéterons de la plus grande fréquence des intempéries, affirme Sandbu, nous devrons avoir une pensée pour Romer et Nordhaus. Grâce à eux, nous sommes mieux armés pour trouver les bonnes politiques pour traiter avec la question de l’innovation ou du changement climatique. Ils méritent leur prix.

Peter Dorman a voulu parler d’une personne qui n’a pas reçu le prix Nobel et dont l’absence de consécration est lourde de signification. Nordhaus a passé plusieurs années à débattre avec Martin Weitzman, qui rejetait l’approche en termes de coût social du carbone au motif qu’une bonne politique doit se baser sur le principe d’assurance visant à éviter le pire scénario. Son "théorème lugubre" démontre que, sous certaines hypothèses, la probabilité d’événements extrêmes ne baisse pas aussi rapidement que s’élève de catastrophe augmente, si bien que leur coût attend s’accroît sans limite ; et cela s’applique aux scénarii du changement climatique.

Les travaux de Weitzman sont souvent invoqués par ceux qui croient qu’une action plus agressive est nécessaire pour limiter le réchauffement climatique. Par conséquent, quand les économistes spéculaient sur l’identité du prochain lauréat du prix Nobel et considéraient l’hypothèse d’une attribution de la récompense à Nordhaus, ils pensaient que Weitzman serait son colistier. Selon Dormans, le combo Nordhaus-Romer est si artificiel et si peu convaincant qu’il est difficile de penser que le prix qui n’a pas été attribué à Weitzman est aussi important que celui qui a été attribué à Nordhaus et qu’il s’agit clairement d’un message politique sur la bonne façon de gérer le changement climatique et la mauvaise façon de gérer le changement climatique.

Timothy Terrell n’est pas du même avis. Il pense que le comité Nobel a promu la réglementation environnementale avec son dernier choix. Les deux lauréats appellent à un plus grand rôle pour l’Etat : Romer lorsqu’il suggère que le gouvernement doit investir dans la recherche-développement et utiliser la réglementation des brevets pour stimuler la croissance économique ; Nordhaus lorsqu’il indique que le gouvernement doit agir pour empêcher un changement climatique pernicieux. (…)

David Warsh affirme que Nordhaus et Romer ont beau avoir travaillé sur des problèmes apparemment différents et n’ont que rarement été cités ensemble, leurs travaux se combinent pour donner lieu à un argument convaincant. En s’efforçant de modéliser le plus finement possible l’interaction entre la présence de carbone dans l’atmosphère, le changement climatique et la croissance économique, Nordhaus a rendu possible l’estimation des dommages provoqués par la hausse des températures. Une taxe carbone (que Nordhaus et bien d’autres économistes considèrent comme préférable au système de marchés de droits à polluer comme celui de l’Accord de Paris) peut empêcher les dommages les plus sérieux : elle doit tout d’abord être fixée à un faible niveau pour ensuite augmenter et ce tant qu’il le faut pour contenir les dommages. Romer, de son côté, a créé un cadre analytique dans lequel l’anticipation d’une telle taxe conduit à une vague d’innovations qui permettraient de réduire les émissions de carbone. (…)

Noah Smith écrit que, en plus d’honorer deux chercheurs dont les contributions ont profondément influencé leur champ respectif, la récompense fait écho à quelque chose dont le monde commence à manquer, en l’occurrence la croissance économique. Dans la mesure où la croissance ralentit et où la productivité stagne dans le monde riche, les intuitions de Romer sont plus importantes que jamais. »

Silvia Merler, « The 2018 Nobel prize: Growth and the environment », in Bruegel (blog), 15 octobre 2018. Traduit par Martin Anota

aller plus loin... lire le résumé des travaux de Nordhaus et Romer par l'Académie des sciences de Suède et la synthèse d'Alexandre Delaigue

Tag - Paul Romer

jeudi 18 octobre 2018

La croissance et l’environnement au menu du prix Nobel d’économie 2018

Par Martin Anota le jeudi 18 octobre 2018, 13:00 - Epistémologie et histoire de la pensée

lundi 8 octobre 2018

Innovation, croissance et changement climatique. Petit résumé des travaux de Nordhaus et Romer

Par Martin Anota le lundi 8 octobre 2018, 14:40 - Epistémologie et histoire de la pensée

« Le prix en sciences économiques de cette année récompense la conception de méthodes qui contribuent à répondre à certains enjeux les plus fondamentaux et pressants de notre époque : la croissance soutenable à long terme de l’économie mondiale et du bien-être de la population mondiale.

L’étude de la façon par laquelle l’humanité gère des ressources limitées est au cœur de la science économique et, depuis sa constitution comme science, l’économie a reconnu que les plus importantes contraintes sur les ressources concernent la Nature et le savoir. La Nature dicte les conditions dans lesquelles nous vivons et le savoir définit notre capacité à gérer ces conditions. Cependant, malgré leur rôle central, les économistes n’ont généralement pas étudié comment la Nature et le savoir sont affectés par les marchés et les comportements économiques. Les lauréats de cette année, Paul M. Romer et William D. Nordhaus, ont élargi le champ de l’analyse économique en concevant des outils qui nous permettent d’examiner comment l’économie de marché influence à long terme la Nature et le savoir.

Le savoir. Pendant plus d’un siècle, l’économie mondiale a crû à un rythme remarquable et assez régulier. Quand quelques pourcents de croissance économique par an s’accumulent sur plusieurs décennies, voire plusieurs siècles, cela bouleverse vraiment la vie des gens. Cependant, la croissance a progressé bien plus lentement durant l’essentiel de l’histoire humaine. Elle varie aussi d’un pays à l’autre. Donc, qu’est-ce qui explique pourquoi la croissance survient à un tel moment et à tel endroit ? La réponse qu’avancent habituellement les économistes est le progrès technique, à travers lequel des volumes croissants de savoirs sont incarnés dans les technologies créées par des inventeurs, des ingénieurs et des scientifiques. Au début des années quatre-vingt, quand il était un étudiant en doctorat à l’Université de Chicago, Paul Romer a commencé à développer la théorie de la croissance endogène, où les avancées technologiques ne proviennent pas simplement de sources externes – exogènes -, comme le supposaient jusqu’alors les modèles économiques. En fait, elles sont créées par des activités marchandes. Les constats de Romer nous permettent de mieux comprendre quelles sont les conditions de marché qui favorisent la création de nouvelles idées pour des technologies rentables. Ses travaux nous aident à concevoir des institutions et des politiques qui peuvent améliorer la prospérité humaine en instaurant les bonnes conditions pour le développement technologique.

La Nature. William Nordhaus a commencé ses travaux dans les années soixante-dix, après que les scientifiques aient commencé à se préoccuper à l’idée que la combustion des énergies fossiles puisse entraîner un réchauffement climatique et des effets pernicieux d’un tel changement climatique. Nordhaus s’est donné la tâche immense d’examiner les liens de causalité bidirectionnels entre l’activité humaine et le climat, en combinant théories fondamentales et résultats empiriques tirés de la physique, de la chimie et de l’économie. Il n’a donc pas simplement considéré la Nature comme une contrainte sur l’activité humaine, mais il a également pris en compte le fait que la première soit en retour grandement influencée par cette dernière. Nordhaus est la première personne à concevoir des modèles simples, mais dynamiques et quantitatifs, du système économique-climatique mondial, désormais appelés "modèles intégrés d’évaluation" (integrated assessment models, IAM). Ses outils nous permettent de simuler comment l’économie et le climat évolueront dans le futur selon des hypothèses alternatives à propos des fonctionnements de la Nature et de l’économie de marché, notamment à propos des politiques mises en œuvre. Ses modèles apportent des réponses à des questions à propos de la désirabilité de différents scénarii mondiaux et différentes interventions politiques.

Les imperfections dans le marché mondial. Les deux lauréats ont mis en lumière les effets de débordement (spillover effects) dans la société, c’est-à-dire les conséquences sur autrui qui ne sont pas prises en compte par les individus, notamment les innovateurs et les pollueurs. Toute idée de nouvelle technologie, qu’importe là où elle apparaît, peut être utilisée pour la production de nouveaux biens et de nouvelles idées ailleurs, aujourd’hui ou dans le futur. De même, l’émission d’une unité supplémentaire de carbone se diffuse rapidement dans l’atmosphère et contribue au changement climatique, affectant toute l’humanité aujourd’hui et dans le futur. Les économistes parlent d’"externalités" pour qualifier ces effets de débordement. Les externalités étudiées par Romer et Nordhaus ont une portée mondiale et des conséquences à long terme. Comme les marchés non régulés vont générer des conséquences inefficaces en présence de telles externalités, le travail de Romer et de Nordhaus fournit des arguments convaincants pour l’intervention publique.

L’innovation technologique

Motivation. Les différences de long terme dans les taux de croissance ont d’énormes conséquences. Si deux économies commencent avec le même PIB par tête, mais que l’une d’entre elles croît à un rythme annuel supérieur de 4 points de pourcentage à la seconde, alors elle sera presque cinq fois plus riche que la seconde au bout de 40 ans. Un modeste écart de croissance de 2 points de pourcentage permet à la première économie d’être deux fois plus riche que la seconde au bout de 40 ans.

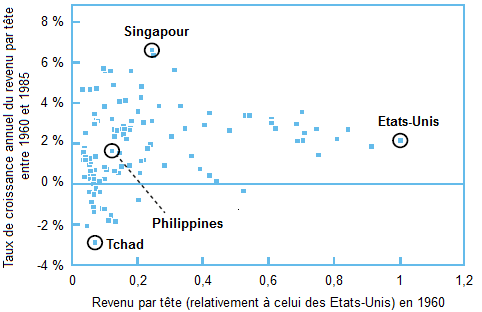

A la fin des années quatre-vingt, Romer a constaté que les taux de croissance du revenu dans les données observées variaient grandement d’une économie à l’autre. Le graphique 1, basé sur l’un des articles de Romer, représente le revenu par tête en 1960 et la croissance moyenne pour les 25 années suivantes pour plus de 100 pays ; un graphique avec des données actualisées lui ressemblerait fortement. Chaque carré représente un pays. Comme le graphique le montre, les écarts de taux de croissance typiques entre des pays s’élevaient à plusieurs points de pourcentage et il y a un grand écart (autour de 10 points de pourcentage) entre les pays ayant la plus forte croissance et les pays ayant la plus faible croissance. De plus, le graphique ne montre pas de relation systématique entre le revenu initial et la croissance : certains pays pauvres croissent rapidement, tandis que d’autres décroissent. Romer en conclut qu’il était crucial de comprendre les causes de tels écarts persistants et significatifs entre les taux de croissance et il commença à rechercher une explication.

GRAPHIQUE Revenu par tête (relativement à celui des Etats-Unis) et croissance annuelle subséquente du revenu par tête

source : Romer (1987)

Des zones d’ombre empiriques et théoriques. Comme Romer l’a noté, la théorie de la croissance qui dominait à l’époque (le modèle de croissance de Solow, qui fut couronnée par le prix Nobel de sciences économiques en 1987) pouvait expliquer plusieurs aspects de la croissance économique, mais pas des écarts amples et durables dans les taux de croissance entre les pays. Le modèle de Solow prédit que les pays les plus pauvres devraient croître plus rapidement les pays riches et rattraper ces derniers assez rapidement, ce qui n’est pas ce que suggère le graphique 1. Dans ce modèle, une économie peut croître en accumulant du capital physique, par exemple des machines ou des infrastructures, mais la croissance tirée par le capital peut s’essouffler à long terme ; pour toute technologie donnée, tout supplément de capital accroît de moins en moins la production. Pour qu’il y ait une croissance durable à long terme (et des écarts de croissance) dans le modèle, l’hypothèse était que les travailleurs deviennent de plus en plus productifs grâce aux avancées technologiques, bien qu’à des rythmes différents d’un pays à l’autre. Par conséquent, le modèle de Solow n’explique pas ces tendances, parce que les changements technologiques n’y arrivent que de façon exogène, depuis une "boîte noire".

L’une des percées majeures de Romer est d’avoir ouvert cette boîte noire et d’avoir montré comment les idées pour les nouveaux biens et services (produits par de nouvelles technologies) peuvent être créées dans l’économie de marché. Il a aussi montré comment un tel changement technologique endogène peut influencer la croissance économique et quelles politiques sont nécessaires pour que ce processus fonctionne bien. Les contributions de Romer ont eu un énorme impact dans le champ de la science économique. Ses explications théoriques ont posé les fondations pour la recherche sur la croissance endogène et les débats suscités par ses comparaisons internationales de croissance ont ouvert la voie à de nouvelles et prometteuses recherches empiriques.

Qu’y a-t-il de spécial à propos de la croissance tirée par les idées ? Pour répondre à cette question, nous devons comprendre comment les idées diffèrent des biens comme le capital physique ou du capital humain. Romer nous apprend à considérer les biens en utilisant deux dimensions (…).

Dans la première dimension, le capital physique et le capital humain sont des biens rivaux. Si une machine ou un ingénieur formé sont utilisés dans une usine, cette machine ou cet ingénieur ne peuvent être utilisés simultanément dans une autre usine. Par contre, les idées sont des biens non rivaux : une personne ou une entreprise utilisant une idée n’empêchent pas les autres de l’utiliser également.

Dans la seconde dimension, ces biens peuvent être excluables (ou exclusifs) si les institutions ou régulations permettent d’empêcher quelqu’un de les utiliser. Pour certaines idées, telles que les résultats tirés de la recherche fondamentale, c’est difficile, voire impossible : pensez à des outils mathématiques comme le théorème de Pythagore. Pour d’autres idées, cependant, les utilisateurs peuvent être exclus via des mesures techniques (telles que le cryptage) ou la réglementation des brevets. L’un des articles de Romer a montré comment la rivalité et l’excluabilité des idées déterminaient la croissance économique.

Romer croyait qu’un modèle de marché pour la création d’idées devait prendre en compte le fait que la production de nouveaux biens (qui se base sur les idées) puisse avoir des coûts déclinant rapidement : la première ébauche a un énorme coût fixe, mais la réplication a de faibles coûts marginaux. Une telle structure des coûts implique que les entreprises doivent avoir une marge, c’est-à-dire fixer le prix au-dessus du coût marginal, de façon à ce qu’elles puissent récupérer le coût fixe initial. Les entreprises doivent donc avoir un certain pouvoir de monopole, ce qui n’est possible que pour des idées suffisamment excluables. Romer a aussi montré que la croissance tirée par l’accumulation d’idées, à la différence de la croissance tirée par l’accumulation de capital physique, ne présente pas forcément de rendements décroissants. En d’autres termes, la croissance tirée par les idées peut rester soutenue à long terme.

Les imperfections de marché et la politique économique. En principe, le nouveau savoir créé par une recherche-développement fructueuse peut profiter aux entrepreneurs et aux innovateurs partout dans le monde, maintenant et dans le futur. Cependant, les marchés ne récompensent en général pas totalement les créateurs de nouveaux savoirs pour tous les bénéfices de leurs innovations, ce qui signifie que (aussi longtemps que le nouveau savoir est socialement bénéfique), il y aura trop peu de recherche-développement. De plus, comme les incitations de marché pour la recherche-développement prennent la forme de profits de monopole, il n’y aura typiquement pas de provision adéquate de nouvelles idées une fois qu’elles auront été inventées. La recherche subséquente a montré comment les résultats de marché peuvent aussi entraîner trop de recherche-développement : soit lorsque les nouvelles idées conduisent à l’éviction de trop nombreuses entreprises existantes lors du processus de destruction créatrice, soit lorsque les nouvelles idées augmentent les technologies socialement néfastes, par exemple en permettant une extraction ou un usage excessifs de carburants fossiles, ce qui nuit au climat.

Pour résumer, Romer a montré que des marchés non régulés vont générer un changement technologique, mais qu’ils tendent à ne pas fournir assez de recherche-développement, donc pas assez de nouveaux biens. Pour répondre à cette insuffisance, il faut des interventions publiques bien conçues, comme les subventions à la recherche-développement et la réglementation des brevets. Son analyse dit que de telles politiques sont vitales pour la croissance à long terme, pas simplement dans un pays, mais au niveau mondial. Elle fournit aussi un guide pour la conception des politiques : le système de brevets doit parvenir à établir un bon équilibre entre les incitations à créer de nouvelles idées (en accordant à leurs concepteurs certains droits au monopole) et la capacité des autres à les utiliser (en limitant ces droits au monopole dans le temps et dans l’espace).

Le changement climatique

L’activité humaine a contribué à une hausse rapide des températures mondiales moyennes au cours du dernier siècle. Même s’il y a une certaine ’incertitude autour de l’ampleur à laquelle cela va affecter le climat dans le futur, le consensus en sciences naturelles est que ce sera "selon toute probabilité un impact significatif".

Motivation. Dans les années soixante-dix, quand il était un jeune étudiant à l’Université de Yale, William Nordhaus a étudié en profondeur les données naissantes sur le réchauffement climatique et ses causes probables et il en conclut qu’il devait faire quelque chose. Sa crainte l’a amené à développer de nouveaux outils pour nous aider à comprendre comment l’économie peut générer un changement climatique, ainsi que les conséquences sociétales du changement climatique. Il voulait développer un cadre qui permette d’analyser le changement climatique en termes de coûts et bénéfices.

Un défi de taille. Comme Romer, Nordhaus étendit le modèle de croissance de Solow avec un important ensemble d’effets de débordement en incluant le réchauffement climatique provoqué par les émissions de carbone. Dans ce cas, les externalités en question étaient essentiellement négatives. Surtout, les mécanismes et causes du changement climatique anthropique impliquent des processus étudiés dans les sciences naturelles. Une analyse globale du changement climatique requiert donc une approche vraiment intégrée, dans laquelle la société et la Nature interagissent.

Prenant conscience de la nécessité d’une telle approche, Nordhaus est à l’origine du développement des modèles intégrés d’évaluation (integrated assessment models). (…)

Des recommandations en matière de politique. Selon les travaux de Nordhaus, le remède le plus efficace pour les problèmes provoqués par les émissions de gaz à effet de serre serait un dispositif mondial de taxes carbone qui soient imposées uniformément dans tous les pays. Cette recommandation s’appuie sur un résultat formulé dans les années soixante par un économiste britannique, Arthur Cecil Pigou, à savoir que chaque émetteur paye le coût social du dommage provoqué par ses émissions via un prix approprié. Un système mondial de droits d’émission peut parvenir au même résultat, à condition que les quotas soient fixés à un niveau suffisamment faible pour entraîner un prix du carbone suffisamment élevé.

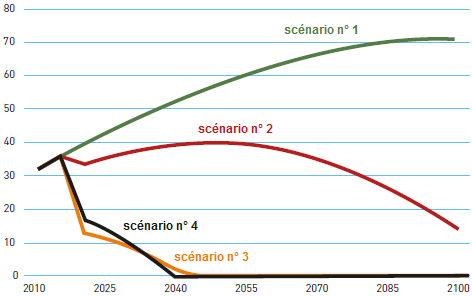

Cependant, les modèles IAM ne fournissent pas seulement des résultats qualitatifs. Ils nous permettent de calculer des trajectoires quantitatives pour la meilleure taxe carbone et montrent comment ces trajectoires dépendent crucialement d’hypothèses à propos des paramètres : par exemple, la sensibilité de la température mondiale à la concentration de carbone dans l’atmosphère, la durée pendant laquelle celui-ci reste dans l’atmosphère et l’ampleur des dommages provoqués par le changement climatique. Une récente étude de Nordhaus offre une bonne illustration de la façon par laquelle les modèles IAM peuvent être utilisés pour analyser la politique. Il simule quatre politiques dans la dernière version de son modèle DICE en utilisant les meilleures estimations pour les paramètres du changement climatique :

GRAPHIQUE Emissions de CO2 (en gigatonnes par an) selon différents scénarii

Dans le scénario n° 1, il n’y a pas de mesures de politique climatique de plus que celles déjà en place en 2015. Dans le scénario n° 2, les taxes carbone maximisent le bien-être mondial, selon des hypothèses économiques conventionnelles à propos de l’importance du bien-être des générations futures. Dans le scénario n° 3, les taxes carbone maximisent le bien-être mondial en donnant un plus grand poids au bien-être des générations futures que dans le scénario n° 2, comme le suggère The Economics of Climate Change: The Stern Review de 2007. Dans le scénario n° 4, les taxes carbone sont suffisamment élevées pour maintenir le réchauffement climatique en-deçà des 2,5°C tout en réduisant le coût en bien-être mondial.

Le graphique montre l’évolution des émissions de CO2 au cours du temps dans chacun de ces quatre scénarii. Les différentes trajectoires pour les taxes carbone signifient que les émissions (et donc l’ampleur du changement climatique) sont très différentes d’un scénario à l’autre. Dans le scénario n° 2, les taxes débutent à environ 30 dollars la tonne de CO2 et augmentent au cours du temps à peu près au même rythme que le PIB mondial. Dans les scénarii n° 3 et 4, qui simulent des réductions d’émissions plus fortes, les taxes sont six à huit fois plus importantes.

De grandes incertitudes. Dans les sciences naturelles et dans les sciences sociales, il y a des incertitudes à propos de plusieurs aspects du changement climatique. Par exemple, nous ne savons pas exactement à quel point le climat est sensible aux émissions de gaz à effet de serre ou quel est la probabilité que l’on atteigne un point tournant mondial au-delà duquel le climat échappe à tout contrôle. De même, nous ne savons pas tout à propos des dommages économiques et humains provoqués par le changement climatique et du coût de la décarbonisation.

Naturellement, les IAM développés par Nordhaus ne peuvent éliminer cette incertitude. Cependant, ses modèles peuvent analyser comment le prix approprié du carbone est affecté par différentes possibilités, par exemple une plus forte sensibilité du climat ou une plus forte probabilité d’un point tournant mondial dangereux à 2° C de réchauffement. (...) »

Académie royale des sciences de Suède, « Integrating nature and knowledge into economics », 8 octobre 2018. Traduit par Martin Anota

mercredi 28 septembre 2016

Wren-Lewis, les microfondations et la critique de Romer

Par Martin Anota le mercredi 28 septembre 2016, 16:00 - Epistémologie et histoire de la pensée

Paul Romer sur la macroéconomie

« C’est ironique de voir que le projet des microfondations, qui devait faire de la macroéconomie une autre application de la microéconomie, a laissé la macroéconomie avec très peu d’amis parmi les autres économistes. La dernière diatribe en date vient de Paul Romer. Oui, elle est injuste et, oui, elle est truffée de passages peu convaincants, mais il ne sera pas ignoré par ceux qui sont en-dehors de la macroéconomie orthodoxe. C’est en partie parce qu’il discute de questions sur lesquelles la macroéconomie moderne est extrêmement vulnérable.

La première vulnérabilité est son traitement des données. Ce que dit Paul sur l’identification montre que la macroéconomie a besoin d’utiliser toutes les informations précises dont elle a à disposition pour paramétrer ses modèles. Pourtant, les modèles microfondés, les seuls modèles que l’on considère comme acceptables dans les revues les plus prestigieuses pour l’analyse théorique comme pour l’analyse empirique, sont normalement plutôt sélectifs en ce qui concerne les données sur lesquelles ils se focalisent. Les preuves empiriques tant micro que macro sont soit ignorées parce qu’elles sont considérées comme gênantes, soit inscrites sur une liste de choses à faire pour de futures recherches. C’est une conséquence inévitable lorsque l’on fait de la cohérence interne un critère d’admissibilité pour qualifier un travail de publiable.

La seconde vulnérabilité est un conservatisme qui découle de sa méthodologie. Le critère des microfondations pris dans sa forme stricte rend certains processus impossibles à modéliser : par exemple, modéliser les prix visqueux où les coûts de menus constituent un paramètre clé. Plutôt, la modélisation DSGE utilise des astuces, comme les contrats de Calvo. Mais qui décide si ces astuces représentent des microfondations acceptables ou bien des éléments ad hoc, voire invraisemblables ? La réponse dépend pour beaucoup des conventions en vigueur parmi les macroéconomistes or, comme toutes les conventions, celles-ci évoluent lentement. A nouveau, c’est un problème qui découle de la méthodologie des microfondations.

Les propos que Romer tient à propos des effets réels de la politique monétaire et de l’insistance que certains portent aux chocs de productivité comme moteurs des cycles d’affaires sonnent datés. (…). Pourtant il fallut beaucoup de temps pour que les modèles de cycles d’affaires réels soient remplacés par les modèles des nouveaux keynésiens et vous verrez toujours des modèles de cycles d’affaires réels. Des éléments issus de la contre-révolution néoclassique des années quatre-vingt persistent toujours dans certains lieux. Il y a quelques années j’ai entendu parler à un séminaire d’une analyse où la crise financière était modélisée comme un large choc négatif de productivité.

C’est seulement dans une discipline qui considère qu’avoir de robustes microfondations constitue la seule manière acceptable de modéliser que des praticiens se sentent peu à l’aise à l’idée d’inclure les prix visqueux au motif que leurs microfondations (les astuces mentionnées ci-dessus) soient problématiques. C’est seulement dans cette discipline que des chercheurs respectés affirment qu’en raison de ces piètres microfondations il vaut mieux ignorer quelque chose comme les prix visqueux quand il s’agit de travailler sur les politiques, un argument qui ferait bien rire si on l’entendait dans une autre discipline scientifique. C’est la seule discipline où l’on débat pour déterminer s’il vaut mieux modéliser ce que l’on peut microfonder plutôt que modéliser ce que l’on voit. D’autres économistes comprennent le problème, mais plusieurs macroéconomistes pensent toujours que tout cela est assez normal. »

Simon Wren-Lewis, « Paul Romer on macroeconomics », in Mainly Macro (blog), 20 septembre 2016. Traduit par Martin Anota

Qu’est-ce qui ne va pas avec le modèle des cycles d’affaires réels ?

« Les modèles DSGE, les modèles que les macroéconomistes orthodoxes utilisent pour modéliser les cycles d’affaires, sont fondés sur le modèle des cycles d’affaires réels. Nous savons (presque) tous que le projet des cycles d’affaires réels a échoué. Donc pourrait-on trouver acceptable d’avoir quelque chose qui se fonderait sur un tel modèle ? Comme le dirait Donald Trump, que se passe-t-il ?

Le modèle de cycles d’affaires réels de base contient une fonction de production reliant la production au capital (possédé par les individus) et au travail plus un élément stochastique représentant le progrès technique, une identité reliant l’investissement et le capital, une identité du revenu national posant la production comme la somme de la consommation et de l’investissement, les conditions de productivité marginale (découlant de la maximisation du profit par des entreprises représentatives en environnement parfaitement concurrentiel) donnant le salaire réel et le taux d’intérêt réel et le problème d’optimisation du consommateur représentatif pour la consommation, l’offre de travail et le capital.

Quel est le gros problème avec ce modèle ? (…) Ignorons le capital, parce que dans le modèle canonique des nouveaux keynésiens le capital n’apparaît pas. Si vous dites que c’est le rôle proéminent conféré aux chocs associés au progrès technique, je vous dirais que je suis d’accord pour dire que c’est un gros problème : toutes les équations comportementales doivent contenir des événements stochastiques qui peuvent aussi générer un choc dans cette économie, mais les modèles des nouveaux keynésiens le font à divers degrés. Si vous dites que c’est l’hypothèse d’équilibrage du marché du travail, je vous dirais que c’est aussi un gros problème.

Cependant, à mes yeux, rien de tout cela ne constitue le plus grand problème avec le modèle des cycles d’affaires réels. Le plus gros problème, c’est l’hypothèse d’ajustement continu des marchés des biens et services, autrement dit l’hypothèse de prix pleinement flexibles. C’est l’hypothèse qui amène à conclure que la politique monétaire n’a pas d’impact sur les variables réelles. Maintenant, un modélisateur de cycles d’affaires réels pourrait répondre : comment le savez-vous ? Sûrement qu’il fait sens de voir si un modèle qui suppose une flexibilité des prix peut générer quelque chose comme des cycles d’affaires ?

La réponse à cette question est non, il ne le fait pas. Il ne le fait pas parce que nous savons qu’il ne le peut pas pour une simple raison : le chômage lors d’une récession est involontaire et ce modèle ne peut générer de chômage involontaire, mais seulement des variations volontaires de l’offre de travail, en conséquence des variations à court terme du salaire réel. Une fois que vous acceptez le fait que le chômage lors des récessions est involontaire (et les preuves empiriques en faveur d’une telle idée sont très robustes), vous comprenez pourquoi le projet des cycles d’affaires réels ne marche pas.

Donc pourquoi les modèles de cycles d’affaires réels n’ont-ils jamais décollé ? Parce que la révolution des nouveaux classiques a prétendu que toutes les choses que nous connaissions avant elle devaient être écartées au motif qu’elles ne s’appuyaient pas sur la bonne méthodologie. Mais aussi parce que la bonne méthodologie, en l'occurrence la méthodologie des microfondations, permit au chercheur de sélectionner quelles preuves empiriques (micro ou macro) étaient admissibles. Cela, à son tour, explique pourquoi la méthodologie des microfondations s’est retrouvée au centre de toute critique de la macroéconomie moderne. Je laisse sous silence pourquoi les modélisateurs de cycles d’affaires réels ont écarté les preuves empiriques montrant que le chômage est involontaire.

Le modèle des nouveaux keynésiens, bien qu’il n’ait peut-être ajouté qu’une seule équation au modèle des cycles d’affaires réels, a réussi à corriger sa principale faille : son échec à reconnaître le savoir prérévolutionnaire à propos de ce qui provoque les cycles d’affaires et de ce que vous devez faire pour les combattre. Dans ce sens, le fossé qu’il a creusé avec l’héritage qu’il tire de la théorie des cycles d’affaires réels a été profond. Est-ce que l’analyse des nouveaux keynésiens est toujours entravée par sa filiation avec la théorie des cycles d’affaires réels ? La réponse est complexe (voir par exemple ici) et elle tient à la fois du oui et du non. Mais à nouveau, je serais plutôt enclin à affirmer que ce qui entrave davantage les avancées de la macroéconomie moderne est sa dépendance à une méthodologie très particulière.

Un dernier point. Beaucoup de personnes en dehors de la macroéconomie orthodoxe aiment décrire la modélisation DSGE comme une stratégie de recherche dégénérative. Je pense que c’est une affirmation très difficile à étayer et qu’elle n’est pas convaincante aux yeux des économistes orthodoxes. Ce que j’affirme par contre, (…) c’est qu’il n’y a pas de bonne raison justifiant pourquoi la modélisation des microfondations devrait être la seule stratégie de recherche employée par les économistes universitaires. Je mets au défi quiconque de mettre en doute cette idée. »

Simon Wren-Lewis, « What is so bad about the RBC model? », in Mainly Macro (blog), 20 août 2016. Traduit par Martin Anota

mardi 19 mai 2015

Paul Romer et les microfondations

Par Martin Anota le mardi 19 mai 2015, 15:59 - Epistémologie et histoire de la pensée

« Dans un récent article de l’American Economic Review, Paul Romer parle de beaucoup de choses : d’une distinction entre le consensus scientifique et le discours politique, d’une division au sein de la théorie de la croissance entre ceux qui utilisent des modèles basés sur la concurrence parfaite et ceux qui utilisent la concurrence imparfaite, mais aussi et surtout de la distinction entre la théorie mathématique appropriée et ce qu’il appelle le "mathisme" (mathiness). Pour mieux comprendre comment ces choses sont liées entre elles et pourquoi elles sont importantes, je vous invite à lire tout d’abord son billet en premier. Il y écrit :

"Les problèmes que j’ai identifié dans la théorie de la croissance peuvent se révéler d’un réel intérêt pour le reste de la discipline. Si les économistes peuvent comprendre quels sont les problèmes dans ce champ, nous serrons mieux armés pour évaluer la santé scientifique des autres domaines de l’économie. Le champ auquel l’analyse pourra être immédiatement étendue sera celui des fluctuations économiques."

Que nous amènerait à dire une telle comparaison ? L’inclinaison à utiliser la concurrence pure et parfaite plutôt que la concurrence parfaite peut traduire soit une aversion à la viscosité des prix, soit une aversion à reconnaître l’importance de la demande agrégée, deux attitudes que l’on peut qualifier d’"anti-keynésiennes". La théorie keynésienne est rejetée dans certains cas, non pas parce qu’elle se concilie mal avec les données empiriques, mais en raison de ses implications politiques. La méthodologie des microfondations, telle qu’elle est pratiquée par certains, permet à ceux qui veulent dénier l’importance des effets keynésiens de continuer d’étudier les cycles d’affaires, parce que cette méthodologie permet de négliger les preuves empiriques pour construire le modèle. (Ne demandez pas si la viscosité des prix est vérifiée empiriquement, mais si elle a de solides microfondations.)

L’article de Paul Romer est aussi lié à la réflexion de Paul Pfleiderer à propos des modèles théoriques qu’il qualifie de "caméléon". Selon lui, "un modèle devient un caméléon lorsqu’il est fondé sur des hypothèses qui semblent difficilement vérifiées dans le monde réel, mais dont les conclusions sont retenues (…) pour expliquer notre économie". Je pense que nous pouvons ajouter que ces conclusions sont habituellement associées à la défense d’une vision politique particulière ou d’intérêts particuliers.

Il est important de souligner que ce n’est pas une remise en question de la méthodologie des microfondations, tout comme l’article de Paul Romer n’est pas une attaque contre la modélisation mathématique. La plupart des concepteurs de modèles DSGE, qui ne sont pas sujets à une quelconque aversion politique à utiliser la rigidité des prix, utilisent joyeusement cette méthodologie pour faire avancer la discipline. Mais si cette méthodologie est prise trop sérieusement (par ce que j’appelle les « puristes des microfondations »), les modélisateurs risquent de se contenter d’observer ce qu’ils peuvent microfonder plutôt que le monde réel, si bien qu’ils sont susceptibles de développer des idées qui auraient dû être écartées, mais qui permettent de soutenir une position politique particulière.

Une discipline où il y a de nombreux modèles alternatifs peut être décrite comme "florissante", mais elle risque de se désagréger en diverses écoles de pensées et certaines écoles peuvent avoir une stratégie d’immunisation les amenant à ignorer certaines preuves empiriques. Comme Paul le note, cela rapproche davantage l’économie du discours politique que d’une discipline scientifique. Certains apprécient cette tendance ou la considèrent comme inévitable ; j’espère que ce n’est pas le cas de la majorité des économistes. Cela signifie que nous devons tout d’abord reconnaître le problème, plutôt que de fermer les yeux pour ne pas contrarier certains. J’espère que l’article de Paul Romer contribuera à cela. »

Simon Wren-Lewis, « Paul Romer and microfoundations », in Mainly Macro (blog), 16 mai 2015. Traduit par Martin Anota

aller plus loin... lire le billet d'Anne Lavigne