« Les adeptes de la MMT disent souvent que financer les dépenses publiques (moins les impôts) en émettant de la dette publique est un choix politique, car on pourrait plutôt créer des réserves (monnaie électronique) auprès des banques commerciales. Bien entendu, seuls les gouvernements qui disposent de leur propre monnaie peuvent le faire, cette option n’est donc pas disponible pour les gouvernements de la zone euro par exemple. Si les gouvernements pouvaient financer les déficits en créant de la monnaie/des réserves, voudraient-ils le faire ?

La réponse que l’on pourrait trouver dans les manuels est que le financement monétaire est inflationniste. C'est pourquoi la plupart des gouvernements délèguent la création de réserves à des banques centrales indépendantes. Cela ne tient pas à un monétarisme crû : dans le courant orthodoxe en macroéconomie, l’idée selon laquelle il existe un lien de causalité prévisible allant de la création monétaire à l’inflation est morte il y a plusieurs décennies, et aujourd’hui seule une poignée de personnes y croient. Au lieu de cela, on trouve dans les manuels l’idée selon laquelle une création de monnaie par les gouvernements nuirait à la capacité des banques centrales à contrôler les taux d’intérêt à court terme. Le financement monétaire pousserait les taux d’intérêt à zéro, ce qui serait inflationniste.

Cependant, les manuels sont presque toujours obsolètes et cette explication du caractère inflationniste du financement monétaire est devenue largement hors de propos lorsque les banques centrales ont commencé à payer des intérêts sur les réserves. Les réserves sont comme de la monnaie électronique détenue par les banques commerciales et leur quantité est contrôlée par les banques centrales. Aujourd’hui, les banques centrales contrôlent les taux d’intérêt à court terme en payant ces taux d’intérêt sur les réserves. En conséquence, il est possible de créer d’importantes quantités de monnaie/réserves sans que cela n’entraîne une hausse de l’inflation.

Nous le savons avec l’assouplissement quantitatif (quantitative easing, QE), par lequel les banques centrales ont créé d’importantes réserves afin d’acheter de la dette publique. Lorsqu’elles ont fait cela après la crise financière mondiale, nous n’avons pas eu d’hyperinflation ! L’idée selon laquelle l’inflation récente est le résultat du nouvel assouplissement quantitatif mis en place pendant la pandémie est tout simplement ridicule. Ce que l’expérience récente nous montre c’est qu’il est parfaitement possible pour les banques centrales de contrôler l’inflation même lorsqu’il y a beaucoup d’argent/de réserves dans le système.

Alors, si les banques centrales peuvent créer de grandes quantités de monnaie tout en contrôlant l’inflation, pourquoi les gouvernements ne peuvent-ils pas financer leurs déficits en créant de la monnaie ? Si des intérêts sont payés sur cette monnaie/ces réserves et si les banques centrales ont un contrôle total sur la fixation de ce taux d’intérêt, il n’y a aucune raison de croire que le financement monétaire des déficits serait plus inflationniste que le financement des déficits par émission d’obligations. C’est ce que la MMT veut dire lorsqu’elle affirme que le

financement obligataire est un choix politique.

Nous pourrions aller plus loin et dire que l’assouplissement quantitatif a été l’équivalent d’un financement monétaire des déficits courants et passés. Que cela soit survenu parce que les banques centrales voulaient faire pression à la baisse sur les taux d’intérêt de long terme et non parce que les gouvernements ont choisi la finance monétaire n’est qu’une question de motifs. En pratique, nous avons fini à peu près au même endroit que si les gouvernements avaient financé leurs déficits à partir d’une certaine date passée en créant des réserves.

Bien sûr, rien de cela n’aurait eu d’importance si les gouvernements n’avaient pas eu de raisons d’être intéressés par le financement monétaire des déficits. La raison évidente expliquant pourquoi ils pourraient y trouver un intérêt est que le financement monétaire était moins cher que l’émission de dette sur le marché obligataire. La création de monnaie/réserves entraîne un coût égal au niveau auquel la banque centrale fixe le taux d’intérêt de court terme. L’émission de dette peut entraîner un coût similaire si cette dette était à très court terme. Cependant, les gouvernements ont l’option (qu’ils prennent généralement) d’émettre des obligations de plus long terme. Cela peut ou non être immédiatement moins cher que de créer de la monnaie/des réserves, selon que les taux d’intérêt de long terme sont supérieurs ou inférieurs aux taux d’intérêt de court terme. Après la crise financière mondiale, les taux de court terme étaient inférieurs aux taux de long terme, donc le financement monétaire aurait été moins cher et l’assouplissement quantitatif était rentable. Actuellement, les taux d’intérêt de long terme sont inférieurs aux taux de court terme, donc le financement obligataire serait moins cher en cet instant. Cependant, à long terme, si l’option d’emprunter à long terme est moins cher pour les gouvernements reste une question ouverte. Ellison et Scott estiment que le Royaume-Uni, qui tend à emprunter à long terme, aurait mieux fait d’emprunter à court terme.

La situation serait claire si les banques centrales payaient seulement des intérêts sur les réserves à la marge, plutôt que de payer des intérêts sur toutes les réserves. Cela permettrait aux banques centrales de continuer de contrôler les taux d’intérêt de court terme, mais aussi de verser substantiellement moins d’intérêts sur le stock total de réserves. J’ai déjà discuté de cette possibilité en détails ici, dans le contexte de la réduction des pertes provoquées par l’assouplissement quantitatif. Une raison supplémentaire de payer des intérêts seulement à certaines réserves est qu’il n’y a pas de raison évidente à ce que les banques commerciales reçoivent de larges sommes de monnaie pour leurs réserves lorsque les taux d’intérêt sont élevés et quasiment rien lorsque les taux sont faibles.

Si les intérêts étaient seulement versés sur des réserves marginales, alors il deviendrait clairement attractif du point de vue des finances publiques de financer les déficits en créant de la monnaie/des réserves plutôt qu’en émettant de la dette. Alors pourquoi les gouvernements n’explorent-ils pas cette possibilité ? Je pourrais également demander pourquoi les économistes orthodoxes ne parlent pas plus de cette possibilité. Peut-être que je manque quelque chose d’évident ici. Si c’est le cas, faites-le moi savoir !

Un possible argument qui, selon moi, ne tient pas est qu’un financement moins coûteux des déficits encouragerait les gouvernements à être dépensiers. La principale dissuasion à la prodigalité budgétaire quand il y a une banque centrale indépendante, ce sont les taux d’intérêt élevés, pas des paiements d’intérêts sur la dette élevés.

J’aimerais finir en faisant deux points additionnels. Le premier porte sur les marchés financiers et le défaut de paiement. Le financement monétaire peut apparaître attractif à ceux qui croient que la finance par endettement contraint les décisions budgétaires du gouvernement. L’idée est que les marchés obligataires pourraient soudainement arrêter de prêter aux gouvernements et cela empêche les politiciens de faire des choix de politique budgétaire optimaux. Si les politiciens pensent ainsi ils se trompent, parce qu’il est improbable (comme je l’ai expliqué ailleurs) que le marché obligataire arrête de prêter au gouvernement et, si cela survenait, la banque centrale agirait en tant qu’acheteur en dernier ressort de la dette publique. C’est ce qui s’est passé pendant la pandémie et après le fameux événement budgétaire de Truss.

Parce que les gouvernements peuvent créer de la monnaie, ils n’ont pas à s’inquiéter à l’idée d’être forcés à faire défaut en conséquence de turbulences sur les marchés obligataires. En outre, le fait que les gouvernements aient un arbre de monnaie magique signifie que les obligataires peuvent toujours obtenir des intérêts et retrouver leur monnaie. Le seul défaut formel que doivent craindre les marchés obligataires est celui que les gouvernements choisissent, parce que le coût politique qu’il y a à assurer le service de la dette publique devient trop élevé. Nous sommes loin de tels niveaux aujourd’hui (...).

Mon second point concerne les actifs sûrs. Parce que les gouvernements des pays développés qui s’endettent dans leur propre monnaie choisissent rarement de faire défaut, la dette qu’ils émettent est bien plus sûre que toute dette que crée le secteur privé. Une telle dette est précieuse pour le secteur financier. Elle apporte aux fonds de pension une plus grande certitude qu’ils pourront verser des pensions à l’avenir, par exemple. Il y a une très bonne raison expliquant pourquoi les gouvernements doivent continuer d’émettre de la dette. Est-ce que cela signifie que les gouvernements doivent toujours financer leurs déficits en utilisant la dette ? Non, parce que les gouvernements peuvent émettre de la dette pour acheter des actifs (via un fonds souverain par exemple) plutôt que financer des déficits. »

Simon Wren-Lewis, « Could governments finance deficits by creating money? », in Mainly Macro (blog), 16 avril 2024. Traduit par Martin Anota

Tag - Simon Wren-Lewis

mercredi 17 avril 2024

Les gouvernements peuvent-ils financer leurs déficits en créant de la monnaie ?

Par Martin Anota le mercredi 17 avril 2024, 10:44 - Politique monétaire

lundi 18 décembre 2023

Quelles leçons pouvons-nous tirer (pour l’instant) de la bulle inflationniste de 2021-2023 ?

Par Martin Anota le lundi 18 décembre 2023, 16:00 - Inflation, déflation

« L'inflation a augmenté, mais à présent elle est en baisse. Pas seulement au Royaume-Uni, mais aussi un peu partout ailleurs. Quelles leçons macroéconomiques pouvons-nous en tirer et quelles questions subsistent encore ? Est-ce que "l’équipe transitoire" (team transitory) avait raison après tout ? Les banques centrales ont-elles été trop lentes à relever leurs taux ? Une fois qu’elles ont commencé à les relever, les ont-elles relevés trop vite ?

Un point préliminaire à souligner est que l’inflation n’est pas le coût de la vie. Une période où l’inflation augmente puis redescend signifie que les prix finissent par être beaucoup plus élevés à la fin de cette période qu’ils ne l’étaient initialement. Ceux dont les revenus n’ont pas suivi l’inflation ont vu leur situation se détériorer, peut-être considérablement. Pour ceux qui avaient déjà du mal à joindre les deux bouts, c’est un très grave problème, qui n’a pas disparu avec la baisse de l’inflation.

Ce qu’il faut maintenant bien comprendre, c’est que cette période de forte inflation n’était pas seulement due aux prix élevés de l’énergie et des produits alimentaires. Il y a eu d’autres problèmes d’approvisionnement qui ont fait monter les prix, mais plus important encore, les tensions sur les marchés du travail dans la plupart des grandes économies étaient également fortes. Presque sans exception, le chômage en 2022 était plus faible qu’à tout autre moment de ce siècle aux États-Unis, en Allemagne, en France et au Royaume-Uni.

Cela signifie que toute augmentation des prix de l’énergie et des produits alimentaires était susceptible d’entraîner une certaine hausse de l’inflation des salaires. Cette dernière aurait à son tour rendu plus persistant le choc inflationniste provoqué par la hausse des prix des produits alimentaires et de l’énergie, car les entreprises qui ne produisent pas d’énergie ou de produits alimentaires répercuteraient une grande partie de l’augmentation du coût du travail sur leurs prix de vente. Pour éviter que cela ne se transforme en une augmentation permanente de l’inflation, les banques centrales aux États-Unis, au Royaume-Uni et dans la zone euro ont augmenté leurs taux directeurs.

Les banques centrales ont-elles été trop lentes pour relever les taux d’intérêt ? Il est important de comprendre que les banques centrales ne peuvent pas et ne doivent pas toujours essayer de maintenir l’inflation à un niveau cible. Lorsque le prix relatif des matières premières augmente, il serait extrêmement préjudiciable d’essayer de réduire tous les autres prix afin que l’inflation globale n’augmente pas. Il devait y avoir une bulle inflationniste en 2021-2023. La question est de savoir si les banques centrales auraient pu la modérer davantage qu’elles ne l’ont fait.

Il est également important de rappeler qu’en 2021, la principale préoccupation était, avec raison, d’assurer une reprise complète après la pandémie. Rares sont ceux qui avaient anticipé l’ampleur du choc inflationniste (c’est-à-dire anticipé que la Russie reprendrait son invasion de l’Ukraine ou qu’il y aurait autant de goulots d’étranglement du côté de l’offre) et, avec la pandémie, il a été plus compliqué de jauger la situation du marché du travail. Mon propre point de vue, et contrairement à beaucoup d’autres (...), est que les banques centrales ont eu raison de retarder la hausse des taux jusqu’en 2022. Une fois qu’elles ont compris que la reprise après la pandémie avait été forte et que, par conséquent, le marché du travail était tendu, elles ont agi en augmentant les taux assez rapidement.

Le fait que l’inflation diminue maintenant assez rapidement suggère que les banques centrales en ont fait suffisamment pour empêcher que le choc sur les prix de l’énergie et des produits alimentaires ne conduise à une inflation durablement plus élevée. Ce que nous ne savons pas encore, c'est si elles en ont fait de trop, car le décalage entre la hausse des taux d'intérêt nominaux et la baisse de l'activité économique peut être assez long (1). Néanmoins nous pouvons souligner un point important.

Lorsque l’inflation était proche de son pic, certains économistes (appelons-les les "pessimistes de l’inflation") affirmaient qu’une période significative d’activité économique déprimée serait nécessaire pour ramener l’inflation à un niveau proche de l’objectif de 2 %. Ce n’est que lorsque le chômage sera nettement plus élevé qu’il ne l’est aujourd’hui, suggèrent-ils, que l’inflation des salaires commencera à retomber vers des niveaux compatibles avec l’objectif de 2 %.

Nous savons maintenant que cet argument est certainement faux. L’inflation des salaires a diminué aux États-Unis et ailleurs sans augmentation significative du chômage. Bien sûr, le chômage peut encore augmenter en raison de l’effet différé de la hausse des taux d’intérêt, mais il est un peu exagéré de suggérer, dans le cas des États-Unis tout du moins, que la baisse de l’inflation des salaires est une réponse aux anticipations d’un chômage supérieur à sa tendance.

Ce qui n’est pas souvent discuté, c’est que la théorie macroéconomique actuelle ne suggère pas qu’une période de chômage significativement plus élevée soit nécessaire pour réduire l’inflation des salaires. En ce sens, les pessimistes de l’inflation pourraient être accusés d’être démodés. L’idée selon laquelle "si cela ne fait pas mal, cela ne marchera pas" vient d’une courbe de Phillips traditionnelle, selon laquelle ceux qui fixent les prix et salaires ne prennent en compte que l’inflation passée lorsqu’ils forment des anticipations quant à l’inflation future. Le point clé lorsqu’une banque centrale tente d’atteindre un objectif d’inflation est que ceux qui fixent prix et salaires prennent en compte les actions de cette banque centrale lorsqu’ils forment leurs anticipations.

Si la banque centrale a de la crédibilité (un mot souvent mal utilisé signifiant simplement ici que les banques centrales réussiront à atteindre leur objectif d’inflation), alors cela ancre les anticipations d’inflation future à la cible d’inflation. Ceux qui fixent les salaires et les prix savent que l’inflation reviendra à 2 % une fois que les chocs inflationnistes auront disparu ou que l’excès de demande aura été éliminé et ils forment donc leurs anticipations en conséquence. Dans cette situation, il n’est pas nécessaire de connaître une période d’excès d’offre de travail (c’est-à-dire de chômage) ou de biens pour faire baisser l’inflation. Pour reprendre un autre cliché macroéconomique très galvaudé, des atterrissages en douceur sont tout à fait possibles et devraient être ce que recherchent les banques centrales.

Bien sûr, les banques centrales peuvent toujours se tromper. Il se peut qu’elles n’en fassent pas assez pour éliminer l’excès de demande, auquel cas l’inflation restera supérieure à la cible. Elles pourraient également en faire trop pour dégonfler la demande, ce qui entraînerait une période d'excès d’offre, ce qui pourrait conduire à une inflation inférieure à sa cible. Cette deuxième possibilité est encore très réelle au Royaume-Uni et en Europe, même si elle semble moins probable aux États-Unis.

Comme le montrent De Grauwe et Yi, il a été beaucoup plus facile de faire baisser l’inflation dans les années 2020 que dans les années 1970. Cela s’explique en partie par le fait que le choc inflationniste a été de plus courte durée (les prix du gaz ont chuté et les perturbations pandémiques dans l’approvisionnement sont terminées, même si les prix des produits alimentaires restent élevés), de sorte qu’une contraction permanente de l’offre n’a pas été nécessaire. Cependant, c’est aussi parce que nous avons désormais des banques centrales indépendantes avec des cibles d’inflation et un historique récent où l’inflation a été proche de la cible (ces banques centrales ont donc de la crédibilité).

Si les pessimistes de l'inflation, qui pensaient qu'une période d’excès d’offre et de chômage plus élevé était nécessaire pour faire baisser l'inflation, se sont trompés, l'équipe transitoire a-t-elle eu raison ? Eh bien, cela dépend de ce que "l’équipe transitoire" a cru et dit. Par souci d’explication, définissons l’équipe transitoire comme désignant ceux qui disaient que l’inflation serait revenue à l’objectif sans la forte augmentation des taux d’intérêt que nous avons connue.

Cette question est difficile à juger, car nous ne savons pas quelle aurait été la trajectoire de l’inflation si les banques centrales n’avaient pas autant augmenté leurs taux directeurs. (…) Beaucoup de choses dépendront de l’évolution de l’activité économique et de l’inflation d’ici un an. Il semble y avoir deux possibilités et il se pourrait que les grandes économies finissent par illustrer les deux cas.

La première possibilité est que l’économie réalise un atterrissage en douceur : l’inflation se rapproche de la cible sans aucun ralentissement économique par rapport à la tendance. Si cela se produit, cela suggère que la hausse des taux d’intérêt était nécessaire et, en ce sens, l’équipe transitoire avait tort (2). La deuxième possibilité est que l’activité économique soit déprimée et que l’inflation soit inférieure à sa cible de 2 %. Dans ce cas, les banques centrales auront exagéré dans leur resserrement monétaire et l’équipe transitoire pourrait bien avoir eu raison.

Tout indique que pour les États-Unis un atterrissage en douceur est plus probable qu’improbable. Si cela se produit, alors les pessimistes de l’inflation et l’équipe transitoire auront eu tort et la Fed (la banque centrale américaine) aura très bien fait. Pour le Royaume-Uni et la zone euro, il est trop tôt pour dire si nous connaîtrons ou non un atterrissage en douceur. Mais aux États-Unis au moins, il semble pour le moment que les experts de la banque centrale soient plutôt meilleurs dans la gestion de l’inflation que de nombreux experts extérieurs. Ce n’est pas une conclusion populaire à ma connaissance, mais elle n’est peut-être pas non plus surprenante.

(1) Cela s’explique en partie par le fait que l’activité économique est influencée par les taux d’intérêt réels (taux nominaux moins inflation anticipée). Ce n’est que maintenant, avec la baisse de l’inflation, que les taux réels deviennent positifs.

(2) Cela suppose que des taux d’intérêt plus élevés réduisent la demande globale. Comme je l’ai soutenu ici, les données empiriques vont dans ce sens. »

Simon Wren-Lewis, « Lessons (so far) from the inflation bubble of 2021-3 », in Mainly Macro (blog), 12 décembre 2023. Traduit par Martin Anota

lundi 20 novembre 2023

La stagnation actuelle de l’Europe s'explique en partie par l'obsession du déficit public

Par Martin Anota le lundi 20 novembre 2023, 16:00 - Politique budgétaire et endettement public

« La règle empirique que les journalistes utilisent pour définir une récession, à savoir la succession de deux trimestres consécutifs de croissance négative du PIB, n’est pas sans inconvénient. Si l’économie croît de 0,1 %, les gros titres diront que "le Royaume-Uni a évité la récession", mais si la croissance est de -0,1 % deux trimestres consécutifs, les gros titres diront que "le Royaume-Uni est entré en récession". Pourtant la différence entre les deux, équivalente à 0,2 % du PIB, est bien dans les erreurs de mesures généralement associées à la croissance du PIB. D’un point de vue économique, il n’y a pas de différence significative entre une croissance de 0,1 % et une croissance de – 0,1 %, si bien que parler de récession dans le cas de cette dernière, mais pas dans celui de la première, est ridicule.

Un autre problème avec cette façon de définir une récession est qu’elle ne fait pas référence à la croissance tendancielle. Si l’économie croît en général de 3 % par an, alors la croissance zéro fait une grosse différence (3 % de moins que la normale). Cependant, si la croissance tendancielle est de 1 %, une croissance nulle ne fait pas une grande différence (juste 1 % de moins que la normale). Cela peut conduire à des erreurs d’appréciation lorsque l’on parle d’une reprise suite à une récession. Par exemple, (…) le PIB (au Royaume-Uni) a commencé à croître en 1982 après la récession de 1980-1981 (…). Comme je l’ai noté ici, la croissance en 1982 était autour du taux tendanciel. La reprise, dans le sens d’un retour à la trajectoire tendancielle du PIB, n’a vraiment débuté qu’en 1983.

Un dernier problème avec la définition "officielle" de la récession est qu’elle se réfère au PIB et non au PIB par tête. Ce dernier est pourtant bien plus pertinent à presque tous les égards. (…) Si nous utilisions le PIB par tête pour définir une récession, alors le Royaume-Uni aurait connu une récession en 2022 et nous pourrions parler d’une seconde récession dans la seconde moitié de cette année. De nouveau, cela montre à quel point cela peut être absurde d’être trop littéral à propos de la définition de la récession.

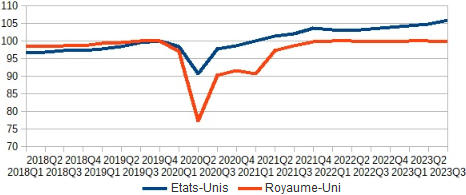

Une bien meilleure façon de décrire l’année 2022 et (tout du moins jusqu’à présent) l’année 2023 est de dire que l’économie est au point mort. Il est tentant de considérer cette période de très faible croissance comme une conséquence de la hausse des taux d’intérêt associée à la lutte contre la forte inflation. La croissance dans les grands pays-membres de l’UE a aussi été faible au cours des deux dernières années. Cependant, l’un des contre-exemples majeurs devrait nous amener à douter de cette explication : comme le montre le graphique ci-dessous, la croissance aux Etats-Unis a été bien plus forte.

GRAPHIQUE PIB par tête aux Etats-Unis et au Royaume-Unis (en indices, base 100 au quatrième trimestre 2023)

Martin Sandbu montre un graphique similaire comparant le PIB des Etats-Unis au PIB de l’UE. Alors que le PIB par tête du Royaume-Uni reste à des niveaux similaires à ceux d’avant la pandémie, le PIB par tête des Etats-Unis est presque 6 % plus élevé. Le Royaume-Uni a enregistré une légère baisse du PIB par tête au troisième trimestre 2023, mais le PIB par tête des Etats-Unis a augmenté de plus de 1 % !

Comme le note Sandbu, ce n’est pas parce que la croissance du PIB par tête est plus forte aux Etats-Unis qu’en Europe. De même, comme je l’ai montré ici, la croissance du PIB par tête au Royaume-Uni a été au moins aussi forte que celle des Etats-Unis avant la crise financière mondiale et l’austérité. Quelque chose s’est produit aux Etats-Unis depuis la pandémie, quelque chose qui ne s’est pas produit au Royaume-Uni et dans l’UE.

L’argument que j’ai déjà avancé, et que Sandbu avance aussi, est que la politique budgétaire américaine a été bien plus expansionniste depuis les premiers temps de la pandémie qu’en Europe. Les détails sont discutés en détail dans ce billet et dans l’article de Sandbu, donc je ne vais pas les répéter ici, sauf pour dire qu’ils impliquent une combinaison du calendrier de la relance budgétaire et une orientation de cette relance vers ceux qui vont la dépenser le plus. Je vais élargir ce point pour faire un point plus général.

Comme avec toute énigme, il peut y avoir plusieurs réponses possibles et pas assez d’éléments empiriques pour déterminer laquelle est correcte. Une explication pourrait être que le choc des prix de l’énergie a davantage affecté l’Europe que les Etats-Unis (…). Si c’était le cas, alors nous aurions dû voir en 2023 un certain rebond en Europe relativement aux Etats-Unis, comme les prix du gaz diminuèrent, mais ce n’est pas ce que nous avons vu. Donc, ce n’est qu’une explication partielle.

L’argument que j’ai déjà avancé, et que Sandbu avance aussi, est que la politique budgétaire américaine a été bien plus expansionniste depuis les premiers temps de la pandémie qu’en Europe. Les détails sont discutés en détail dans ce billet et dans l’article de Sandbu, donc je ne vais pas les répéter ici (…). Je vais élargir ce point pour faire un point plus général.

L’une des particularités du mandat de Biden est que sa politique n’a pas placé le déficit budgétaire ou la dette publique au centre des décisions budgétaires. Cela contraste avec l’Europe, où les contraintes sur la dette ou les déficits imposées par les politiciens semblent toujours mordre, et cela contraste aussi avec les précédentes administrations démocrates aux Etats-Unis qui "se sont inquiétées à propos du déficit" à des degrés divers. Selon moi, la vigueur de l’économie américaine au sortir de la pandémie tient en grande partie à cette différence et les responsables politiques européens qui restent obsédés et contraints par les cibles de déficit ou de dette pourraient en tirer d’importantes leçons.

Qu’est-ce que j’entends par "obsession du déficit" ? Après tout, j’ai régulièrement affirmé qu'une fixation de la politique budgétaire à moyen terme suivant une règle d’or (faisant correspondre les dépenses aux impôts) en temps normal était un bon objectif. L’obsession du déficit, par contraste, voit implicitement la dette publique comme une chose toujours mauvaise, elle érige des cibles totalement arbitraires pour réduire cette dette et elle laisse cela dicter la politique presque tout le temps, ce qui se traduit invariablement par un sous-investissement dans les services publics et les infrastructures.

L’obsession du déficit et de la dette importe le plus après une sévère contraction de l’activité économique, provoquée par exemple par une crise financière ou une pandémie. Après la crise financière mondiale, l’erreur clé n’a pas été l’absence de soutien budgétaire durant la période au cours de laquelle la production chutait, mais durant la période après celle-ci, lorsque nous devions normalement nous attendre à une reprise suite à cette récession. Ce fut le cas aux Etats-Unis et au Royaume-Uni, car les démocrates et les travaillistes étaient au pouvoir. Même en Europe, il y a eu un certain soutien budgétaire durant le pire de la récession. Durant le pire de la pandémie, tous les gouvernements ont fourni un considérable soutien budgétaire. C’est après la crise immédiate que l’erreur a été commise. C’est comme si les responsables politiques abandonnaient leur obsession du déficit lorsque la production chute, mais qu’une fois la chute de la production stoppée, ils se laissent regagner par celle-ci. D’une certaine façon, ils ont aussi été trompés par la "définition officielle" d’une récession.

Nous savons depuis la Grande Dépression des années 1930 qu’après une crise la production ne revient pas toujours à sa trajectoire tendancielle d’avant-crise. Grâce à Keynes, nous savons pourquoi : si les consommateurs et les entreprises pensent qu’il n’y aura pas de rebond, l’activité ne rebondira pas, parce que la consommation et l’investissement resteront déprimés. Dans les années 1930, le chômage est resté élevé, pourtant les salaires et les prix cessèrent de chuter. Il fallut une relance budgétaire, sous la forme d’un New Deal ou d’une guerre, pour réduire le chômage. Le chômage chuta aussi après la crise financière mondiale, mais la production ne retourna pas à sa tendance d’avant-crise.

Nous voyons la même dynamique après la pandémie. Nous avons eu une récession en forme de V, mais la production en Europe n’est pas retournée à sa trajectoire tendancielle prépandémique, parce que dans l’UE et au Royaume-Uni les responsables politiques sont retournés à leur cible du déficit ou de la dette, or celle-ci ne laisse pas de place pour permettre à la reprise d’être complète. La seule exception est les Etats-Unis et c’est là où la production est retournée à quelque chose s’approchant de sa tendance prépandémique.

Dans l’UE et au Royaume-Uni, les responsables politiques voient typiquement la hausse de la dette publique durant la crise comme un problème plutôt que comme un moyen d’atténuer l’impact de la crise. En conséquence, aussitôt la crise finie, ils essayent de réduire la dette publique via la consolidation budgétaire plutôt qu’en stimulant la reprise. Nous savons que cela ne risque guère de fonctionner (les consolidations budgétaires, quand l’écart de production est négatif, tendent à accroître le ratio dette publique sur PIB) et cela risque aussi d’endommager les revenus moyens de façon permanente.

Je n’ai cessé d’avancer cet argument tout au long de cette décennie où j’ai écrit sur mon blog, mais pendant l’essentiel de cette période toutes les grandes économies ont été affligées par l’obsession du déficit, si bien que j’ai été incapable de trouver un exemple actuel illustrant comment les choses peuvent être mieux faites. Grâce au président Biden et aux démocrates, maintenant j’en ai un et les résultats parlent d’eux-mêmes. »

Simon Wren-Lewis, « Current UK and EU stagnation are in part the consequence of deficit obsession », in Mainly Macro (blog), 14 novembre 2023. Traduit par Martin Anota

aller plus loin...

« Les montagnes de dette ne sont pas près de disparaître »

« L’austérité laisse des cicatrices permanentes sur l’activité »

« Quel est l’effet des consolidations budgétaires sur la dette publique ? »

« Pourquoi les gouvernements empruntent-ils ? »

jeudi 17 août 2023

Economie et néolibéralisme

Par Martin Anota le jeudi 17 août 2023, 16:00

« (…) Je parcourais la Stanford Encyclopedia of Philosophy et je suis tombé sur ce paragraphe de l’article de Kevin Vallier sur le néolibéralisme: "Il est davantage justifié de dire que le néolibéralisme est une renaissance des idées libérales classiques au vingtième siècle répondant à certains défis spécifiques à ce dernier. Le néolibéralisme est apparu à la fin des années 1940 en réponse à trois idéologies du vingtième siècle qui conseillaient un Etat de grande taille : le communisme (comme la forme la plus proéminente du socialisme), le fascisme et la social-démocratie. Les néolibéraux cherchaient à confiner le pouvoir de l’Etat à un éventail de fonctions bien plus limité que celui du vaste Etat de ces trois variétés. Les travaux de Hayek sur les systèmes informationnels étaient une réponse à la planification centrale. Le monétarisme de Friedman a été une réponse à la politique macroéconomique keynésienne. Et le programme de recherche du choix public de Buchanan était une réponse à l’économie de l’équilibre général et à l’économie des défaillances de marché".

Je suis trop ignorant pour commenter la première phrase, mais je trouve le reste intéressant parce que j’ai toujours affirmé que l’une des meilleures façons de critiquer le néolibéralisme consiste à utiliser l’économie universitaire. J’ai écrit qu’"il m’est difficile de voir comment une critique efficace du néolibéralisme pourrait ne pas se baser, du moins en partie, sur la science économique".

Je pense que beaucoup à gauche trouveraient étrange cette idée, parce qu’ils voient souvent le néolibéralisme comme étant en partie dérivé de ce qu’ils appellent l’"économie néoclassique". C’est là où le paragraphe de Vallier fait son entrée. Les auteurs qu’il cite étaient impliqués dans deux projets simultanés. L’un consistait à argumenter dans la science économique même et l’autre consistait à utiliser les idées économiques dans leurs écrits plus politiques. Ils parvinrent très bien à faire les deux, mais il y a d’importantes limites à ce succès au sein de la science économique. Si vous regardez l’économie universitaire d’aujourd’hui, il apparaît que Friedman a échoué dans sa tentative de discréditer la politique macroéconomique keynésienne. Tandis que la théorie du choix public a réussi à introduire les méthodes économiques dans la science politique, cela n’a pas arrêté les économistes de parler beaucoup des défaillances de marché et de la façon par laquelle l’Etat peut intervenir sur les marchés pour les régler.

Par conséquent, l’économie universitaire est très différente de l’économie dont les néolibéraux se plaisent à parler. Je me suis parfois amusé de voir que les interprétations néolibérales de l’économie sont ce que vous pourriez obtenir en suivant une première année de cours en économie tout en en manquant la moitié des séances. Pourtant, parce que les idées économiques sont très puissantes, un usage sélectif de cette théorie peut être assez persuasif et des individus comme Hayek ou Friedman ont été très bons pour ce faire. Mais parce qu’ils étaient sélectifs de façon à persuader, leurs idées sont devenues très vulnérables à un usage plus général de la théorie économique et des données empiriques.

L’exemple le plus évident concerne le marché lui-même. Alors que les économistes vont souligner les avantages en termes d’efficacité des échanges marchands, ils sont aussi des experts à propos de la façon par laquelle les marchés échouent à délivrer un résultat efficient, des raisons pour lesquelles ils risquent d’échouer et de la façon par laquelle l’Etat peut intervenir pour traiter ces défaillances de marché. Un exemple classique est celui des externalités comme la pollution. Et tandis que l’efficience est bonne à avoir, cela ne signifie pas que l’allocation résultante est optimale d’une perspective sociale et une grande partie de l’économie publique et de la macroéconomie se penche sur le bien-être social.

Les discussions du néolibéralisme comme idéologie ou ensemble d’idées politiques se focalisent généralement sur la primauté des marchés comme idée centrale. Mais ce serait une erreur de prendre ce que les néolibéraux disent à propos des marchés comme une bonne représentation des marchés concrets. L’un des exemples les plus flagrants est la justification de la rémunération des PDG comme étant "déterminée par le marché", alors qu’en réalité la rémunération des PDG est généralement fixée par un comité composé d’administrateurs et de PDG d’autres entreprises. Quelle est la différence entre cela et avoir des salaires fixés par une commission dirigée par le gouvernement ? Pourtant peu décriraient les salaires du secteur public fixés par les administrateurs du secteur public comme déterminés par le marché.

Dans un livre très intéressant, Colin Crouch a défini le néolibéralisme comme "une stratégie politique qui cherche à rendre nos vies aussi conformes que possible à l’idéal de libre marché de l’économiste". Pourtant, l’idéal de l’économiste d’un libre marché (un marché efficace discuté ci-dessus) requiert "une concurrence parfaite", ce qui signifie qu’il y a de nombreux producteurs et qu’aucun d’entre eux n’a le pouvoir de fixer les prix. Pourtant, les néolibéraux (à la différence des ordolibéraux) semblent peu se soucier du pouvoir de monopole quand cela concerne les entreprises. Par contraste, les néolibéraux sont heureux de s’attaquer au pouvoir de monopole quand il s’agit de celui des travailleurs et des syndicats, mais c’est un exemple classique d’un usage sélectif d’idées tirées de la science économique. Crouch le reconnaît en parlant de "néolibéraux de marchés" (market-neoliberals) et de "néolibéraux de sociétés" (corporate-neoliberals), mais je pense que cela montre davantage le problème qu’il ne le résout.

Peut-être que les néolibéraux aiment mettre l’accent sur le marché parce qu’il y a sur tout marché des sociétés qui produisent des biens et ils veulent soutenir les intérêts de ces sociétés relativement aux intérêts des travailleurs et de l’Etat. J’ai affirmé qu’une meilleure façon de décrire le néolibéralisme en pratique (les politiques poursuivies aux Etats-Unis et au Royaume-Uni par Reagan et Thatcher et les gouvernements subséquents) est de dire que le néolibéralisme utilise les concepts de la science économique pour promouvoir les intérêts du capital (les sociétés).

Prenons la privatisation par exemple. Tandis que la privatisation a introduit de la concurrence (et par conséquent l’idée d’un marché concurrentiel) dans certains cas, elle ne l’a pas fait dans d’autres. La distribution de l’eau, par exemple, reste très proche de la définition que l’économiste donne d’un monopole naturel où la concurrence est impossible. Il n’y a pas de marché où différentes entreprises sont en concurrence pour vendre de l’eau aux consommateurs, mais juste un seul fournisseur qui envoie des facturs chaque trimestre, ce qui est exactement ce qui est survenu quand les entreprises de l’eau étaient publiques.

Ce qu’un secteur de l’eau privatisé introduit qu’un secteur de l’eau nationalisé n’apporte pas est une maximisation du profit conçue pour fournir des dividendes aux actionnaires. Donc, les néolibéraux vont chanter les louanges de la maximisation du profit en disant qu’elle assure une production efficiente. C’est comme utiliser la science économique pour justifier la privatisation, mais de nouveau de façon sélective. En situation de monopole, une entreprise maximisant son profit va fixer les prix à un niveau trop élevé et peut investir trop peu. C’est pourquoi la privatisation est typiquement couplée à un régulateur, mais les agences de régulation peuvent être facilement capturées, donc l’effet net sur l’efficacité de la privatisation n’est pas clair. Donc, la privatisation des monopoles naturels ne tient pas tant à la création de marchés ou à l’utilisation impartiale de la science économique, mais plutôt à appliquer de façon sélective des idées économiques particulières pour créer du capital privé.

Un autre aspect du néolibéralisme en pratique, la réduction des impôts sur les plus aisés, est encore plus intéressant à cet égard. De nouveau, cela n’a rien à voir avec les marchés, mais implique l’usage sélectif de bribes de science économique pour poursuivre des fins politiques. La justification standard pour la réduction des impôts est qu'elle est censée accroître les incitations à offrir du travail, mais cela s’applique aussi bien au travailleur en bas de la hiérarchie qu’au PDG. Tous deux sont des créateurs de richesse. Pour utiliser le jargon économique, tous les impôts sont sources de distorsions (ils réduisent l’efficacité), mais pas seulement ceux des hauts revenus.

Cet exemple est particulièrement intéressant parce que, comme Vallier le note, ce qui est appelé "l’économie du ruissellement" (trickle-down economics) ne fait pas partie du néolibéralisme de Hayek ou de Friedman. Il n’est pas non plus clairement dans les intérêts des sociétés comme entités, parce que de moindres taux marginaux d’imposition n’aident pas à accroître les profits. En effet, une théorie visant à expliquer pourquoi la rémunération des PDG est si élevée est que c’est la conséquence de faibles marginaux d’imposition (voir ici) et une forte rémunération des PDG représente une (petite) déduction des profits.

La distinction entre le capital (sous la forme de sociétés) et les riches (les PDG ou actionnaires) peut sembler pédante, mais je pense qu’elle est devenue centrale au développement du néolibéralisme. Bien que certains à gauche aiment à qualifier de néolibéraux les gouvernements de Johnson ou de Trump, ces derniers ne sont pas des néolibéraux comme Thatcher ou Reagan. Thatcher a aidé à créer le marché unique de l’UE parce que cela bénéficiait au capital du Royaume-Uni impliqué dans le commerce international, mais Johnson, en promouvant le Brexit, fit l’opposé, parce qu’il a été soutenu par des individus très riches (en particulier des propriétaires de journaux) qui avaient leurs propres intérêts individuels à une sortie de l’UE. Le libre échange et le libre mouvement du travail bénéficient au capital, mais Trump s’est attaqué aux deux.

Ironiquement, je pense que vous pouvez utiliser des arguments souvent associés à Buchanan pour expliquer ce paradoxe apparent. Buchanan voulait suggérer que l’Etat serait incapable de corriger pleinement les défaillances de marché parce que les incitations auxquelles les politiciens sont soumis les amènent à se détourner de l’intérêt public. Mais en principe la même chose peut arriver aux politiciens qui ont commencé en voulant promouvoir les intérêts du capital, mais qui, sous l’effet des incitations auxquels ils furent soumis (via les donations des riches ou des pressions émanant des propriétaires de médias), ont été amenés à promouvoir des politiques qui agissent à l’encontre des intérêts du capital. C’est pourquoi certains néolibéraux peuvent prétendre que le Brexit était une bonne idée en imaginant que les réglementations relatives au travail ou à l’environnement étaient plus onéreuses dans les entreprises en général que la bureaucratie associée au commerce avec le Brexit. C’était un non-sens, mais les incitations auxquelles ils faisaient face les poussaient dans cette direction.

Même si je vous ai convaincu que l’économie universitaire peut être un outil très efficace pour critiquer les idéologies comme le néolibéralisme, cela a un revers évident : l’économie universitaire peut à son tour être influencée (et dans certains cas être biaisée) par les idéologies. Comment ceux en-dehors de l’économie universitaire savent dans quelle mesure cela continue dans l’économie universitaire aujourd’hui ? Ce qui empêche l’idéologie d’influencer en permanence l’économie universitaire est la discipline basée sur l’empirique. Donc il est approprié de nous tourner vers l’empirique quand nous évaluons l’influence de l’idéologie sur l’économie universitaire orthodoxe.

Comme je l’ai déjà mentionné, les arguments de Friedman contre le réglage fin keynésien n’ont jamais eu de soutien généralisé parmi les universitaires et n’ont qu’un faible écho aujourd’hui. A travers le monde, les banques centrales modifient les taux d’intérêt à un rythme mensuel de façon à réguler le cycle d’affaires. Comme je l’ai aussi noté, beaucoup d’universitaires étudient les défaillances de marché. Un autre exemple a été l’austérité, à laquelle la majorité des universitaires s’est opposée, une majorité qui était proche d’un consensus avec la multiplication des analyses empiriques. A gauche, beaucoup d’économistes au cours des années 1960 et 1970 affirmaient que maintenir le chômage à un très faible niveau était essentiel et que les politiques de prix et revenus devaient être utilisées pour contenir l’inflation. De nouveau, les données empiriques n’étaient pas de leur côté et cette approche perdit du soutien parmi les économistes. (…) »

Simon Wren-Lewis, « Economics and neoliberalism », in Mainly Macro (blog), 15 août 2023. Traduit par Martin Anota

aller plus loin... lire « Les économistes du FMI passent au crible les politiques néolibérales »

dimanche 5 septembre 2021

Réapprendre de vieilles idées en macroéconomie après la contre-révolution des nouveaux classiques

Par Martin Anota le dimanche 5 septembre 2021, 12:00 - Epistémologie et histoire de la pensée

« Ce billet poursuit ce que Chris Dillow a développé dans un billet. Celui-ci fait deux affirmations à propos de la macroéconomie. Pour les comprendre, vous devez connaître la distinction entre économie orthodoxe et économie hétérodoxe. Il est difficile de définir précisément ce qui distingue ces deux groupes (beaucoup d’articles et de chapitres ont essayé de le faire), mais nous pouvons faire quelques observations. La plupart des économistes dans les départements universitaires sont orthodoxes et les économistes hétérodoxes se répartissent entre différentes écoles. Une autre observation est que les économistes orthodoxes ignorent presque totalement ce que les hétérodoxes font. Il est faux de dire que tous les économistes hétérodoxes sont orientés politiquement à gauche ou qu’aucun orthodoxe ne l’est.

Chris affirme tout d’abord que l’essentiel de l’économie hétérodoxe est la macroéconomie qui était dominante il y a longtemps. Sa seconde affirmation concerne l’orthodoxie. Il suggère qu’il y a eu une "grande amnésie" dans les années 1980, dans la mesure où plusieurs idées présentées comme nouvelles aujourd’hui sont juste de vieilles idées qui semblent avoir été oubliées. Je pense que chacune de ces affirmations a une certaine validité et j’espère parvenir ic à expliquer pourquoi cela est arrivé et quel lien il y a entre elles.

La grande amnésie a eu lieu en raison d’une révolution méthodologique en macroéconomie, en l’occurrence la contre-révolution des nouveaux classiques. Beaucoup à cette époque se sont focalisés sur un aspect de cette révolution, en l’occurrence l’attaque portée à l’encontre de ce qui constituait à l’époque la macroéconomie keynésienne orthodoxe. Celle-ci a rapidement échoué, mais ce qui a duré par contre fut une révolution méthodologique, qui est souvent qualifiée de microfondation de la macroéconomie. J’ai notamment écrit à propos de la contre-révolution des nouveaux classiques ici.

Avant la contre-révolution des nouveaux classiques, la macroéconomie était presque un sujet différent de la microéconomie. La principale théorie macroéconomique, l’économie keynésienne, pouvait être écrite avec des équations agrégées et elle pouvait être estimée en utilisant des données agrégées, mais il fut parfois difficile de la relier à la théorie microéconomique. En partie pour cette raison, la macroéconomie a contenu différentes écoles de pensée, où il était difficile de relier une "école" à une autre.

La contre-révolution des nouveaux classiques a affirmé que tout modèle macroéconomique devait non seulement être dérivé de la théorie microéconomique, mais aussi que la théorie devait être utilisée avec une certaine cohérence. En unifiant la macroéconomie et la microéconomie, elle apparut particulièrement attrayante aux jeunes économistes. Très rapidement, les universitaires prirent conscience que l’on pouvait aussi formaliser certains aspects de l’économie keynésienne antérieure à la contre-révolution des nouveaux classiques d’une façon microfondée et l’hégémonie des microfondations devint complète au sein de l’économie orthodoxe. Comme tous les macroéconomistes de l’orthodoxie parlaient le même langage (la microéconomie), il existait dans une certaine mesure en son sein des écoles de pensée liées aux différences à propos des valeurs des paramètres dans un cadre théorique commun (ces croyances pouvaient refléter des préférences idéologiques).

Cette réduction de la fragmentation dans la macroéconomie orthodoxe est une importante force unificatrice. Avant la contre-révolution des nouveaux classiques, vous pouviez aller à un séminaire de macroéconomie tenu par une personne d’une différente école de pensée et avoir peu d’idées de ce dont elle parlait. Après la contre-révolution des nouveaux classiques, vous compreniez exactement ce dont les intervenants évoquaient et même commenter leurs travaux, mais simplement penser qu’ils n’étaient pas très pertinents dans le monde réel.

L’un des aspects négatifs de la contre-révolution des nouveaux classiques a été qu’elle a mené à la "grande amnésie" dont Dillow a parlé. Pour certains, la contre-révolution des nouveaux classiques a constitué l’année zéro en macroéconomie, tout ce qui a été fait auparavant (en dehors de l’hégémonie des microfondations) ayant peu d’intérêt à leurs yeux. (…) J’ai réalisé des travaux où j’ai appliqué le modèle des taux de change d’équilibre de John Williamson, qui utilisait des techniques antérieures aux microfondations. Cette approche fut redécouverte par Obstfield et Rogoff qui utilisèrent un modèle microfondé (la "nouvelle approche en économie ouverte", qui appliquait les microfondations de la concurrence imparfaite au commerce international). C’était bien, mais à ma connaissance Obstfield et Rogoff n’ont jamais évoqué la littérature antérieure qui fut développée par John Williamson. C’est une parfaite illustration de la grande amnésie.

C’est une mauvaise idée d’avoir des années zéro dans une discipline. (…) Les microfondations sont une bonne chose, mais l’hégémonie des microfondations ne l’est pas. Par hégémonie, j’entends voir le reste de la macroéconomie comme désuète et peu digne d’être publiée dans les revues les plus prestigieuses. Certains économistes ont eu une réaction plus vive et choisirent de rejoindre l’hétérodoxie. Ils pensent que la microéconomie n’a pas mérité de rôle central en macroéconomie ou bien ils pensent qu’il ne fait pas sens de microfonder la macroéconomie. Je pense qu’il est juste de dire qu’après la contre-révolution des nouveaux classiques il est devenu plus difficile, si ce n’est impossible, pour ces économistes de prendre le train orthodoxe.

Dillow arrive à quelque chose de similaire en disant qu’une grande partie de l’économie hétérodoxe s’apparente à ce qu’il a appris avant la contre-révolution des nouveaux classiques. En faisant cette observation, il ne critique pas les économistes hétérodoxes, mais note plutôt qu’une partie de ce qu’ils font est une continuation de la macroéconomie antérieure à la contre-révolution des nouveaux classiques. (...)

La contre-révolution des nouveaux classiques n’a pas créé de macroéconomie hétérodoxe. L’économie hétérodoxe que je me souviens avoir étudiée à Cambridge au début des années 1970 était un rejet de l’économie néoclassique. Cette dernière observe comment les producteurs qui maximisent leurs profits interagissent avec des consommateurs qui maximisent leur utilité sur des marchés parfaites (c’est-à-dire où il y a beaucoup de producteurs et de consommateurs pour chaque produit de façon à ce que chacun soit preneur de prix). Comme Chris le note, la théorie implique que les gens soient payés à leur "productivité marginale".

Si vous demandez à la plupart des économistes orthodoxes aujourd’hui si ce qu’ils font suppose la validité de l’économie néoclassique, ils riraient probablement. Comme je l’ai souvent dit, une grande partie de l’économie aujourd’hui concerne l’étude de marchés qui sont loin d’être parfaits. (Nous pouvons débattre sans fin quant à savoir si avoir des marchés parfaits, et les conditions d’optimisait associées, constitue un point de référence utile ou trompeur.) La science économique s’est aussi étendue bien au-delà de l’étude des marchés et de leurs imperfections pour inclure la théorie des jeux et l’économie comportementale par exemple. Rien de cela n’a empêché les économistes de droite d’utiliser des idées de l’économie néoclassique quand cela leur convenait.

Un autre aspect de la microéconomie aujourd’hui est qu’elle est dominée par l’analyse empirique. L’époque où elle tournait autour des preuves hautement mathématiques à propos de la nature de l’équilibre général est aujourd’hui bien révolue.

Revenons à la contre-révolution des nouveaux classiques en macroéconomie. La microéconomie que les partisans de la contre-révolution des nouveaux classiques adoptèrent pour remodeler la macroéconomie était essentiellement l’économie néoclassique, alors même que les microéconomistes ont de leur côté eu tendance à s’éloigner de celle-ci. Les nouveaux keynésiens ont apporté une forme de concurrence imparfaite dans les modèles DSGE pour formaliser la rigidité des prix ou des salaires, mais il demeure que le modèle DSGE de base se base sur des microfondations néoclassiques. (…) Nous pouvons voir à présent une raison supplémentaire pour la barrière entre macroéconomistes hétérodoxes et orthodoxes. La macroéconomie a adopté l’économie néoclassique que les économistes hétérodoxes avaient rejetée plusieurs décennies avant la contre-révolution des nouveaux classiques.

Même si je considère pour ma part la macroéconomie postérieure à la contre-révolution des nouveaux classiques comme progressive dans le sens de Lakatos, je crois que son hégémonie ne se justifie pas. J’ai beaucoup appris à propos du fonctionnement du monde dans la macroéconomie antérieure à la contre-révolution des nouveaux classiques et cela a été complété plutôt que dupliqué par ce que j’ai appris de la macroéconomie microfondée. (J’ai beaucoup publié de travaux dans les deux.) La macroéconomie orthodoxe a aujourd’hui besoin de suivre la microéconomie en devenant plus empirique et une façon pour elle de le faire est de ressusciter le style de modélisation antérieur à la contre-révolution des nouveaux classiques. Cela implique des études économétriques des sous-systèmes ou des relations individuelles et l’usage de modèles économétriques structurels, des modèles qu'Olivier Blanchard qualifie de modèles de politique et que Chris mentionne justement dans son billet. Ces modèles sont une combinaison éclectique de théorique et d’études économétriques de relations individuels ou de sous-ensembles.

Comme je l’ai noté dans cet article, il est effrayant de voir que des institutions comme le FMI et la Fed font toujours beaucoup de ce genre d’analyse, mais que la macroéconomie orthodoxe dans les revues les plus prestigieuses n’en fasse presque pas. Loin est le temps où nous pouvions prétexter qu’il s’agit d’institutions à l’analyse obsolète ou qu’une telle analyse est erronée en raison de problèmes d’identification ou parce qu’elle ne passe pas la critique de Lucas. Si les macroéconomistes universitaires ne veulent pas s’aventurer dans ces directions, peut-être que certains économistes hétérodoxes peuvent prendre leur place. »

Simon Wren-Lewis, « Relearning old ideas in macroeconomics after the New Classical Counter Revolution », in Mainly Macro (blog), 3 août 2021. Traduit par Martin Anota

aller plus loin...

« La stagflation et la lutte des méthodologies en macroéconomie »

« Les modèles DSGE font-ils progresser la science économique ? »

« billets précédents - page 1 de 35