« L’emploi peut se retrouver à son niveau maximal tel qu’on l’estime en temps réel ou au-delà sans susciter d’inquiétude, à moins que cela ne s’accompagne de signes d’accélérations indésirables de l’inflation ou de l’émergence d’autres risques qui peuvent nous empêcher d’atteindre nos objectifs. »

Jerome Powell, président de la Réserve fédérale, lors de la conférence de Jackson Hole du 27 août 2020.

Dans ce billet, nous identifions trois facteurs clés motivant la revue stratégique de la Fed et soulignons trois grands changements dans la stratégie du comité de politique monétaire. En outre, nous identifions d’importantes questions auxquelles le comité devra apporter une réponse lorsqu’il cherchera à mettre en place son nouveau cadre de politique monétaire. En particulier, l’adoption du ciblage flexible de l’inflation moyenne implique un changement dans la fonction de réaction du comité. Comment cette redéfinition de l’objectif influencera-t-elle la réponse systématique du comité aux variations de la croissance économique, du chômage, de l’inflation et des conditions financières ? Sous un ciblage flexible de l’inflation moyenne, la cible d’inflation effective au cours des prochaines années dépend aussi de l’expérience passée avec l’inflation. Quelle est cette relation ?

Peut-être que la Fed a été avant tout poussée à changer de stratégie en prenant conscience que le niveau soutenable des taux d’intérêt nominaux a décliné. Ce changement se manifeste à travers les révisions à la baisse des prévisions des taux des fonds fédéraux à long terme. Par conséquent, la banque centrale s’inquiète à l’idée de voir le taux directeur buter fréquemment à sa borne inférieure effective, dans la mesure où la marge de manœuvre de la Fed en matière de politique monétaire conventionnelle s’en trouverait réduite. L’idée du ciblage flexible de l’inflation moyenne est de relever la cible d’inflation lorsque l’inflation est faible. En réduisant le taux d’intérêt réel anticipé en de telles circonstances, le ciblage flexible de l’inflation moyenne réduit la nécessité d’utiliser le forward guidance et les outils de bilan à la borne inférieure zéro (voir notre précédent billet).

Deuxièmement, comme le président Powell le souligne dans la citation en ouverture, le lien entre le marché du travail et l’inflation est plus lâche que par le passé, ce qui rend plus difficile d’estimer le niveau de chômage compatible avec la stabilité des prix.

Troisièmement, pour l’essentiel, l’inflation s’est retrouvée sous les 2 % depuis 2012, quand le comité de politique a pour la première fois présenté sa cible quantitative. (Selon l’indice des prix, l’inflation s’est retrouvée en moyenne entre 1,3 % et 1,8 % par an au cours des huit dernières années.) Avec une inflation durablement inférieure à la cible, l’inquiétude est que les anticipations d’inflation finissent par chuter, ce qui accroîtrait les taux d’intérêt réels anticipés et resserrerait en conséquence les conditions financières, en particulier quand le taux directeur est proche de zéro. Comme le président Powell l’a souligné, "nous avons vu cette dynamique perverse affecter d’autres économies majeures à travers le monde et nous avons constaté qu’une fois tombé dans une telle situation il peut être très difficile d’en sortir".

En combinant ces trois facteurs, le comité de politique monétaire a considéré qu’il était nécessaire de répondre à l’asymétrie fondamentale de la politique monétaire conventionnelle : quand l’inflation s’élève au-dessus de sa cible, la banque centrale peut relever les taux d’intérêt, ce qui réduit la demande globale et atténue l’inflation. Cependant, si l’inflation est trop faible, quand le taux d’intérêt est à sa borne zéro, la politique conventionnelle n’est plus disponible pour davantage stimuler la demande globale, alimenter l’inflation et s’assurer que les anticipations d’inflation restent bien ancrées. L’expérience des dernières années aux Etats-Unis et à l’étranger a suscité des inquiétudes à la Fed quant à une telle éventualité.

Donc, quels sont les principaux changements quant aux objectifs de plus long terme du comité de politique monétaire ? Nous en soulignons trois : (I) l’introduction d’un ciblage flexible de l’inflation moyenne ; (ii) un relâchement des efforts pour prévenir une accélération de l’inflation ; (iii) un engagement explicite pour entreprendre une revue publique du cadre de politique monétaire "à peu près tous les cinq ans".

Le premier de ces trois objectifs vise à s’attaquer au maintien durable de l’inflation en-deçà de sa cible de 2 %. Le deuxième revient à admettre que la capacité de la Fed à prévoir l’inflation est limitée. Il dénote une moindre inquiétude à propos des marchés du travail sous tension et, dans le double mandat de la Fed, donne plus de poids à l’objectif de plein emploi relativement à celui de la stabilité des prix. Le troisième fournit un horizon temporel pour réévaluer l’adéquation du cadre de politique monétaire du comité. En se focalisant sur les deux premiers, les changements génèrent un biais vers une inflation moyenne plus élevée de façon à contrer l’asymétrie fondamentale inhérente à la politique conventionnelle de taux d’intérêt.

Nous avons discuté du ciblage de l’inflation moyenne en détails dans notre précédent billet. La version "flexible" de la Fed lui laisse une formidable discrétion. En rejetant toute "formule", l’approche définit ni la fenêtre de temps passée pour mesurer les déviations de l’inflation, ni la fenêtre de temps future pour ramener l’inflation à sa moyenne cible. De tels détails clés étant absents, le comité de politique monétaire devra communiquer d’une réunion à l’autre son objectif d’inflation à court terme. La capacité du comité à influencer les anticipations d’inflation à la borne inférieure (un motif clé pour adopter le ciblage flexible de l’inflation moyenne) va dépendre de la clarté avec laquelle il communiquera son objectif et de la crédibilité de son engagement pour l’atteindre. Plus la déclaration sera claire (à propos de l’objectif d’inflation et de l’horizon temporel), plus elle sera efficace pour réduire les taux d’intérêt réels anticipés quand le taux directeur butera sur sa borne inférieure.

Au même instant, la nouvelle déclaration laisse ouvertes d’importantes questions à propos de ce qui déclenchera un changement dans l’objectif d’inflation à moyen terme. Par exemple, si l’inflation courante ou l’inflation anticipée s’élèvent à 3 %, cela suffira-t-il pour amorcer un changement ? Alors que le ciblage flexible de l’inflation moyenne vise à rendre le niveau des prix à long terme plus prévisible, quelle variation de l’inflation à court terme le comité tolérera-t-il ?

Pour prendre un exemple simple, au cours des cinq dernières années, l’écart cumulé de l’inflation par rapport à sa cible de 2 % s’élève à 2,5 points de pourcentage (lorsque l’on mesure l’inflation à partir de l’indice des prix à la consommation). Si le comité de politique monétaire désire compenser une partie de cet écart au cours des cinq prochaines années (en ciblant sur dix ans un taux moyen d’inflation de 2 %), alors il devra atteindre une inflation de 2,5 % en moyenne. Alternativement, s’il désire rattraper plus rapidement l’écart, disons sur trois ans, alors la cible sera plus proche de 3 %. Plus le comité sera clair par rapport à sa fonction de réaction (notamment à propos de l’horizon au cours duquel il tend à restaurer l’inflation à l’objectif de plus long terme de 2 %), plus il sera probable que ses actions se révéleront stabilisatrices.

En ce qui concerne la moindre importance donnée à la prévention de l’inflation, le changement clé concerne la façon par laquelle la Fed considère l’emploi maximal. Plutôt que de décider de la politique monétaire en réaction aux "déviations", à la hausse comme à la baisse, par rapport à l’emploi maximal (comme dans une règle de Taylor typique), la nouvelle déclaration se focalise sur les écarts à la baisse par rapport à l’emploi maximal. Comme l’évoquait la citation de Powell en ouverture, le lien entre un faible taux de chômage et l’accélération de l’inflation n’est plus aussi robuste que par le passé. Selon nous, ce changement explicite simplement ce que la Fed faisait déjà en pratique. Rappelons-nous qu’en 2019 la Fed a réduit les taux d’intérêt de 75 points de base, alors même que le taux de chômage était à 3,5 %, un niveau qui n’avait pas été atteint depuis cinquante ans. (...)

Pour résumer, et ce en cohérence avec la réaction limitée des marchés financiers, nous ne voyons dans la nouvelle déclaration de la Fed qu’une modeste révision de ses pratiques. Etant donné que l’on s’attend à une longue période de taux d’intérêt nuls, la nouvelle stratégie de la Fed répond à l’accroissement du risque d’avoir une inflation trop faible relativement au risque d'avoir une inflation trop forte.

Cela dit, la réaction des marchés peut aussi refléter un profond scepticisme quant à la capacité de la Fed à relever l’inflation, en particulier dans une telle récession. Elle a régulièrement échoué à atteindre la cible de 2 % depuis qu’elle l’a annoncée. Pourquoi devrait-on croire qu’elle est capable de ramener l’inflation au-delà de 2 % ces prochains temps ? Peut-on vraiment croire que la Fed est vraiment différente des autres grandes banques centrales qui ont passé l’essentiel de leur temps la dernière décennie à essayer de stimuler l’inflation pour la ramener à sa cible sans y parvenir ? (…)

Par conséquent, la différence la plus manifeste à moyen terme tiendra dans la communication de la Fed, dans ce qu’elle dit à propos de sa politique monétaire. Comme Ben Bernanke, l’ancien président de la Fed avait l’habitude de le dire, "la politique monétaire, c’est 98 % de paroles et 2 % d’actions". C’est encore davantage de communication lorsque, comme à présent, le taux directeur se retrouve contraint vers zéro. Plus le comité de politique monétaire pourra nous en dire à propos de la façon par laquelle il utilisera systématiquement la plus grande discrétion qu’il se donne dans son nouveau cadre, plus son action sera efficace. »

Stephen Cecchetti et Kermit Schoenholtz, « The Fed's new strategy: More discretion, less preemption », in Money & Banking (blog), 29 août 2020. Traduit par Martin Anota

Tag - Stephen Cecchetti

vendredi 11 septembre 2020

La nouvelle stratégie de la Fed : davantage de discrétion, moins de prévention

Par Martin Anota le vendredi 11 septembre 2020, 18:23 - Monnaie et finance

samedi 5 septembre 2020

Qu'est-ce que le ciblage de l'inflation moyenne ?

Par Martin Anota le samedi 5 septembre 2020, 09:00 - Politique monétaire

« La première grande revue stratégique du comité de politique monétaire de la Réserve fédérale est sur le point de s’achever. Depuis qu’elle l’a annoncée le 15 novembre 2018, la Fed s’est focalisée sur les stratégies, les outils et les pratiques en matière de communication (…).

Peut-être que le point le plus important dans le programme de révision de la Fed est celui de la stratégie de ciblage d’inflation (inflation-targeting) du comité de politique monétaire. Depuis 2012, ce dernier a explicitement ciblé un taux d’inflation de 2 % (mesuré par l’indice des prix à la consommation). Un objectif clé de la stratégie du comité de politique monétaire est d’ancrer les anticipations d’inflation de long terme, pour contribuer non seulement à la stabilité de prix, mais aussi à "l’amélioration de la capacité du comité à promouvoir l’emploi maximal face aux perturbations économiques majeures". Pourtant, depuis le début de l’année 2012, l’inflation des prix à la consommation a atteint en moyenne seulement 1,3 %, amenant beaucoup de responsables de la politique monétaire à s’inquiéter à l’idée qu’une inflation durablement basse pousse davantage l’inflation anticipée à la baisse (cf. Williams). Et, avec le taux directeur de la Fed de nouveau à proximité de zéro, la chute des anticipations d’inflation accroît le taux d’intérêt réel, resserrant les conditions monétaires et sapant les efforts des autorités monétaires pour stimuler la croissance et l’inflation.

Il est peu probable que la Fed ne garde pas l'idée d'un ciblage de 2 % d’inflation sous une forme ou sous une autre, mais cela laisse ouverte la possibilité d’autres changements. Dans cette note, nous discutons d’une alternative pour l’approche courante qui a fait l’objet d’une grande attention : à savoir le ciblage d’inflation moyenne. L’idée derrière le ciblage d’inflation moyenne est que, lorsque l’inflation se retrouve au-dessus de la cible, cela crée l’anticipation d’une plus forte inflation. Et, si l’inflation se retrouve en-dessous de sa cible, alors il faut réduire les anticipations d’inflation. Même quand le taux directeur atteint zéro, le résultat est un mouvement contracyclique dans les taux d’intérêt qui améliore l’efficacité de la politique conventionnelle.

Une banque centrale adoptant un cadre de ciblage d’inflation moyenne choisit une période de temps (qualifions-la de fenêtre de moyennisation) au cours de laquelle elle mesure l’inflation avec l’objectif d’atteindre une cible numérique (disons 2 %) en moyenne. En incluant un certain nombre d’années passées, ce système diffère fortement d’un ciblage d’inflation conventionnel. Dans le cadre de ce dernier, le passé est de l’histoire ancienne : la stratégie conventionnelle ignore ce qui a été raté par le passé, cherchant une cible numérique constante au cours d’une poignée d’années suivantes. A l’inverse, si la stratégie des autorités monétaires est celle du ciblage de l’inflation moyenne, alors elles vont essayer de rattraper une partie de leurs erreurs passées.

Pour voir la différence, considérons l’expérience américaine depuis 2012. Comme nous l’avons noté ci-dessus, au cours des huit dernières années, l’inflation a été en moyenne inférieure de 0,7 point de pourcentage par rapport à la cible de 2 % de la Fed. Malgré cet échec, l’objectif d’inflation à moyen terme dans le futur de la Fed est resté inchangé. Si la cible du comité de politique monétaire avait été l’inflation moyenne, leur cible future aurait été relevée pour compenser l’échec passé et finir par atteindre la moyenne.

Pour comprendre la mécanique du ciblage d’inflation moyenne, il est utile de considérer le cas du ciblage du niveau des prix. Cette stratégie est l’exact opposé du ciblage d’inflation pur, comme le passé n’est pas ignoré. En d’autres termes, le ciblage du niveau des prix est un ciblage d’inflation moyenne avec une fenêtre de temps infinie pour mesurer l’inflation. En l’occurrence, la banque centrale cherche à maintenir les prix à proximité de leur trajectoire de long terme qui augmente au taux cible, cherchant à compenser quelques erreurs passées, et ce qu’importe quand elles ont été commises. Plusieurs économistes ont conseillé le ciblage du niveau des prix précisément parce que (s'il est crédible) il peut réduire le taux d’intérêt réel anticipé lorsque les taux d’intérêt nominaux butent sur leur borne inférieure, ce qui permet d’assouplir davantage la politique monétaire sans que la banque centrale ait à recourir au forward guidance ou aux outils de bilan (cf. Woodford).

Pour illustrer la différence entre les deux approches, considérons deux banques centrales avec un objectif identique de 2 % de croissance annuelle du niveau des prix. La première suit une stratégie pure de ciblage d’inflation où le passé est oublié, tandis que la seconde suit une stratégie de ciblage du niveau des prix, cherchant à compenser les erreurs passées. En l’absence de tout choc qui éloigne l’inflation de la cible, les deux stratégies sont indistinctes : le niveau des prix s’élève au rythme constant de 2 % par an. (Nous empruntons cet exemple à George Kahn.)

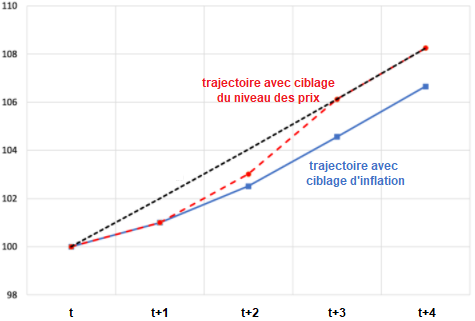

Supposons, cependant, qu’il y ait un choc désinflationniste qui réduise l’inflation au cours de l’année t+1 d’un point de pourcentage de 2 % à 1 % (…). Supposons en outre que les deux banques centrales réussissent à retourner à leur cible à l’année t+3, c’est-à-dire au terme d’une période de deux années (que nous qualifierons de période de restauration). Le graphique ci-dessous montre les trajectoires du niveau des prix dans le cas de ces deux stratégies. Dans le cadre du ciblage d’inflation pur, la banque centrale cherche à relever l’inflation de 1 % à 2 % graduellement au cours de la période de restauration (il s’agit de la ligne bleue solide). Chose importante, alors que le niveau des prix retourne à une trajectoire qui est parallèle à la trajectoire de prix originelle, elle est à jamais inférieure à celle-ci : la ligne bleue est en-dessous de la ligne pointillée noire. C’est dans ce sens que le passé est oublié.

GRAPHIQUE Trajectoires du niveau des prix selon que la banque centrale cible l'inflation ou le niveau des prix lorsque l’inflation chute d’un point de % au cours d’une année

La ligne aux traits rouges montre la stratégie de ciblage du niveau des prix. Notons que cette ligne rejoint graduellement la ligne pointillée noire : l’inflation excède la cible d’inflation de 2 % à long terme au cours de la période de restauration. C’est ce qui signifie rattraper les erreurs passées pour une banque centrale : une période où l’inflation est supérieure à la cible suit une période où l’inflation est inférieure à la cible. En d’autres termes, dans le cadre du ciblage du niveau des prix, la politique monétaire est dépendante de l’histoire. Dans le cadre du ciblage d’inflation pur, elle ne l’est pas.

A partir de là, nous pouvons voir que le ciblage d’inflation moyenne est un hybride entre ciblage d’inflation pur et ciblage du niveau des prix (…). Plus la fenêtre de moyennisation est large, plus on se rapproche du ciblage du niveau des prix. De plus, les deux stratégies polaires ont différentes implications pour la variabilité du niveau des prix à long terme. En minimisant les écarts par rapport à la trajectoire ciblée, un ciblage du niveau des prix rend prévisible le niveau des prix à long terme, mais cela rend l’inflation plus volatile à court terme. Dans le cadre du ciblage d’inflation pur, les écarts par rapport à la trajectoire du niveau des prix originelle se creusent au cours du temps, réduisant la prévisibilité des prix à long terme.

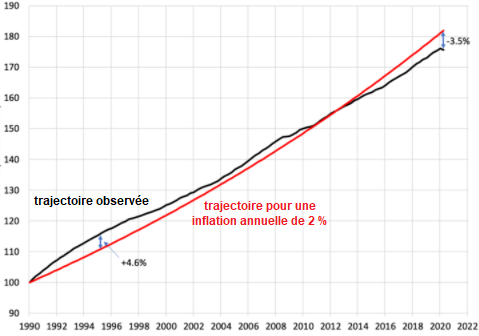

Aux Etats-Unis, les différences pratiques entre ciblage d’inflation et ciblage du niveau des prix ont été limitées. Nous pouvons considérer que la Fed a de facto ciblé l’inflation depuis le milieu des années 1980. Néanmoins, au cours des trente dernières années, le niveau des prix (excluant l’alimentaire et l’énergie) s’est accru à peu près au rythme avec celui d’un pur régime de ciblage du niveau des prix, si bien que le taux d’inflation annuel moyen a été de 1,86 % (voir le graphique). Au même instant, sur des intervalles de temps plus courts, les écarts ont eu tendance à persister. Dans les premières années, l’inflation a typiquement dépassé la cible. Par conséquent, au deuxième trimestre 1995, le niveau des prix a dépassé la trajectoire à long terme de 4,6 %. Plus récemment, le schéma s’est inversé. Au deuxième trimestre 2020, le niveau des prix était inférieur de 3,5 % par rapport à sa trajectoire à long terme.

GRAPHIQUE Indice des prix des dépenses de consommation aux Etats-Unis (excluant l’alimentaire et l’énergie)

Cela implique que l’adoption d’un régime de ciblage d’inflation moyenne aurait été une mesure modérée, plutôt que radicale (cf. Reifschneider et Wilcox). Pour le voir, nous pouvons faire une simple simulation. Commençons par supposer (comme dans la simulation ci-dessus) que la banque centrale cible l’inflation moyenne sur cinq ans, en observant les trois années précédentes et en cherchant à restaurer le niveau le niveau des prix sur sa trajectoire de 2 % au cours des deux années suivantes. Au vu des limites quant à l’efficacité de la politique monétaire, nous soupçonnons que la période de restauration actuelle aurait été plus longue, donc cette hypothèse se traduit par une réponse plus agressive aux chocs et ajoute de la volatilité dans la cible d’inflation annuelle de la Fed. (D’un autre côté, si la période de restauration s’allonge, il devient plus difficile pour le comité de politique monétaire de faire un engagement crédible pour atteindre la cible d’inflation.)

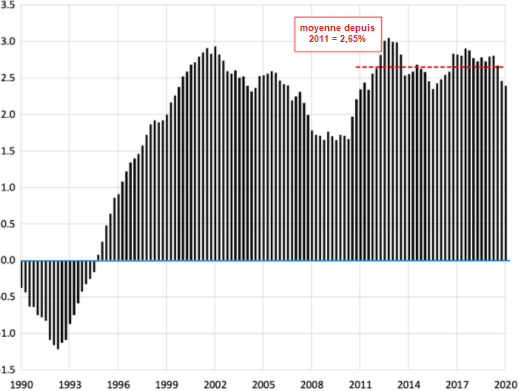

Dans le graphique ci-dessous, prenant dans la fenêtre de moyennisation les trois années précédentes, nous indiquons la cible d’inflation annuelle impliquée pour une période de restauration de deux ans. (Notez qu’il s’agit d’une hypothèse statique : nous ne prenons pas en compte le fait que le processus d’inflation aurait changé si la Fed avait effectivement adoptée ce ciblage de l’inflation moyenne.) Sous ces hypothèses, la cible impliquée depuis 2011 aurait été comprise entre 2,2 % et 3,04 %, avec une moyenne de 2,65 %. Avec une fenêtre de moyennisation historique sur trois ans et une période de restauration de deux ans, la cible d’inflation de la Fed aurait été 0,65 point de pourcentage plus élevée pour la décennie passée. Si ce comportement de la banque centrale était crédible et anticipée, cela aurait réduit le taux d’intérêt de court terme réel moyen de 65 points de base, ce qui serait une stimulation bienvenue (quoique modérée) lorsque les taux d’intérêt nominaux étaient à la borne inférieure zéro. (Nous notons qu’un passage du prix excluant l’alimentaire et l’énergie à une mesure globale accroît la volatilité de la cible d’inflation visée sur les deux années suivantes, en élargissant sa gamme sur l’échantillon de 30 ans d’environ un point de pourcentage.)

GRAPHIQUE Hypothétique cible d’inflation moyenne focalisée sur les trois années précédentes et les deux années suivantes

Ce sont sûrement de bonnes nouvelles, mais il y a un risque avec un tel cadre. Celui-ci apparaît sur le graphique. Dans les quatre premières années des années 1990 (incluant la récession de 1990-1991), un régime de ciblage d’inflation moyen sur cinq ans qui inclut une période de restauration de deux ans se serait probablement traduite par une politique substantiellement plus restrictive que celle observée. En effet, la banque centrale aurait ciblé une déflation comprise entre -1,21 % et -0,17% !

Il faut noter que le ciblage d’inflation moyenne (comme le ciblage du niveau des prix) peut se traduire par des épisodes au cours desquels la banque centrale veut réduire le niveau des prix, pas simplement l’inflation. Cela peut expliquer pourquoi aucune banque centrale n’a explicitement adopté un tel cadre, du moins jusqu’à présent. Nous notons aussi qu’il est d’autant plus probable qu’une banque centrale cible la déflation que l’on élargit la fenêtre de moyennisation et réduit la période de restauration. Pour compenser cela, la banque centrale peut rendre flexibles ces deux périodes, mais cela diminuerait probablement la crédibilité de l’engagement de la banque centrale et son impact sur les anticipations d’inflation. Une alternative, proposée par Ben Bernanke, est de suivre une stratégie asymétrique : cibler l’inflation lors des expansions et ne cibler le niveau des prix que lors des récessions. Même si cela fait sens, nous pensons qu’il serait difficile de communiquer une telle approche de façon à stimuler les anticipations d’inflation au bon moment, lorsqu’une récession commence. (…) »

Stephen Cecchetti & Kermit Schoenholtz, « Average inflation targeting », in Money & Banking (blog), 24 août 2020. Traduit par Martin Anota

lundi 2 mars 2020

Une introduction aux ruées et paniques bancaires

Par Martin Anota le lundi 2 mars 2020, 15:00 - Monnaie et finance

« (…) Une banque promet à ses clients un accès immédiat à la liquidité. Les déposants peuvent retrouver leurs fonds à leur valeur faciale quand ils le désirent : premier arrivé, premier servi. D’autres créanciers de court terme peuvent faire la même chose, mais plus ou moins rapidement, en ne reconduisant pas leurs prêts. Et les ménages et entreprises qui payent des frais pour un engagement de crédit peuvent emprunter quand ils le veulent.

Pour les banques qui détiennent des actifs illiquides (comme la Bailey Brothers’ Building and Loan du film classique de Frank Capra), ces promesses de liquidité à la demande sont la source clé de la vulnérabilité. La même chose s’applique pour d’autres institutions bancaires (les banques de facto ou les institutions du système bancaire parallèle, les shadow banks) qui fournissent des services similaires à ceux que proposent les banques traditionnelles, en utilisant leurs bilans pour transformer des actifs illiquides, à longue échéance et risqués en actifs liquides, de courte échéance et peu risqués.

Une ruée bancaire (bank run) survient quand tous les déposants désirent réaliser un large volume de retraits simultanément. Une banque qui ne peut honorer cette soudaine demande fait faillite. Même les banques solvables (celles dont les actifs ont une valeur supérieure à celle de leurs dette) font faillite si elles ne peuvent convertir leurs actifs en liquidité assez rapidement (et avec peu de pertes) pour satisfaire les demandes des clients.

Une panique bancaire (banking panic) est le pluriel d’une ruée bancaire : quand les clients se ruent à de multiples banques. Nous qualifions de contagion la diffusion des ruées d’une banque à d’autres ; c’est le même terme qui est utilisé pour décrire la propagation d’un pathogène biologique.

L’histoire moderne des ruées et paniques bancaires commence au dix-septième siècle et s’étend jusqu’à aujourd’hui (…). Aucun pays n’y est immunisé : même les pays développés avec des systèmes financiers sophistiqués connaissent des crises bancaires (voir Laeven et Valencia). Surtout, ces perturbations sont typiquement associées à certaines des plus fortes contractions de l’activité économique enregistrées en temps de paix.

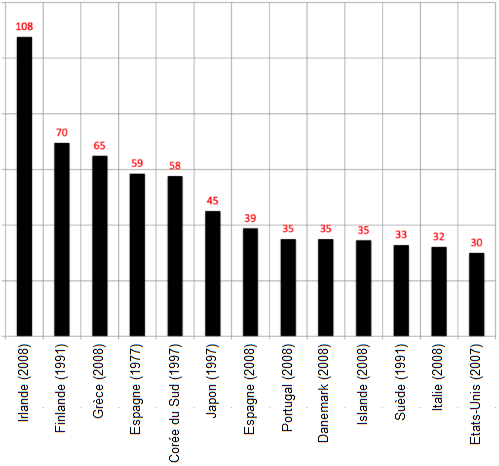

GRAPHIQUE Pertes en production occasionnées par les plus graves crises bancaires dans les pays développés depuis 1970 (en % du PIB potentiel)

source : Laeven et Valencia

Dans ce billet, nous caractérisons les sources des paniques et ruées bancaires, puis les outils dont nous disposons pour les prévenir ou les atténuer.

La théorie des ruées et paniques bancaires

La théorie moderne des ruées bancaires trouve son origine dans le modèle de Diamond et Dybvig. Dans ce dernier, la fragilité d’une banque vient directement des services de liquidité qu’elle fournit. Alors qu’elle détient des actifs illiquides, la banque offre aux déposants averses au risque de l’immédiateté : en l’occurrence, les déposants peuvent faire des retraits à la valeur faciale à la demande à n’importe quel moment. La banque est solvable (la valeur de ses actifs dépasse celle de ses dettes), mais elle est illiquide parce qu’elle ne peut pas convertir ses actifs immédiatement en liquidité sans connaître d’importantes pertes. Dans ce cadre, (…) ceux qui se ruent en premier aux guichets de la banque sont remboursés en totalité, alors que ceux qui patientent (ou ne vont pas assez rapidement à la banque) peuvent ne rien recevoir.

Dans le modèle Diamond-Dybvig, les ruées bancaires reflètent le déplacement d’un bon équilibre, où personne ne panique et où les retraits surviennent aléatoirement au cours du temps, à un mauvais équilibre, où les déposants impatients essayent tous de faire des retraits simultanément. Le bon équilibre, où chacun a confiance envers la banque, est fragile, tout comme ce fut le cas avec la Building and Loan de George Bailey. Cela signifie que les ruées bancaires sont autoréalisatrices : quand certains déposants croient que les autres vont se ruer à la banque, ils ont une incitation à se ruer en premier à celle-ci. Comme Doug Diamond l'a ensuite dit, "même les tâches solaires (sunspots) peuvent provoquer des ruées bancaires si tout le monde croit qu’elles le font".

En pratique, cependant, les tâches solaires ne provoquent généralement pas de ruées bancaires (…). En fait, ces dernières surviennent plutôt quand quelque chose survient et suscite un doute quant à la valeur des actifs de la banque. Dans l’ère de l’activité bancaire nationale des Etats-Unis (de 1863 à 1913), les ruées bancaires coïncidaient typiquement avec le pic des cycles d’affaires quand, en se tournant vers l’avenir, les créanciers des banques pouvaient anticiper une hausse des défauts de remboursement des emprunteurs (voir par exemple Gorton). Et des chocs dramatiques avec un impact économique significatif entraînaient une détérioration rapide des anticipations. Bruner et Carr attribuent les origines de la panique américaine de 1907 à l’effondrement de la liquidité provoqué par le séisme de San Francisco de 1906.

Dans le modèle Diamond-Dybvig, la seule incertitude à propos de la valeur des actifs de la banque est s’il va y avoir une ruée bancaire. Dans leur cadre stylisé, la panique elle-même force les banques à liquider en catastrophe leurs actifs à prix bradés, en donnant aux déposants une incitation à se ruer aux guichets. Dans un cadre plus réaliste, la difficulté que les créanciers ont pour observer la valeur des actifs de la banque rend la banque vulnérable aux ruées bancaires, une difficulté qui s’intensifie dans le sillage d’un large choc.

Ce problème de l’"attribut caché" (hidden attribute), dans lequel un prêteur ne peut observer sans coûts la solvabilité d’un emprunteur, est un aspect classique de la sélection adverse (…). En ne connaissant pas la valeur des actifs d’une banque après un choc, les déposants se posent des questions sur sa solvabilité. Ils peuvent aussi s’inquiéter à l’idée que la banque puisse être à peine solvable, avec seulement un petit tampon en fonds propres pour absorber les pertes d’une vente forcée d’actifs (ou un nouveau choc). Plus ce tampon est perçu comme faible, plus l’incitation à se ruer aux guichets est forte. (...)

Sans surprise, c’est en raison de l'antisélection que les ruées bancaires déclenchent des paniques bancaires. Quand les déposants d’une banque sont les témoins d’une ruée bancaire dans une autre banque, ils se posent naturellement des questions sur la solvabilité de la première. Ils ne peuvent être sûrs de celle-ci parce que leur banque est comme une boîte noire : ils ne peuvent observer sans coûts la valeur de ses actifs. En d’autres termes, les nouvelles à propos d’une ruée bancaire amène chacun à prendre conscience qu’il peut y avoir d’autres "lemons" parmi les banques.

Surtout, les déposants n’ont pas besoin de croire que leur banque est insolvable pour se ruer aux guichets. Il suffit qu’ils craignent qu’il n’y ait pas assez de fonds propres pour absorber les pertes résultant de la vente d’actifs en catastrophe provoquée par une ruée bancaire. Cette crainte va être bien plus forte si le système bancaire dans son ensemble est perçu comme sous-capitalisé. Dans ce cadre, un cercle vicieux peut apparaître : les ruées bancaires amènent les banques à vendre leurs actifs en catastrophe, ce qui aggrave les pertes en capital et accroître la vulnérabilité du système bancaire aux chocs. Pour maintenir la résilience des banques face à une telle incertitude, il est nécessaire qu’il y ait un minimum (…) de financement par voie de fonds propres.

Comme la contagion biologique, la contagion financière survient d’une "exposition commune" à un choc. Cependant, à la différence de la contagion biologique, qui résulte typiquement d’une transmission directe, la contagion financière n’a pas besoin de prendre la forme d’une série de défauts en cascade survenant d’une exposition à une contrepartie spécifique en faillite. Il peut y avoir un choc commun (comme un plongeon généralisé des prix d’actifs) qui suscite des doutes quant à la valeur des actifs de plusieurs banques. Le choc rend celles-ci collectivement vulnérables, entraînant une hausse du coût du financement et déclenchant des ventes forcées d’actifs. Une autre différence est que la propagation d’une maladie prend du temps dans la mesure où elle requiert habituellement une période d’incubation. La contagion financière peut survenir extrêmement rapidement.

Comment prévenir et atténuer les ruées et paniques bancaires

Le premier objectif d’un filet de sécurité financier public est d’empêcher qu’une ruée bancaire survienne ou s’aggrave. La première composante du filet de sécurité est le prêteur en dernier ressort. Comme l’indiquait Bagehot au dix-neuvième siècle, un système financier moderne a besoin d’une banque centrale prête à prêter sans limites aux entreprises solvables en contrepartie d’un bon collatéral fourni à un taux de pénalité. Les concepteurs de la Réserve fédérale fondaient le mandat originel du système sur ce principe : l’offre d’une monnaie élastique face aux perturbations financières. A condition que les banques soient bien capitalisées, l’existence d’un prêteur en dernier ressort crédible prévient les ruées bancaires.

La deuxième composante du filet de sécurité est une garantie publique. Les garanties publiques rendent les passifs bancaires insensibles aux informations : les nouvelles relatives à la performance des actifs d’une bancaire n’altèrent pas l’attractivité de la détention des passifs de cette dernière. A moins que les déposants doutent de la volonté ou de la capacité du gouvernement à payer, il n’y a pas d’incitation à se ruer aux guichets. Et, même si une banque faisait faillite, il n’y aurait pas d’incitation à se ruer aux guichets d’une autre banque. Les garanties crédibles empêchent les paniques bancaires.

L’assurance-dépôts (qui trouve son origine aux Etats-Unis avec la Federal Deposit Insurance Corporation et qui existe à présent dans près de 150 pays) est la forme la plus commune que prend cette garantie publique. Les gouvernements peuvent aussi garantir d’autres passifs bancaires, comme le faisait le FDIC en 2008 avec son Temporary Liquidity Guarantee Program. (...) »

Stephen Cecchetti et Kermit Schoenholtz, « Bank runs and panics: A primer », in Money & Banking (blog), 2 mars 2020. Traduit par Martin Anota

aller plus loin...

« Quel est le coût d'une crise financière ? »

« Les coûts ignorés de la crise financière »

vendredi 11 août 2017

Il y a tout juste dix ans éclatait la crise financière mondiale

Par Martin Anota le vendredi 11 août 2017, 12:00 - Monnaie et finance

« L’évaporation complète de la liquidité dans certains segments du marché américain de la titrisation a rendu impossible la valorisation adéquate de certains actifs (…). »

BNP Paribas, 9 août 2007

« Dans son mémorable examen des 21 livres à propos de la crise financière de 2007-2009, Andrew Lo a évoqué le film classique de Kurosawa, Rashômon, pour caractériser les remarquables différences entre ces comptes-rendus de la crise. Non seulement il n’y a pas d’accord sur les interprétations, mais il n’y en a pas non plus sur les faits : "Même sa date de départ n’est pas claire. Devons-nous marquer son commencement au pic de la bulle immobilière américaine au milieu de l’année 2006 ou avec l’effondrement de la liquidité dans le système bancaire parallèle à la fin de l’année 2007 ou bien avec le dépôt de bilan de Lehman Brothers et le passage en rendement négatif des actifs du fonds monétaire Reserve Primary Fund en septembre 2008 ?"

Selon nous, la crise a commencé il y a tout juste dix ans cette semaine. Le 9 août 2007, BNP Paribas annonça que, parce que leurs gestionnaires de fonds ne pouvaient plus valoriser les actifs dans trois fonds mutuels, ils suspendaient leurs souscriptions et rachats. Avec le recul d’une décennie, nous y voyons l’occasion propice pour revoir à la fois les signes avant-coureurs et le début de la pire crise financière depuis la Grande Dépression des années trente. Dans nos futures billets (…), nous espérons revoir d’autres aspects de la crise, notamment les diverses réponses politiques et les épisodes clés impliquant les paniques sur la Bear Stearns, Lehman Brothers, les entreprises sponsorisées par le gouvernement et AIG.

Mais, commençons par le commencement : qu’est-ce qu’une crise financière ? Selon nous, le terme se réfère au passage soudain et non anticipé d’un équilibre assez sain (caractérisé par des marchés financiers très liquides, de faibles primes de risque, un crédit facilement disponible et une faible volatilité des prix d’actifs) à un très mauvais équilibre (caractérisé par les aspects inverses). Nous utilisons le terme « équilibre » pour refléter un état persistant des conditions financières et notons qu’(…) il est facile de passer d’un bon état financier à un mauvais, mais très difficile d’aller dans le sens inverse. Le mauvais état est habituellement associé à une hausse du co-mouvement des prix d’actifs : une contagion entre les entreprises, les marchés et les juridictions géographiques ; et une rétroaction adverse entre le système financier et l’économie réelle, si bien qu’un l’un des deux se détériore, l’autre s’aggrave. (…)

(…) A l’instant de l’annonce de BNP Paribas, le système était extrêmement fragile, si bien qu’il ne fallut pas beaucoup de temps pour qu’il s’écroule. Dans cette optique, les systèmes financiers présentent des équilibres multiples, si bien qu’une crise requiert seulement une étincelle pour allumer l’explosif qui ferait basculer le système d’un bon équilibre à un mauvais. Le modèle classique de Diamond et Dybvig des paniques bancaires présente exactement cette propriété, comme une perte de confiance mène au passage autoréalisateur d’un équilibre où chacun agit comme si les banques sont solvables à un équilibre où ce n’est plus le cas.

Selon nous, cependant, la vraie question est différente : Pourquoi est-ce que le système financier était-il si vulnérable qu’une perturbation relativement faible puisse déclencher un incendie ? Quand les ingénieurs civils construisent des ponts, ils cherchent des manières de les rendre résilients aux chocs, comme les vents violents ou le passage fréquent de piétons (…). Heureusement, les ingénieurs qui observent une vulnérabilité peuvent fermer temporairement un pont et installer des absorbeurs de chocs pour qu’il puisse fonctionner en toute sécurité (…).

Nous ne pouvons fermer un système financier moderne (du moins pas longtemps) sans nuire à l’économie dans son ensemble. Donc, les concepteurs du système doivent anticiper la nécessité de mettre en place des absorbeurs de chocs. Avec le recul, nous pouvons dire avec certitude que les systèmes financiers américains et européens en 2007 nécessitaient deux absorbeurs de chocs clés dont ils étaient dépourvus : un capital adéquat pour faire face aux chutes des prix d’actifs et aux défauts et des détentions adéquates d’actifs liquides de haute qualité pour faire face à une chute temporaire de liquidité.

En 2007, la plus importante vulnérabilité était associée à une pénurie de capital. Comme Greenlaw et ses coauteurs (2008) le décrivirent, les pertes hypothécaires dégradèrent la capitalisation d’intermédiaires fortement endettés, les exposant davantage aux paniques. Et, comme Greenlaw et ses coauteurs (2011) l’expliquent également, les créanciers ne sont pas incités à attendre que les intermédiaires deviennent solvables avant de prendre panique : par conséquent, le seuil pour que se déclenche une panique est habituellement atteint quand la valeur des actifs excède encore celle des passifs.

Si les banques commerciales, les conduits (SIV), les fonds monétaires, les banques d’investissement et autres institutions financières avaient été adéquatement capitalisés et avaient un financement de dette suffisamment stable, les efforts agressifs des banques centrales visant à stimuler l’offre du crédit après août 2007 auraient été plus efficaces pour réduire les coûts de financement et les primes de liquidité. Ces mesures auraient aussi donné plus de temps aux créanciers pour trouver quels titres liés au crédit hypothécaire étaient réellement toxiques.

Alors que la pénurie de capital agrégée est importante pour le système dans son ensemble, les pénuries importent aussi pour les intermédiaires pris individuellement. Pour voir cela, considérons les estimations de risque systémique (SRISK) élaborées par le Volatility Lab de l’Université Stern de New York, défini comme la chute de capital attendue d’une firme financière individuelle conditionné à un large déclin du marché des fonds boursiers. Le SRISK constitue un stress-test en temps réel à la fois d’entreprises financières spécifiques et (du point de vue collectif) du système financier. Et, à la fin de juillet 2007, peu de temps avant le choc BNP Paribas, seulement 20 des 93 larges intermédiaires américains présentèrent une chute attendue de capital. Parmi ces 20 institutions, les 10 plus grosses représentèrent 88 % de la chute agrégée (SRISK). Chose frappante, au cours de la crise, durant les 18 mois suivants, 9 de ces 10 institutions se retrouvèrent soit fermées, soit rachetées par d’autres intermédiaires, soit nationalisées, soit renflouées avec les injections de capital du gouvernement dans le cadre du TARP de 2008 ! Si le SRISK (ou une autre mesure du risque systémique) avait été disponible pour le public en 2007, les observateurs aurait saisi le sérieux de la pénurie de capital aussi bien pour les institutions individuelles que pour le système dans son ensemble bien avant que les phases les plus aiguës de la crise se développent en 2008.

La conclusion ? Avec un recul d’une décennie, les faits clés à propos de la crise financière de 2007-2009 sont clairs. Ce qui débuta comme une perte de liquidité sur des marchés d’instruments complexes et opaques liés au crédit hypothécaire se traduisit soudainement le 9 août à l’évaporation de liquidité de financement pour les intermédiaires détenant ces titres (ou essayant de les utiliser comme collatéraux). Cet événement eut lieu parce que le système était exceptionnellement fragile, ce qui le laissait vulnérable même pour de petites perturbations. Et, ensuite, puisque les banques européennes ont été actives sur ces marchés américains, le problème acquiert une échelle internationale (du moins en Europe et en Amérique du Nord). Mais, ce qui rendit la crise si profonde et si longue (et si dommageable à l’économie mondiale), c’est que les pertes touchèrent un système financier qui était dès le début inadéquatement capitalisé.

Nous espérons que, cette semaine, les régulateurs et les participants de marché prennent un instant pour se rappeler ces leçons durement apprises. »

Stephen Cecchetti et Kermit Schoenholtz, « Looking back: The financial crisis began 10 years ago this week », in Money & Banking (blog), 7 août 2017. Traduit par Martin Anota

mercredi 26 juillet 2017

L’autre triangle des incompatibilités : le trilemme financier

Par Martin Anota le mercredi 26 juillet 2017, 17:00

« Les banques internationales sont internationales dans la vie, mais nationales dans la mort »

Mervyn King

« Les cours en économie internationale présentent habituellement aux étudiants la "trinité impossible" (ou "triangle des incompatibilités" ou encore "trilemme" en économie ouverte), à savoir l’idée selon laquelle il y a incompatibilité entre la fixité du taux de change, la libre circulation des capitaux au niveau international et l’autonomie de la politique monétaire. Pourquoi ? Parce qu’avec la mobilité internationale des capitaux dans un régime de taux de change rigide, les préférences en termes de devises des agents privés (et non des décideurs publics) déterminent la taille du bilan de la banque centrale et donc le taux d’intérêt domestique. (…)

Mais si beaucoup d’étudiants ont appris qu’un pays peut obtenir au maximum deux des trois éléments du trilemme en économie ouverte, peu d’entre eux savent qu’il existe aussi un trilemme financier. Selon celui-ci, la stabilité financière, l’intégration financière internationale et les politiques financières nationales sont incompatibles entre elles (…). Le raisonnement derrière ce second trilemme est le suivant. L’approfondissement de l’intégration financière réduit les incitations des autorités publiques nationales à agir de façon à préserver la stabilité financière au niveau mondial. Ou, pour le dire autrement, comme les bénéfices tirés des politiques de stabilité financière se diffusent au-delà des frontières du pays, les autorités nationales sont moins enclines à supporter les coûts d’une stabilisation du système au niveau national. Par conséquent, si nous poursuivons l’intégration financière, alors nous devons nous appuyer davantage sur la coordination internationale entre les différents régulateurs financiers internationaux (…). Cette conclusion s’applique partout, mais surtout au sein de la zone euro, où les responsables de politique économique désirent un marché financier pleinement intégré, mais tout en continuant de protéger leurs champions nationaux (…).

Nous estimons que Dirk Schoenmaker est celui qui a le mieux exposé le trilemme financier (…). Dans son modèle simple, le problème apparaît en comparant les bénéfices (B) et les coûts (C) de la stabilisation d’une banque lors d’une crise. La stabilisation bénéficie à l’économie en permettant d’éviter une contagion financière et, par conséquent, contribue à soutenir l’offre de crédit et l’activité économique. Les coûts sont ceux imposés aux contribuables lorsque le secteur public recapitalise les banques fragiles, comme ce fut le cas avec la plupart des renflouements au cours de la crise de 2007-2009. (…)

Dans le cas d’une banque purement domestique, un régulateur compare ces coûts et bénéfices, choisissant de mettre en œuvre une résolution soutenue par le secteur public quand les bénéfices (B) sont supérieurs aux coûts (C). Sinon, les autorités vont fermer la banque, laisser les actionnaires et les contreparties supporter les pertes. Cependant, plus la part de l’activité étrangère (s) de la banque en difficulté est large, plus les étrangers tireront relativement plus de bénéfices de la recapitalisation par rapport aux résidents domestiques. En l’absence de coopération internationale, le régulateur domestique compare les bénéfices domestiques de la stabilisation, c’est-à-dire (1-s)xB, par rapport au coût (purement domestique) de la stabilisation (C). Alors qu’une recapitalisation stabiliserait le système financier international si les bénéfices excèdent les coûts (B>C), les régulateurs nationaux vont seulement procéder à une recapitalisation publique si les bénéfices publics sont supérieurs aux coûts, c’est-à-dire si (1-s)xB>C. Dans le cas contraire, c’est-à-dire si les bénéfices des étrangers représentent une proportion suffisamment large du total, c’est-à-dire si (1-s)<C/B, alors les autorités nationales vont choisir de fermer la banque, au risque de générer une contagion et de déstabiliser le système financier international.

Le paradoxe de Mervyn King (cité en en-tête du billet) souligne ce conflit entre les bénéfices et les coûts internationaux et nationaux de la réponse à la faillite des banques internationaux. Cela signifie qu’en définitive seulement deux régimes sont cohérents avec la stabilité financière : un premier régime où l’activité transfrontalière est complète et un second régime où celle-ci est très limitée. Mais le premier régime requiert d’amples coopération et coordination entre les régulateurs nationaux. Cette coordination doit être préétablie et crédible ; elle ne peut être organisée de façon fiable et ad hoc durant une crise, lorsque les régulateurs n’ont ni le temps ni l’inclinaison à négocier des accords exceptionnels pour se partager le fardeau. Le second régime ne requiert pas de coordination, comme les incitations des régulateurs nationaux suffisent pour promouvoir des politiques de stabilisation dans une crise (c’est-à-dire, si B>C), mais avec un tel système l’économie se prive des bénéfices de la finance transfrontalière.

De notre point de vue, le trilemme financier s’applique bien au-delà du problème que rencontre Schoenmaker en recherchant un mécanisme approprié pour partager les coûts associés à la résolution des banques internationales. L’une des raisons est que les banques mondiales ne sont pas les seules sources d’instabilité transfrontalière potentielle. Les risques systémiques peuvent notamment être générés ou transmis par les activités pseudo-bancaires d’institutions non bancaires (considérons l’impact de la sortie d’un fonds monétaire de la zone euro au sommet de la crise) (…) et les vulnérabilités même dans l’architecture financière (…), pour ne citer que quelques exemples.

Une autre inquiétude est que, de façon à limiter la probabilité d’une crise financière, les coûts qu’il y a à assurer la résilience financière doivent être pré-payés en période de bonne conjoncture (disons, via des exigences en capital et en liquidité). Si les bénéfices d’une prévention de la crise débordent au-delà des frontières (comme le font les bénéfices de la résolution dans le modèle de Schoenmaker), les régulateurs nationaux seront moins incités à pré-payer la prévention des crises.

Bien évidemment, le problème du trilemme financier survient seulement si le système financier international est très intégré. A quel point est-il intégré ? (…) La réponse simple est : il ne l’a jamais été autant. Cependant la dynamique d’approfondissement rapide de l’intégration entre 1980 et 2007 s’est stoppée avec la crise financière. Et, depuis 2007, un élément d’intégration dans les pays développés (l’activité transfrontalière des banques) a décliné (comme l’ont notamment montré Lane et Milesi-Ferretti).

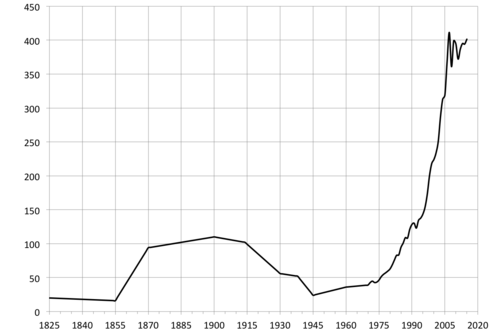

Le graphique ci-dessous représente un indicateur large de l’intégration financière pour lequel nous avons une longue série de données historiques : le ratio rapportant le montant des actifs et passifs externes sur le PIB. Selon cette mesure, qu’Obstfeld et Taylor appellent "la seconde vague" de la mondialisation commença autour de 1980 et dépassa "la première vague", qui a été associée à l’époque de l’étalon-or précédant la Première Guerre mondiale. Comme le dernier rapport annuel du BRI le souligne, la mondialisation financière des quarante dernières années a contribué à amélioré les niveaux de vie en soutenant le commerce international et l’investissement et en améliorant l’allocation des ressources et la gestion du risque. Parallèlement, les bénéfices nets seraient substantiellement plus larges si les coûts clés, tels que la transmissions internationale de crises que la mondialisation financière facilite, étaient mieux gérés.

GRAPHIQUE Actifs et passifs externes mondiaux (en % du PIB)

source : BRI

(…) Vers quel équilibre de long terme du trilemme financier allons-nous ? Allons-nous vers un équilibre qui préserve ou approfondie davantage le niveau déjà élevé d’intégration ? Ou allons-nous vers un équilibre dans lequel les régulateurs et les intermédiaires restent derrière les frontières nationales pour assurer la stabilité financière ? Ou allons-nous maintenir une combinaison instable et inquiétante (comme celle actuelle) où le déséquilibre de l’intégration internationale avancée et la régulation nationale nous laisse vulnérables à de nouvelles perturbations financières survenant dans l’économie domestique ou dans le reste du monde ?

(…) Le danger d’une fragmentation financière persiste. Les régulateurs ne peuvent être sûrs que les capitaux, la liquidité et les accords de résolution en place aujourd’hui suffisent pour empêcher une autre crise. Et, parce que ces problèmes peuvent se transmettre rapidement d’un pays à l’autre dans un monde intégré, le trilemme financier nous dit que les régulateurs nationaux doivent s’inquiéter de la résilience des autres systèmes financiers. Ils doivent aussi savoir si les innovations ailleurs vont permettre aux entreprises de contourner les règles communes. Par conséquent, une plus grande coopération et un meilleur partage de l’information vont sûrement être nécessaires pour maintenir le statu quo d’une forte intégration.

En considérant ses bénéfices à long terme, nous espérons que le trilemme financier sera résolu en faveur d’un approfondissement (et non un retrait) de l’intégration financière. Mais, si la coordination se révèle inadéquate ou si l’information pertinente à propos des autres juridictions s’avère difficile à vérifier, alors il faudra opter pour le retrait. Nous commençons déjà à voir ce retrait, comme les autorités requièrent que les entreprises internationales ramènent leurs actifs, capitaux et liquidité à l’intérieur des frontières nationales. Si cette dynamique se poursuivait, ce serait une manière tristement inefficace de résoudre le paradoxe de Mervyn King. »

Stephen Cecchetti et Kermit Schoenholtz, « The other trilemma: Governing global finance », in Money & Banking (blog), 24 juillet 2017. Traduit par Martin Anota

« billets précédents - page 1 de 2