« On m’a demandé à plusieurs reprises, et notamment il y a à peine quelques jours, pourquoi dans Visions of Inequality je ne discutais pas de Keynes. Je ne lui ai consacré aucun chapitre et, quand je l’ai évoqué, ce n'est qu’incidemment et simplement en lien avec la propension marginale à consommer.

Ma réponse est double. D’une part, je pense que Keynes ne s’intéressait pas à la répartition des revenus. Et, plus important encore, à un moment où il aurait pu le faire (voire aurait dû) aborder la question de la répartition des revenus, il a refusé de le faire et a décidé de l’ignorer.

Tout au long de la Théorie générale, il est tacitement supposé que la répartition fonctionnelle des revenus (la part du travail dans la production totale) ne variait pas. Keynes croyait, ou prétendait croire, à ce qu'on appelle la "loi de Bowley", c’est-à-dire à la relative fixité des parts du travail et du capital dans le revenu national, que l’on a observée en Grande-Bretagne au cours des deux premières décennies du vingtième siècle. Le fait que "la loi" ne s’applique qu’à un seul pays et soit valable pendant une courte période ne semble pas avoir gêné Keynes. Cela signifie que Keynes croyait que les inégalités de revenus interpersonnelles étaient également constantes. Si les inégalités tant fonctionnelles qu’interpersonnelles sont constantes, il n’est pas nécessaire de discuter de la répartition des revenus, et Keynes n’en a d'ailleurs pas du tout parlé.

La seconde raison est plus intéressante et, dans une certaine mesure, plus dramatique. Elle illustre ce que je crois être la réticence politique de Keynes à introduire la question de la répartition des revenus dans la Théorie générale.

Il est bien connu que l’insuffisance de la demande effective, le principal sujet du livre, vient du fait que la somme de la consommation et de l’investissement privé n'est pas nécessairement égale à l’offre globale. Comme l’écrit Keynes, la consommation totale n’augmente pas autant que la production globale. Cela signifie que l'écart entre les deux (c’est-à-dire entre, d’une part, l’offre globale, et, d’autre part, la consommation totale) doit être comblé par l’investissement privé. Ce n’est que dans un cas particulier que l’investissement privé désiré sera exactement égal à cet écart. Mais lorsque l’investissement privé ne suffit pas, les dépenses publiques doivent être augmentées pour accroître la demande effective et ainsi équilibrer l’offre et la demande globales (à un niveau d’emploi donné).

Même un examen très succinct de l'équation fondamentale qui est A (offre globale) = C + I + G montre que si C (la consommation agrégée) est fonction de la répartition des revenus, un moyen évident de rééquilibrer l'offre et la demande globales est d'"améliorer" la distribution des revenus, c'est-à-dire de transférer du pouvoir d'achat des riches vers les pauvres. Si 1 euro est transféré d’une personne riche qui n'en aurait normalement consommé que 50 centimes à une personne pauvre qui en consommerait 95 centimes, la consommation agrégée augmentera. On peut ensuite affiner ce transfert jusqu’à ce que l’écart entre l’offre globale et la demande effective/globale soit comblé. Il n’est pas nécessaire d’introduire les dépenses publiques, G.

La question est alors de savoir pourquoi Keynes n’a pas emprunté une telle voie si évidente pour sortir d’une situation de demande insuffisante. Il avait devant lui deux possibilités : l’une était d’augmenter les dépenses publiques et la seconde était de redistribuer les revenus vers les pauvres. Cette dernière solution est plus simple et s’inscrit entièrement dans la logique du modèle lui-même, notamment dans la logique du nouveau concept de "propension à consommer" introduit par Keynes. Mais si l’on suppose que la répartition des revenus est inchangée ou inchangeable ou si l’on ne veut pas toucher à la répartition des revenus pour des raisons politiques, alors la seule issue est celle choisie par Keynes : l’augmentation des dépenses publiques.

Il est remarquable que dans l’ensemble de la Théorie générale, la répartition des revenus ne joue absolument aucun rôle. (...)

Le fait que Keynes était conscient que la répartition des revenus peut affecter la propension à consommer est visible, très brièvement et discrètement, dans quelques références du chapitre 22 (intitulé "Note sur le cycle économique" ; plus important encore, le chapitre n’est pas dans la partie principale du livre, mais dans les "Notes succinctes suggérées par la théorie générale", réflexions assez diverses stimulées par la rédaction du texte principal), où Keynes écrit : "Je dois facilement admettre que la voie la plus sage est d'avancer sur les deux fronts" (c’est-à-dire augmenter les investissements et la consommation) "simultanément. Tout en visant un taux d'investissement socialement contrôlé en vue d'un déclin progressif de l'efficacité marginale du capital, je devrais en même temps soutenir toutes sortes de politiques visant à accroître la propension à consommer. En effet, il est peu probable que le plein emploi puisse être maintenu, quoi que nous fassions en matière d’investissement, avec la propension à consommer existante. Il est donc possible que les deux politiques opèrent ensemble : promouvoir l’investissement et, en même temps, promouvoir la consommation". Puisque cette section s’ouvre par une discussion claire des "écoles de pensée" qui "maintiennent que la tendance chronique des sociétés contemporaines à connaître du sous-emploi est imputable à la sous-consommation ; (…) c’est-à-dire (…) à une répartition des richesses qui se traduit par une propension à consommation qui est indûment faible", il est clair que l’augmentation de la consommation à laquelle Keynes pense ici vient d’un changement de la répartition des richesses ou des revenus. Cependant, là aussi, il croit qu’il est plus rapide et préférable de chercher à augmenter l’investissement et, si nécessaire, les dépenses publiques (puisque l’investissement entraîne une augmentation des capacités de production) que de modifier la répartition pour stimuler la consommation. Dans la Théorie générale, c’est ici où Keynes est allé le plus loin dans la reconnaissance du rôle de la répartition des revenus.

L’omission quasi universelle de la répartition des revenus a été rapidement notée. Dans un article de 1937 dans The Review of Economics and Statistics, Hans Staehle montre comment la répartition des salaires en Allemagne a changé au cours de la période allant de 1928 à 1934 et comment ce changement a affecté la consommation. Il fait part de son incrédulité quant au fait que Keynes ait pu négliger une force manifestement aussi puissante qui affecte la propension globale à consommer et, par conséquent, la demande effective. (...)

La décision de ne pas utiliser "l’amélioration" de la répartition des revenus pour résoudre le manque de demande globale a pu être motivée, je pense, par des raisons politiques. En comparant l’acceptabilité politique ou les risques politiques des deux solutions, Keynes a probablement décidé qu’un G plus grand était plus acceptable politiquement et idéologiquement. Bien sûr, aucune des deux approches n’était politiquement facile. La majorité dans la profession des économistes et dans les milieux d’affaires de l'époque (par exemple la Chambre de commerce des Etats-Unis à la fin des années 1930) était opposée à l'augmentation des dépenses publiques. Elle impliquait une hausse des impôts ou l’impression de monnaie fiduciaire et sûrement une plus grande implication du gouvernement dans l’économie. Mais Keynes a pu penser que plaider en faveur de la redistribution aurait pu être politiquement encore moins populaire parmi les classes dirigeantes et que ses théories auraient été encore moins acceptées dans le milieu universitaire, en le rapprochant de trop de Hobson, de Sismondi et des "écoles de pensée" similaires pour rassurer.

Je pense qu’il ne fait aucun doute que Keynes, selon l’interprétation la plus favorable, ne s’intéressait pas à la répartition des revenus parce qu’il pensait que, du moins analytiquement, elle pouvait être considérée comme fixe dans ses aspects fonctionnels et interpersonnels. Une interprétation moins charitable de ce qu'il a fait est de dire qu'il craignait que ses théories ne soient confondues avec celles des "sous-consommationnistes" du "monde souterrain de l'économie" (selon les termes de Keynes), qui avaient tendance à plaider en faveur d’un changement de la répartition des revenus comme solution au manque de demande effective. Keynes ne voulait pas "être" comme eux et il a donc tout du long ignoré la répartition des revenus.

Post-scriptum. Dans le tout premier chapitre des Conséquences économiques de la paix, Keynes mentionne la répartition des revenus, mais d'une manière inhabituelle, pour affirmer que les fortes inégalités observées la veille de la Première Guerre mondiale n'étaient pas socialement déstabilisatrices tant que les riches ne se livraient pas à une consommation ostentatoire, mais utilisaient leur argent en excédent pour financer des investissements qui, bien sûr, créaient des emplois. "Les classes capitalistes pouvaient s’approprier la meilleure part du gâteau et étaient théoriquement libres de la consommer, sous réserve tacite qu’elles en consommaient très peu en pratique". Ce n’étaient que de simples vaisseaux par lesquels circulait l’excédent de pouvoir d’achat pour se transformer en investissements. Cela faisait partie, selon Keynes, du pacte social qui existait avant la guerre et qui garantissait la paix sociale : "Je cherche seulement à souligner que le principe d’accumulation basé sur les inégalités était un élément vital de l’ordre de la société d’avant-guerre et du progrès tel qu’on l’entendait alors". Il n’était pas sûr que cela ait perduré après la guerre. »

Branko Milanovic, « Why not Keynes? Keynes’ uneasy relationship with income distribution », 21 avril 2024. Traduit par Martin Anota

aller plus loin... lire « Keynes était-il socialiste ? »

dimanche 21 avril 2024

La relation compliquée de Keynes avec la répartition des revenus

Par Martin Anota le dimanche 21 avril 2024, 21:00

Les liens de la semaine

Par Martin Anota le dimanche 21 avril 2024, 17:00

Environnement et ressources naturelles

- Au Sahel, la vague de chaleur extrême est bien due au changement climatique (Le Monde)

- "Urgence climatique" : l’itinéraire d’une expression (The Conversation)

- L’eau en commun (La Vie des idées)

(In)action écologique

- Peut-on s’adapter au changement climatique sans davantage de moyens ? (Alter éco)

- La croisade hypocrite des droites contre l’écologie "punitive" (Alter éco)

- Ecologie : le gouvernement français enclenche la marche arrière (Alter éco)

- En Allemagne, le bashing antiécolo est au zénith (Alter éco)

- En Suède, un alarmant virage à droite sur le climat (Alter éco)

- Vers le plan vert (La Vie des idées)

- Climat : derrière les objectifs chiffrés, une édulcoration des connaissances scientifiques ? (The Conversation)

Croissance, fluctuations et crises

- L’économie mondiale reste résiliente, mais la croissance est inégale ; des difficultés se profilent à l’horizon (Pierre-Olivier Gourinchas)

- Pourquoi l’Europe décroche par rapport aux Etats-Unis (Alter éco)

- Un monde sans croissance ? Nous le connaissons déjà mais ce n’est pas celui qui est souhaitable (Christian Chavagneux)

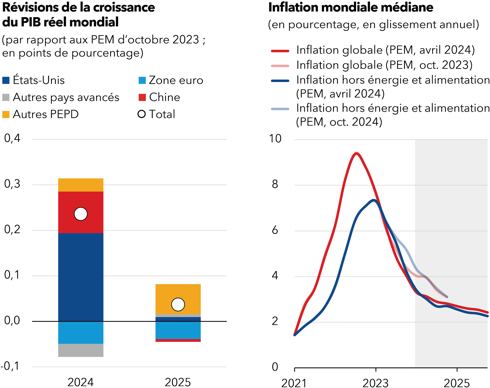

GRAPHIQUE Prévisions de croissance et d'inflation

source : FMI (2024)

Marchés et concurrence

- La Commission européenne s’attaque aux géants du numérique (Alter éco)

- La légalisation du cannabis dans un pays entraîne-t-elle forcément une hausse de la consommation ? (Le Monde)

- L’héritage intellectuel de Janos Kornai : un examen du paradigme systémique et des contraintes budgétaires lâches (AFSE)

Monnaie et finance

- Les banques centrales doivent rester vigilantes dans le dernier kilomètre sur la voie de la désinflation (FMI)

- La banque centrale européenne doit-elle baisser rapidement ses taux ? (Alter éco)

- La BCE prend un risque en baissant ses taux d’intérêt dès le printemps 2024 (Patrick Artus)

Finances publiques

- Pourquoi la modération budgétaire doit être de mise dans le monde en 2024, plus grande année électorale de l’histoire (FMI)

- Finances publiques : l’exécutif dans le piège budgétaire (Le Monde)

- Le Haut Conseil des finances publiques déplore le "manque de crédibilité" et de "cohérence" de la trajectoire financière du gouvernement (Le Monde)

- Dette publique : arrête-moi si tu peux (Emmanuel Combe)

- Et si la France n’avait pas besoin de réduire son déficit public ? (Patrick Artus)

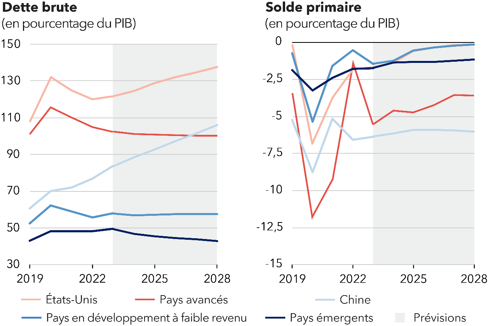

GRAPHIQUE Prévisions de dette publique et de solde primaire

source : FMI (2024)

Commerce international

- 30 ans après sa création, l’OMC en mort cérébrale (Jean-Marc Siroën)

- La zone euro ne peut plus utiliser une stratégie mercantiliste (Patrick Artus)

- Un grave problème d’offre ou un grave problème de compétitivité pour l’industrie de la zone euro ? (Patrick Artus)

- Que se passe-t-il si un pays subventionne une activité pour laquelle il n’a pas d’avantage comparatif ? (Patrick Artus)

- La Chine exporte ses capacités excédentaires : quelle réaction de l’Europe ? (Patrick Artus)

Economie du bien-être

- L’âge du désespoir : la courbe du bonheur est devenue monotone (Esprits animaux)

Sociabilité

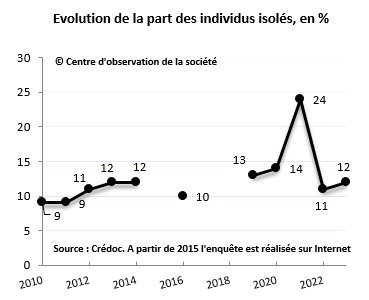

- Qui souffre d’isolement en France ? (Centre d'observation de la société)

- Insta, TikTok, BeReal : pourquoi on se (la) raconte sur les réseaux sociaux (The Conversation)

Inégalités et stratification sociale

- Les castes et l’État en Inde. Entretien avec Rohini Somanathan (La Vie des idées)

- Nous avons besoin d’une renaissance de l’analyse marxiste des classes sociales (Contretemps)

Santé

- "Taxe lapin" et inégalité d’accès aux soins : un possible effet pervers ? (Alter éco)

- Augmenter le délai de carence réduit-il le nombre d’arrêts maladie ? (Alter éco)

Travail, emploi

- L’exorbitante rémunération de Carlos Tavares chez Stellantis (Le Monde)

- Pourquoi les rémunérations des grands patrons continuent d’exploser (The Conversation)

- Salaire décent - Un bouleversement macroéconomique ? (Philippe Waechter)

- Qui sont les travailleurs à bas revenus d’activité et quelles sont leurs situations sur le marché du travail ? (Dares)

- Y a-t-il substitution de travail au capital dans la zone euro ? (Patrick Artus)

Politique

- La pente de plus en plus droitière de Gabriel Attal (Le Monde)

- Elections européennes : des partis d’extrême droite plus nombreux et plus puissants (Le Monde)

- Les cent jours de Donald Tusk ou la déconstruction d’une démocratie illibérale (Télos)

Contrôle social et déviance

- Justice des mineurs : Gabriel Attal dans la lignée de 80 années de durcissements (Le Monde)

- Mayotte : pour une déconstruction de l’association bidonville – illégalité – délinquance (Métropolitiques)

- "Certaines utilisations de la laïcité sont un paravent commode pour justifier des discriminations" (Stéphanie Hennette-Vauchez)

voir la précédente revue de presse

voir le graphorama de la semaine

mercredi 17 avril 2024

Les gouvernements peuvent-ils financer leurs déficits en créant de la monnaie ?

Par Martin Anota le mercredi 17 avril 2024, 10:44 - Politique monétaire

« Les adeptes de la MMT disent souvent que financer les dépenses publiques (moins les impôts) en émettant de la dette publique est un choix politique, car on pourrait plutôt créer des réserves (monnaie électronique) auprès des banques commerciales. Bien entendu, seuls les gouvernements qui disposent de leur propre monnaie peuvent le faire, cette option n’est donc pas disponible pour les gouvernements de la zone euro par exemple. Si les gouvernements pouvaient financer les déficits en créant de la monnaie/des réserves, voudraient-ils le faire ?

La réponse que l’on pourrait trouver dans les manuels est que le financement monétaire est inflationniste. C'est pourquoi la plupart des gouvernements délèguent la création de réserves à des banques centrales indépendantes. Cela ne tient pas à un monétarisme crû : dans le courant orthodoxe en macroéconomie, l’idée selon laquelle il existe un lien de causalité prévisible allant de la création monétaire à l’inflation est morte il y a plusieurs décennies, et aujourd’hui seule une poignée de personnes y croient. Au lieu de cela, on trouve dans les manuels l’idée selon laquelle une création de monnaie par les gouvernements nuirait à la capacité des banques centrales à contrôler les taux d’intérêt à court terme. Le financement monétaire pousserait les taux d’intérêt à zéro, ce qui serait inflationniste.

Cependant, les manuels sont presque toujours obsolètes et cette explication du caractère inflationniste du financement monétaire est devenue largement hors de propos lorsque les banques centrales ont commencé à payer des intérêts sur les réserves. Les réserves sont comme de la monnaie électronique détenue par les banques commerciales et leur quantité est contrôlée par les banques centrales. Aujourd’hui, les banques centrales contrôlent les taux d’intérêt à court terme en payant ces taux d’intérêt sur les réserves. En conséquence, il est possible de créer d’importantes quantités de monnaie/réserves sans que cela n’entraîne une hausse de l’inflation.

Nous le savons avec l’assouplissement quantitatif (quantitative easing, QE), par lequel les banques centrales ont créé d’importantes réserves afin d’acheter de la dette publique. Lorsqu’elles ont fait cela après la crise financière mondiale, nous n’avons pas eu d’hyperinflation ! L’idée selon laquelle l’inflation récente est le résultat du nouvel assouplissement quantitatif mis en place pendant la pandémie est tout simplement ridicule. Ce que l’expérience récente nous montre c’est qu’il est parfaitement possible pour les banques centrales de contrôler l’inflation même lorsqu’il y a beaucoup d’argent/de réserves dans le système.

Alors, si les banques centrales peuvent créer de grandes quantités de monnaie tout en contrôlant l’inflation, pourquoi les gouvernements ne peuvent-ils pas financer leurs déficits en créant de la monnaie ? Si des intérêts sont payés sur cette monnaie/ces réserves et si les banques centrales ont un contrôle total sur la fixation de ce taux d’intérêt, il n’y a aucune raison de croire que le financement monétaire des déficits serait plus inflationniste que le financement des déficits par émission d’obligations. C’est ce que la MMT veut dire lorsqu’elle affirme que le

financement obligataire est un choix politique.

Nous pourrions aller plus loin et dire que l’assouplissement quantitatif a été l’équivalent d’un financement monétaire des déficits courants et passés. Que cela soit survenu parce que les banques centrales voulaient faire pression à la baisse sur les taux d’intérêt de long terme et non parce que les gouvernements ont choisi la finance monétaire n’est qu’une question de motifs. En pratique, nous avons fini à peu près au même endroit que si les gouvernements avaient financé leurs déficits à partir d’une certaine date passée en créant des réserves.

Bien sûr, rien de cela n’aurait eu d’importance si les gouvernements n’avaient pas eu de raisons d’être intéressés par le financement monétaire des déficits. La raison évidente expliquant pourquoi ils pourraient y trouver un intérêt est que le financement monétaire était moins cher que l’émission de dette sur le marché obligataire. La création de monnaie/réserves entraîne un coût égal au niveau auquel la banque centrale fixe le taux d’intérêt de court terme. L’émission de dette peut entraîner un coût similaire si cette dette était à très court terme. Cependant, les gouvernements ont l’option (qu’ils prennent généralement) d’émettre des obligations de plus long terme. Cela peut ou non être immédiatement moins cher que de créer de la monnaie/des réserves, selon que les taux d’intérêt de long terme sont supérieurs ou inférieurs aux taux d’intérêt de court terme. Après la crise financière mondiale, les taux de court terme étaient inférieurs aux taux de long terme, donc le financement monétaire aurait été moins cher et l’assouplissement quantitatif était rentable. Actuellement, les taux d’intérêt de long terme sont inférieurs aux taux de court terme, donc le financement obligataire serait moins cher en cet instant. Cependant, à long terme, si l’option d’emprunter à long terme est moins cher pour les gouvernements reste une question ouverte. Ellison et Scott estiment que le Royaume-Uni, qui tend à emprunter à long terme, aurait mieux fait d’emprunter à court terme.

La situation serait claire si les banques centrales payaient seulement des intérêts sur les réserves à la marge, plutôt que de payer des intérêts sur toutes les réserves. Cela permettrait aux banques centrales de continuer de contrôler les taux d’intérêt de court terme, mais aussi de verser substantiellement moins d’intérêts sur le stock total de réserves. J’ai déjà discuté de cette possibilité en détails ici, dans le contexte de la réduction des pertes provoquées par l’assouplissement quantitatif. Une raison supplémentaire de payer des intérêts seulement à certaines réserves est qu’il n’y a pas de raison évidente à ce que les banques commerciales reçoivent de larges sommes de monnaie pour leurs réserves lorsque les taux d’intérêt sont élevés et quasiment rien lorsque les taux sont faibles.

Si les intérêts étaient seulement versés sur des réserves marginales, alors il deviendrait clairement attractif du point de vue des finances publiques de financer les déficits en créant de la monnaie/des réserves plutôt qu’en émettant de la dette. Alors pourquoi les gouvernements n’explorent-ils pas cette possibilité ? Je pourrais également demander pourquoi les économistes orthodoxes ne parlent pas plus de cette possibilité. Peut-être que je manque quelque chose d’évident ici. Si c’est le cas, faites-le moi savoir !

Un possible argument qui, selon moi, ne tient pas est qu’un financement moins coûteux des déficits encouragerait les gouvernements à être dépensiers. La principale dissuasion à la prodigalité budgétaire quand il y a une banque centrale indépendante, ce sont les taux d’intérêt élevés, pas des paiements d’intérêts sur la dette élevés.

J’aimerais finir en faisant deux points additionnels. Le premier porte sur les marchés financiers et le défaut de paiement. Le financement monétaire peut apparaître attractif à ceux qui croient que la finance par endettement contraint les décisions budgétaires du gouvernement. L’idée est que les marchés obligataires pourraient soudainement arrêter de prêter aux gouvernements et cela empêche les politiciens de faire des choix de politique budgétaire optimaux. Si les politiciens pensent ainsi ils se trompent, parce qu’il est improbable (comme je l’ai expliqué ailleurs) que le marché obligataire arrête de prêter au gouvernement et, si cela survenait, la banque centrale agirait en tant qu’acheteur en dernier ressort de la dette publique. C’est ce qui s’est passé pendant la pandémie et après le fameux événement budgétaire de Truss.

Parce que les gouvernements peuvent créer de la monnaie, ils n’ont pas à s’inquiéter à l’idée d’être forcés à faire défaut en conséquence de turbulences sur les marchés obligataires. En outre, le fait que les gouvernements aient un arbre de monnaie magique signifie que les obligataires peuvent toujours obtenir des intérêts et retrouver leur monnaie. Le seul défaut formel que doivent craindre les marchés obligataires est celui que les gouvernements choisissent, parce que le coût politique qu’il y a à assurer le service de la dette publique devient trop élevé. Nous sommes loin de tels niveaux aujourd’hui (...).

Mon second point concerne les actifs sûrs. Parce que les gouvernements des pays développés qui s’endettent dans leur propre monnaie choisissent rarement de faire défaut, la dette qu’ils émettent est bien plus sûre que toute dette que crée le secteur privé. Une telle dette est précieuse pour le secteur financier. Elle apporte aux fonds de pension une plus grande certitude qu’ils pourront verser des pensions à l’avenir, par exemple. Il y a une très bonne raison expliquant pourquoi les gouvernements doivent continuer d’émettre de la dette. Est-ce que cela signifie que les gouvernements doivent toujours financer leurs déficits en utilisant la dette ? Non, parce que les gouvernements peuvent émettre de la dette pour acheter des actifs (via un fonds souverain par exemple) plutôt que financer des déficits. »

Simon Wren-Lewis, « Could governments finance deficits by creating money? », in Mainly Macro (blog), 16 avril 2024. Traduit par Martin Anota

dimanche 14 avril 2024

Les liens de la semaine

Par Martin Anota le dimanche 14 avril 2024, 17:00

Environnement et ressources naturelles

- Les douze derniers mois ont été les plus chauds jamais enregistrés sur la planète (Le Monde)

- Condamnation de la Suisse par la CEDH : une avancée utile dans la lutte contre le réchauffement climatique (Le Monde)

- PFAS : premier succès contre les "polluants éternels" (Alter éco)

- La planification écologique, victime inévitable des arbitrages budgétaires ? (The Conversation)

- Innovation verte : un déclin qui interroge (The Conversation)

- Capitalisme et écologie sont-ils incompatibles ? (Le Monde)

- La conservation contre le capitalisme (La Vie des idées)

Militantisme écologique

- Le militantisme écologiste est-il aussi impopulaire qu'on le pense ? (The Conversation)

- Climat : les jeunes manifestants peuvent-ils encore peser sur les négociations pendant les COP ? (The Conversation)

IA

- Les gains de productivité promis par l'intelligence artificielle mis en doute (Les Echos)

- Quel sera l’impact de l’IA sur la croissance économique ? (D'un champ l'autre)

Croissance économique

- Les pays émergents pèsent plus lourd sur l’échiquier économique mondial (FMI)

- Relancer la productivité est une priorité mondiale pour réveiller la croissance à moyen terme (FMI)

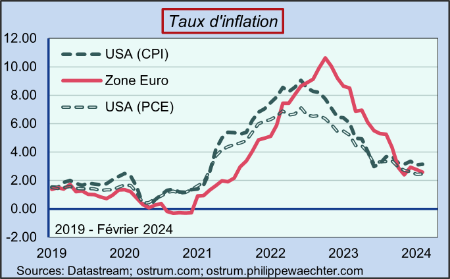

Inflation

- En mars 2024, les prix à la consommation augmentent de 0,2 % sur un mois et de 2,3 % sur un an (INSEE)

- L’argument selon lequel l’inflation va reculer dans la zone euro en raison de la faiblesse de la croissance (de la demande) est très douteux (Patrick Artus)

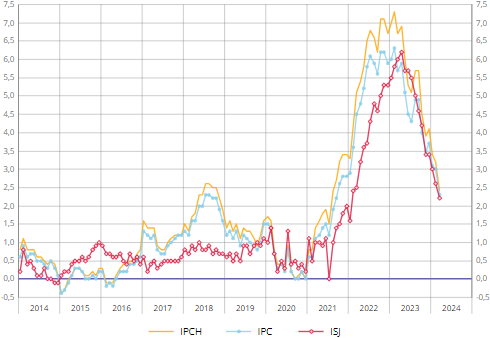

GRAPHIQUE Glissements annuels de l'indice des prix à la consommation (IPC), de l'inflation sous-jacente (ISJ) et de l'indice des prix à la consommation harmonisé (IPCH) en France (en %)

source : INSEE (2024)

Marchés et concurrence

- Prix planchers dans l’agriculture : producteurs et consommateurs pourraient bien y perdre (The Conversation)

- Comment les entreprises tirent profit du boom du marché de l’occasion (Alter éco)

Marché de l'immobilier

- Le logement est une des raisons pour lesquelles les effets des taux d’intérêt plus élevés diffèrent selon les pays (FMI)

- Comment la politique monétaire affecte les marchés de l’immobilier (D'un champ l'autre)

- Immobilier et endettement des ménages en France, Allemagne, Espagne et Italie : une situation singulière de la France (Banque de France)

Monnaie et finance

- La "bulle" sur les actions va pouvoir continuer à gonfler (Patrick Artus)

- L’essor rapide du marché du crédit privé, qui pèse 2 000 milliards de dollars, exige une plus étroite supervision (FMI)

- L’intensification des cybermenaces suscite de grandes inquiétudes pour la stabilité financière (FMI)

- Prêts garantis par l’État et prise de risque bancaire (Banque de France)

- Une monnaie commune au Sahel : derrière la logique politique, un risque économique (The Conversation)

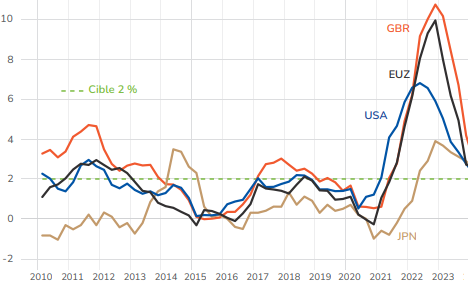

GRAPHIQUE Taux d'inflation dans la zone euro, aux Etats-Unis, en Grande-Bretagne et au Japon et cible des banques centrales (en %)

source : OFCE (2024)

Dette publique

- Le problème budgétaire de la zone euro et de la France a deux causes : les transferts aux ménages et le recul de la productivité (Patrick Artus)

- Pourquoi la dette publique ne va pas baisser (Charles Wyplosz)

- Trois bonnes nouvelles sur la dette publique française (Christian Chavagneux)

- Quelles différences entre la France et les États-Unis en ce qui concerne la possibilité d’avoir un déficit public très important ? (Patrick Artus)

Politique industrielle

- La politique industrielle n’est pas un remède miracle contre la faible croissance (FMI)

- Bien gérer le retour de la politique industrielle : la barre est haute (FMI)

Migration

- Le pacte migratoire européen, un compromis au goût amer (Le Monde)

- Comprendre les enjeux du "pacte migratoire" européen, qui doit être voté à Bruxelles (Le Monde)

Inégalités et stratification sociale

- Les territoires des émeutes. La ségrégation urbaine au cœur des violences (La Vie des idées)

- Enfance : comment les inégalités de langage se construisent (The Conversation)

- Le récit de transfuge de classe : un "script" médiatique ? (The Conversation)

- Les individus sont-ils moins heureux dans les sociétés inégalitaires ? (A la marge)

Ecole

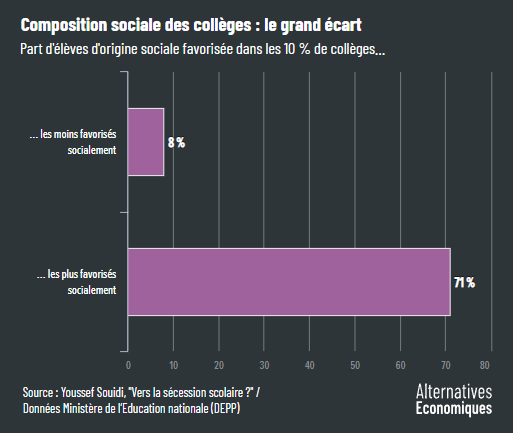

- Neuf graphiques pour saisir l’ampleur de la ségrégation scolaire en France (Alter éco)

- "Dès la maternelle, les élèves de milieux défavorisés prennent moins la parole". Entretien avec Sébastien Goudeau (Observatoire des inégalités)

- Violences à l’école : une longue histoire ? (The Conversation)

Fiscalité et redistribution

- Taxe lapin : Attal réhabilite le mythe du patient fraudeur pour faire oublier le recul de l’Etat (Alter éco)

- Santé : la France a-t-elle un système plus socialisé qu’ailleurs ? (Brigitte Dormont)

- Pour "désmicardiser" la France, faut-il augmenter la TVA sociale ? (Alter éco)

- "Moins d’impôts n’implique pas plus de bonheur, c’est même l’inverse" (Pierre Boyer)

Travail, emploi, chômage

- Effet de la réforme du RSA sur les chiffres du chômage ? (OFCE)

- Y a-t-il un rapport entre le niveau du chômage et les règles de l’indemnisation du chômage et les politiques actives du marché du travail ? (Patrick Artus)

- Accès à la formation : pourquoi souhaiter se former ne suffit pas (Céreq)

- L’index égalité professionnelle… mis à l’index (Alter éco)

- Homme sage-femme ou assistant social : des trajectoires à l’encontre des inégalités de genre ? (AOC)

- Les vertus écologiques de la baisse du temps de travail (Reporterrre)

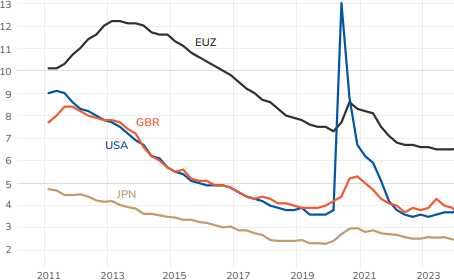

GRAPHIQUE Taux de chômage dans la zone euro, aux Etats-Unis, en Grande-Bretagne et au Japon (en %)

source : OFCE (2024)

Politique

- "Il faut en finir avec la démocratie participative, qui accentue la crise qu’elle prétend résoudre" (Manon Loisel)

- En Slovaquie, la victoire du candidat de la peur (Le Monde)

- Argentine : Javier Milei à l’épreuve du pouvoir (The Conversation)

Contrôle social

- Covid-19 : bilan d’une surveillance massive (CNRS)

- Paris 2024, terrain de jeu pour la surveillance algorithmique (Alter éco)

Violences sexistes

- L’auteur de cinéma : une construction masculine ? (La Vie des idées)

- Existe-t-il des profils types d’auteurs de violence conjugale ? (The Conversation)

voir la précédente revue de presse

voir le graphorama de la semaine

dimanche 7 avril 2024

Les liens de la semaine

Par Martin Anota le dimanche 7 avril 2024, 18:00

Environnement et ressources naturelles

- La Terre, un système en équilibre précaire (CNRS)

- Sobriété écologique : les Français adhèrent en principe, beaucoup moins en pratique (Alter éco)

- La loi agricole entre pragmatisme et recul écologique (Le Monde)

- La loi d’orientation agricole, un cheval de Troie pour défaire le droit de l’environnement (Alter éco)

- Des mines pour sauver la planète ? (La Vie des idées)

Croissance, fluctuations et crises

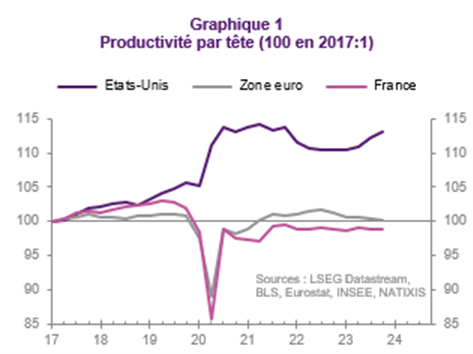

- La stagnation, puis le recul de la productivité du travail datent de la mi-2017 dans la zone euro : cela élimine beaucoup d’explications de cette stagnation (Patrick Artus)

- Les causes du recul de la productivité du travail dans la zone euro et en France (Patrick Artus)

- Pourquoi la zone euro décroche-t-elle à partir de 2017 par rapport aux États-Unis ? (Patrick Artus)

- L’ajustement de l’immobilier : beaucoup par les quantités et peu par les prix (Patrick Artus)

- Quels scénarios à l‘horizon 2030 ? (Philippe Waechter)

Numérique

- DMA : trois lettres qui changent beaucoup (Emmanuel Combe)

- Les enjeux économiques de l'intelligence artificielle (Trésor)

Monnaie finance

- La BCE doit-elle agir avant la Fed ? (Philippe Waechter)

- Structure d’endettement des entreprises et transmission de la politique monétaire (Banque de France)

Dette publique

- Avec sa dette, la France est-elle "sur le toboggan de l’enfer" ? (Isabelle This Saint-Jean)

- Peut-on à la fois réduire la dette, ne pas entraver la croissance et lutter contre les inégalités ? (The Conversation)

- Comment réduire la dette publique ? La méthode jamaïcaine (Esprits animaux)

Economie internationale

- "Il y a une fenêtre historique inédite pour sortir du franc CFA" (Alter éco)

- Mondialisation : comment la sécurité économique est devenue la priorité (Isabelle Bensidoun)

Migration

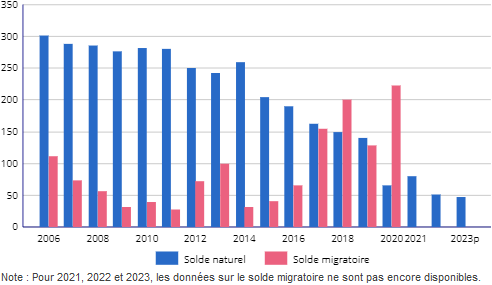

- Flux migratoires. Des entrées en hausse en 2022 dans un contexte de normalisation sanitaire et de guerre en Ukraine (INSEE)

- Population immigrée, entrées sur le territoire, titres de séjour… S’y retrouver dans les chiffres de l’immigration (INSEE)

GRAPHIQUE Soldes migratoire et naturel de la France (en milliers)

source : INSEE (2024)

Inégalités et justice sociale

- Allocations familiales: pour un forfait unique par enfant, et dès le premier (Julien Damon)

- Capitalisme et injustice (La Vie des idées)

- Centre, banlieue, périphérie : quelle répartition des populations ? (France Stratégie)

Ecole

- Mixité sociale : l’enseignement privé doit prendre sa part (Le Monde)

- Ecole privée : un rapport relance le débat politique, pas encore la "guerre scolaire" (Alter éco)

- Groupes de niveau : les profs en grève contre le tri scolaire (Alter éco)

- Le "choc des savoirs" et la mort du collège unique (François Dubet)

- Enseigner face aux enjeux de laïcité, discriminations et racisme (AOC)

Réformes de l'assurance-chômage

- Assurance-chômage : les grandes étapes d’un durcissement des règles depuis 2017 (Le Monde)

- Réforme de l'assurance-chômage : la réduction de la durée d'indemnisation favorise-t-elle un retour à l'emploi ? (France Info)

- Assurance chômage : une inépuisable source de taxation pour l’Etat (Bruno Coquet)

- La "classe moyenne" qui s’en prend aux "chômeurs" ne s’en prend qu’à elle-même (Mathieu Grégoire)

Politique

- Pourquoi le vote n’attire plus (Le Monde)

- Elections municipales en Turquie : le pire revers d’Erdogan (Le Monde)

- Les extrêmes prolifèrent sur les difficultés des partis issus d’une société industrielle qui disparaît (Michel Wieviorka)

Géopolitique

- Israël-Gaza : le triomphe de la haine (Le Monde)

- État islamique : une "dette de sang" par-delà l’espace et le temps (The Conversation)

- Pourquoi les débats sur le rôle de la France au Rwanda demeurent-ils aussi sensibles ? (The Conversation)

Contrôle social et déviance

- "Je ne contracte pas" : les êtres souverains, ces complotistes qui nient l’autorité des Etats (Le Monde)

- Le traitement judiciaire des violences sexuelles et conjugales en France (IPP)

- De la culture du viol (AOC)

- Légalisation, dépénalisation : comment les législations du cannabis s’assouplissent à travers le monde (Le Monde)

voir la précédente revue de presse

voir le graphorama de la semaine

« billets précédents - page 1 de 386