« Au milieu de la journée du vendredi 10 mars 2023, les régulateurs bancaires ont rapidement fermé la Silicon Valley Bank (SVB), évitant probablement par là une panique plus large. En comparaison avec les crises financières passées, celle-ci n’a pas été particulièrement significative sur le plan économique, mais elle constitue un exemple important et illustratif de l’économie bancaire.

Dans un article paru dans le Journal of Economic Perspectives, Andrew Metrick explique les causes derrière la faillite de la SVB et de la manière par laquelle le gouvernement a réagi à celle-ci. Selon lui, la compréhension de l'effondrement de la SVB est une première étape pour donner un sens à des crises financières plus compliquées telles que la crise financière mondiale.

Metrick s'est récemment entretenu avec Tyler Smith sur les raisons de la faillite de la Silicon Valley Bank et sur ce que les décideurs politiques peuvent faire pour prévenir les crises financières. (…)

Tyler Smith : Quel genre de banque était la SVB ? Etait-ce une banque qui faisait quelque chose de vraiment hors du commun ?

Andrew Metrick : Il ne s'agissait pas de choses qui sortaient de l'ordinaire, mais c'était certainement très loin sur la courbe des risques. La majeure partie de leur argent leur a été donnée par les déposants, qui sont en fait des prêts accordés par les déposants à la banque que les déposants peuvent reprendre à tout moment. Et avec cet argent, ils ont accordé des prêts aux entreprises. Ils ont également acheté des obligations et autres titres d’État (…) en attendant de faire un bon prêt. C’est une chose assez courante pour les banques. Ce qui rendait la Silicon Valley Bank quelque peu singulière, c'était justement le fait qu'une grande partie des dépôts était constituée de larges dépôts, en l’occurrence plus gros que ce que la Federal Deposit Insurance Corporation (FDIC) est prête à assurer. Il y a une limite de 250.000 dollars par dépôt. Ils avaient beaucoup de dépôts qui représentaient plus que cela.

Smith : Selon vous, quelles sont les principales raisons de la faillite de SVB d'un point de vue économique ?

Metrick : Lorsque vous êtes une banque, le principal service que vous fournissez est la commodité. Les gens vous passent de l’argent et le laissent dans votre banque comme dépôt. En général, les banques versent des intérêts sur ces dépôts qui sont très bas par rapport à ce que le gouvernement paie sur sa propre dette, qui est la dette la plus sûre au monde. Mais vous bénéficiez d’un taux d’intérêt encore plus bas lorsque vous prêtez quelque chose à une banque via un dépôt. Pourquoi ? Cela vous apporte de la commodité. Vous pouvez utiliser cette monnaie pour payer vos factures. Vous pouvez l'utiliser pour payer vos impôts. Et c’est le principal service que vend une banque : vous n’avez jamais à vous soucier de la sécurité de votre monnaie. Dès que vous craignez que votre monnaie ne soit pas en sécurité, la chose rationnelle à faire est de la retirer et de la placer dans une autre banque.

Si j'ai de la monnaie dans une banque et que cette monnaie n'est pas assurée parce qu'il y en a beaucoup, alors au premier signe suggérant que cette banque pourrait ne pas survivre je vais retirer ma monnaie et cela va être dangereux pour la banque… Comment une banque peut-elle empêcher cela ? La principale façon par laquelle une banque va essayer de me rassurer est de montrer combien d’argent elle possède. Elle va mettre en avant l’énorme écart entre ses actifs et ses passifs, son capital. Ce qui est arrivé à la Silicon Valley Bank, c’est que ses actifs, les choses qu’elle a achetées avec tous les dépôts que les gens lui ont faits, ont perdu beaucoup de valeur. Leur valeur a tellement chuté que les déposants n’étaient pas sûrs de pouvoir être remboursés. Une fois que c’est arrivé, ils se sont rués aux guichets. La cause immédiate est donc que les placements que la SVB a fait avec l’argent qu’elle a reçu ont perdu beaucoup de valeur. Ce qui est intéressant et clair à ce sujet, c'est que ces placements avaient été réalisés dans des choses très sûres, des titres d'État.

Smith : Pourquoi la valeur de son capital a-t-elle diminué ?

Metrick : La Silicon Valley Bank a environ triplé sa taille entre la veille de la pandémie et fin 2021. C’est une croissance très rapide pour une banque. Et, au début de la pandémie de Covid-19, nous étions inondés de liquidités provenant du gouvernement, en particulier dans la Silicon Valley et dans le secteur technologique. De nombreux clients de la Silicon Valley Bank ont déposé cet argent dans celle-ci. C'est en partie la raison pour laquelle sa croissance a été si rapide. Maintenant, que faites-vous lorsque vous êtes une banque et que, tout d’un coup, votre base de dépôts triple en peu de temps ? Habituellement, ce que vous voulez faire avec l’argent qui rentre, c’est le prêter pour de l’immobilier commercial, du crédit l’hypothécaire, ou autre. Mais bien sûr, pendant la pandémie, il n’y a pas eu beaucoup de ce genre de choses qui se faisaient. Alors, où mettre l’argent ? Ils ont décidé de placer cet argent dans des titres publics à moyen et long terme. Maintenant, vous pouvez vous demander pourquoi ils n’ont pas acheté la forme la plus sûre de la dette publique, c’est-à-dire à très court terme ? De leur point de vue, cela ne semblait pas important. Elle ne rapportait rien. Cela s'est avéré être une erreur. Lorsque les taux d’intérêt ont ensuite augmenté très rapidement en 2022 en raison des inquiétudes concernant l’inflation, la valeur de ces titres publics a diminué, même si vous savez que vous serez remboursé 100 cents par dollar à leur échéance. Il s’agit simplement d’une facette inévitable des mathématiques obligataires et de la manière par laquelle les obligations sont valorisées. Et, à cause de cela, la SVB, qui détenait une grande partie de son portefeuille sous la forme de ces obligations, a vu la valeur de ses actifs chuter. Et, en effet, leur valeur a tellement baissé qu’il n’y avait plus de réserve de capital.

Smith : Que s’est-il passé pendant cette très brève période pour que tout s’effondre ?

Metrick : Pourquoi mars 2023 ? Ils disposaient d’une bonne réserve de capital. Et cette réserve de capital avait été complètement anéantie fin septembre 2022. Le fait que leur réserve de capital avait été anéantie était connu. Mais il a fallu six mois avant que les gens ne se ruent. Pourquoi ne pas vous ruer dès que vous constatez que la valeur des actifs de la banque a chuté ? Du point de vue d’une personne qui croit en la Silicon Valley Bank, il est clair que la valeur des obligations a chuté parce que les taux d'intérêt ont beaucoup augmenté, mais ce que la banque doit en réalité verser à ses déposants n'est pas très élevé. Elle dirait également de regarder à quel point la SVB fait de bonnes choses du côté des bénéfices. Elle ne verse que quelques points de pourcentage sur ses dépôts et elle peut les réinvestir à hauteur de cinq. C'est beaucoup. En outre, les personnes optimistes à propos de la SVB pourraient dire aussi qu’elle entretient des relations très spéciales avec ses clients. Ses clients la suivent depuis longtemps et elle offre des services uniques dans la communauté de la Silicon Valley. Ainsi, comme elle verse à ses déposants bien moins que les taux d’intérêt du marché, elle va réaliser un flux de bénéfices pendant tout ce temps. Même si sur le papier on pourrait penser qu'elle n’est pas solvable, si vous prenez le fait qu'elle a cette activité incroyablement rentable, grâce à tous ces clients qui l’aiment, qui la laissent encore leur verser un montant très bas, elle apparaît très solvable.

Mais ce qui s’est passé alors, c’est que les gens avaient besoin de leur monnaie parce que les choses avaient changé. Les taux d’intérêt étaient élevés, l’ère de l’argent vraiment facile était finie et bon nombre des clients de la SVB qui avaient déposé de la monnaie sur ses comptes la retiraient uniquement pour des causes naturelles. Mais si la SVB voulait rendre la monnaie à ces personnes, elle devait vendre une partie des titres qu’elle détenait à son actif. Et lorsqu’elle vendait ces titres, elle devait reconnaître le fait qu’elle les vendait à un prix inférieur à celui pour lequel elle les avait achetés. Lorsqu’une telle nouvelle se fait connaître, il est normal pour les clients de devenir nerveux. Ils peuvent se demander si les dépôts de la banque sont aussi stables qu’ils le pensaient jusqu’alors. Et c'est tout ce dont vous avez besoin. La chose rationnelle à faire, si vous obtenez un service que vous pourriez obtenir ailleurs, est de prendre le temps et de faire les efforts nécessaires pour déplacer votre monnaie. Et une fois que cela commence, le raisonnement qui permet aux dépôts de rester sûrs devient de plus en plus fragile (…). C’est pourquoi tout signe de faiblesse dans une banque peut très vite devenir auto-réalisateur. Et c’est ce qui s’est justement produit lorsque les gens ont appris que la SVB avait des problèmes et qu’elle devait vendre des titres en mars 2023. (…) »

Andrew Metrick, « A textbook bank run », interviewé par Tyler Smith, American Economic Association, 12 mars 2024.

aller plus loin...

« Les répercussions réelles des ruées bancaires »

« Les exigences en capital rendent-elles plus sûr le secteur bancaire ? »

Monnaie et finance

mercredi 13 mars 2024

Une ruée bancaire classique : la faillite de la Silicon Valley Bank

Par Martin Anota le mercredi 13 mars 2024, 16:00

mardi 19 septembre 2023

Qu’est-ce que le taux d’intérêt neutre ?

Par Martin Anota le mardi 19 septembre 2023, 17:00

« Le taux d’intérêt neutre (également appelé le taux d’intérêt d’équilibre de long terme, le taux naturel et, pour les initiés, r-étoile ou r*) est le taux d’intérêt de court terme qui prévaudrait quand l’économie est au plein emploi et l’inflation stable, le taux auquel la politique monétaire est ni contractionnaire, ni expansionniste. Il est fonction des caractéristiques sous-jacentes de l’économie et il n’est pas fixé par la banque centrale. Il est habituellement évoqué en termes réels, c’est-à-dire avec l’inflation soustraite. Le taux neutre ne peut être observé directement ; il peut seulement être estimé.

Pourquoi le taux neutre importe-t-il ?

Il importe parce qu’il affecte comment la banque centrale juge si les taux d’intérêt qu’elle fixe stimulent ou dépriment l’économie. La Fed peut fixer temporairement le taux des fonds fédéraux cible, le taux auquel les banques empruntent au jour le jour, au-dessus du taux d’intérêt neutre pour refroidir l’économie ou sous le taux neutre pour la stimuler. Le taux neutre est essentiellement un guide pour la politique monétaire. (...)

Comment le niveau du taux neutre a-t-il évolué ?

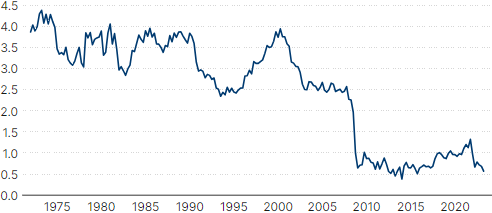

Les économistes utilisent différents modèles pour estimer le taux neutre. Les estimations largement citées des économistes de la Réserve fédérale Kathryn Holston, Thomas Laubach et John Williams suggèrent que le taux neutre réel (ou ajusté en fonction de l’inflation) à environ 0,6 % aux Etats-Unis au deuxième trimestre 2023. Cette mesure a décliné au cours du temps. Le graphique ci-dessous montre leurs estimations du taux neutre à long terme pour les Etats-Unis depuis les années 1970. Depuis 1972, le taux neutre a baissé d’environ 3,4 points de pourcentage selon les estimations.

GRAPHIQUE Estimation du taux d'intérêt neutre des Etats-Unis (en %)

source : Holston et alii (2023)

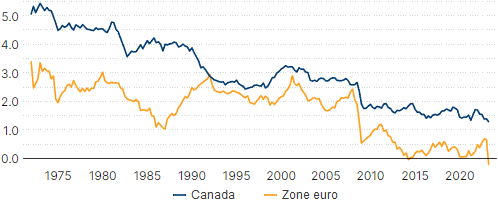

La tendance est similaire pour d’autres économies avancées, ce qui suggère que la baisse du taux neutre n’est pas seulement due à des facteurs spécifiques aux Etats-Unis. Pour le Canada, Holston et alii estiment que le taux d’intérêt neutre a baissé d’environ 3,8 points de pourcentage depuis 1972. Les estimations en Europe sont même plus austères : le taux neutre au deuxième trimestre 2023 serait négatif, après avoir chuté d’environ 3,6 points de pourcentage au cours de la même période.

GRAPHIQUE Estimation du taux d'intérêt neutre du Canada et de la zone euro (en %)

source : Holston et alii (2023)

La projection médiane des membres du comité d’open market fédéral (les gouverneurs de la Fed à Washington et les présidents des banques fédérales régionales) indique un taux d’intérêt réel neutre de long terme à 0,5 % au deuxième trimestre 2023. La projection médiane du taux des fonds fédéraux à long terme (essentiellement une estimation du taux neutre) a baissé au cours du temps. Elle est à présent 1,5 point de pourcentage plus bas qu’elle ne l’était une décennie plus tôt, en 2013.

Quels sont les déterminants du taux neutre à long terme ?

A long terme, le taux d’intérêt neutre est déterminé par l’offre et la demande d’épargne. Par exemple, pour que les entreprises puissent faire de nouveaux investissements, elles ont besoin que les ménages et d’autres épargnants offrent du capital pour financer ce investissement. Par conséquent, l’investissement total dans l’économie doit être égal au stock disponible de capital et d’épargne. Pour que ce soit le cas, les taux d’intérêt doivent être suffisamment élevés pour convaincre les épargnants d’épargner et suffisamment faibles pour inciter les emprunteurs à emprunter. Le taux d’intérêt que l’on obtient ainsi à long terme est le taux d’intérêt neutre. Au cours du temps, il y a divers facteurs qui peuvent affecter l’offre et la demande d’épargne.

La croissance de la productivité. Si les entreprises sont plus productives, elles sont capables de produire plus à partir d’un ensemble fini de ressources. Une plus forte croissance de la productivité est généralement associée à de nouvelles opportunités d’investissement qui augmentent la demande de capital, poussant les taux d’intérêt vers le haut. Dans les années récentes, la croissance de la productivité a au contraire été assez faible, poussant le taux d’intérêt neutre vers le bas.

La stagnation séculaire. L’hypothèse de la stagnation séculaire, avancée par l’ancien secrétaire du Trésor américain Larry Summers, se focalise sur des facteurs relatifs à la demande agrégée. Summers croit que l’épargne a augmenté, tandis que l’investissement désiré a chuté, en raison de changements des fondamentaux économiques, en particulier le fait que les entreprises modernes requièrent moins de capital pour fonctionner. En conséquence, il voit la faiblesse des taux d’intérêt réels comme un phénomène chronique. Il interprète les récentes tendances du taux d’intérêt comme une preuve que l’économie mondiale connaît une chute chronique de la demande agrégée pour les nouveaux investissements et que, à l’exception de significatives relances budgétaires, les taux d’intérêt vont rester faibles pour un certain temps.

La surabondance d’épargne mondiale. Comme le monde devient plus connecté, le stock d’épargne disponible devient mondial, ce qui augmente la sensibilité des taux d’intérêt aux flux de capitaux dans les pays étrangers. L’ancien président de la Fed Ben Bernanke affirmait qu’en conséquence de ces forces un "excès mondial d’épargne" (global savings glut) a poussé le taux d’intérêt neutre à la baisse. Selon cette théorie, les politiques orientées à l’exportation des pays émergents comme la Chine ont inondé les marchés de capitaux avec une offre d’épargne mondiale accrue au début des années 2000. En particulier après une vague de crises de change dans les pays émergents au cours des années 1990, les banques centrales autour du monde ont accumulé de larges réserves de change pour mieux gérer les flux de capitaux. Cette accumulation de réserves étrangères, essentiellement investies dans des bons du Trésor américains, a fortement accru l’offre d’épargne et poussé le taux neutre vers le bas. Certains travaux ont donné de la crédibilité à cette hypothèse, en particulier à la veille de la Grande Récession.

Si ces tendances relatives à l’épargne ou à l’investissement s’inversaient, le taux d’intérêt neutre pourrait augmenter. En avril 2015, par exemple, Bernanke prédisait que les taux d’intérêt tendraient à augmenter si les tendances dans les flux de capitaux mondiaux s’inversaient. De récents travaux suggèrent que l’excès d’épargne mondial peut se réduire. Cela diffère de la théorie de la stagnation séculaire, qui implique une situation plus permanente.

Les actifs sûrs et l’aversion au risque. D’autres explications pour la baisse du taux d’intérêt neutre se focalisent sur la demande d’actifs sûrs. Si les individus deviennent plus averses au risque, ils peuvent épargner pour se protéger contre un éventuel ralentissement futur de l’économie. Cela peut accroître la demande de bons du Trésor américains ultra-sûrs, qui sont très faciles à acheter et à vendre et qui ont une très faible chance de défaut (…). Certains économistes affirment que les investisseurs sont devenus plus averses au risque après la crise financière mondiale de 2008 et ont davantage préféré placer leur argent dans des actifs sûrs que dans des projets d’investissement plus risqués (mais potentiellement plus productifs). Certaines études suggèrent que la hausse des primes de risque et une plus grande demande d’actifs sûrs est la première force qui a tiré à la baisse le taux d’intérêt neutre au cours des récentes années.

La démographie. Pour beaucoup, on épargne avant tout pour préparer la retraite. Ainsi, plus les gens s’attendent à vivre longtemps, plus ils épargnent. Par conséquent, l’allongement de l’espérance de vie dans les pays développés a augmenté l’offre d’épargne et tiré vers le bas le taux d’intérêt neutre. Bien sûr, une fois que les gens sont à la retraite, ils utilisent leur épargne. Mais en même temps, une baisse des taux de fertilité signifie que la main-d’œuvre croît plus lentement, donc qu’il y a moins de travailleurs à offrir avec du capital et, donc, moins de demande pour de nouveaux investissements. Cela pousse vers le bas le taux d’intérêt neutre. Les chercheurs aux Etats-Unis, en Europe et au Japon ont montré que les tendances démographiques ont eu un large effet baissier sur les taux d’intérêt dans les pays développés. (...)

Quels sont les dangers d'un faible taux neutre ?

Un faible taux d’intérêt neutre laisse la politique monétaire avec moins de marge de manœuvre pour réduire les taux d’intérêt lors d’une récession. Comme Larry Summers l’avait noté à la conférence du Hutchins Center en 2017, la réponse de la Fed aux récessions passées a été de réduire les taux d’intérêt nominaux de 5,3 points de pourcentage en moyenne. Si l’inflation est de 2 % et le taux réel neutre de 1 %, le niveau normal des taux d’intérêt nominaux serait autour de 3 %. Dans ce cas, la Fed ne serait pas capable de réduire ses taux de 5 points de pourcentage lors d’une récession. Une étude réalisée par des économistes de la Fed montre qu’avec un très faible taux d’intérêt neutre, la Fed pourrait avoir à ramener ses taux d’intérêt à zéro plus de 40 % du temps. Il y a diverses propositions pour gérer le problème de la borne inférieure zéro sur les taux d’intérêt. Elles incluent l’usage des outils monétaires non conventionnels comme l’assouplissement quantitatif et le forward guidance. D’autres se focalisent sur un changement dans le cadre de politique monétaire de la Fed. En tout cas, aussi longtemps que le taux neutre reste faible, la Fed devra être imaginative en conduisant la politique monétaire quand la prochaine récession arrivera. »

Sam Boocker, Michael Ng & David Wessel, « What is the neutral rate of interest? », Brookings, 18 septembre 2023. Traduit par Martin Anota

aller plus loin...

« Cet obscur taux d’intérêt naturel »

« Larry Summers et la stagnation séculaire »

« Bernanke, Summers et la stagnation séculaire »

« Les taux neutres, la stagnation séculaire et le rôle de la politique budgétaire »

mardi 15 août 2023

La fin des taux d’intérêt nuls

Par Martin Anota le mardi 15 août 2023, 17:00

« Comme les choses ont changé en deux ans ! En 2021, les taux d’intérêt étaient proches de zéro aux Etats-Unis et au Royaume-Uni et légèrement négatifs dans la zone euro et au Japon. On s’attendait à ce qu’ils restent indéfiniment faibles. Chose remarquable, en janvier 2022, les investisseurs financiers pensaient que la probabilité que le taux d’intérêt remonte à 4 % dans les cinq années suivantes était de seulement 12 % aux Etats-Unis, 4 % en zone euro et 7 % au Royaume-Uni. Voilà en ce qui concerne les taux d’intérêt nominaux de court terme. Après correction de l’inflation anticipée, les taux d’intérêt réels étaient substantiellement négatifs et on s’attendait à ce qu’ils le restent.

Même après que la plupart des banques centrales aient commencé à relever leurs taux d’intérêt (la Fed commença à le faire en mars 2022), ce fut en réaction à la plus forte inflation. Donc, les taux d’intérêt réels étaient toujours substantiellement négatifs il y a un an encore. En outre, les taux d’intérêt de court terme ont davantage augmenté que les taux de long terme ne l’ont fait : la courbe des taux s’est inversée en octobre 2022, signalant que les marchés financiers pensaient que les banques centrales baisseraient bientôt les taux d’intérêt de court terme. Cette anticipation a été attribuée aux prévisions d’une récession imminente pour les Etats-Unis et l’économie mondiale, récession que l’on attendait déjà pour l’année 2022.

Le renversement

Pas même cinq ans se sont écoulés depuis janvier 2022 et pourtant le taux d’intérêt de court terme a augmenté à 5,25 % aux Etats-Unis. Les taux d’intérêt réels sont maintenant positifs aux Etats-Unis et dans plusieurs autres pays. A présent, les prévisions des futurs taux d’intérêt réels sont aussi bien au-dessus de zéro. (Une raison pour ce changement de perspective est que, soudainement, il apparaît que les Etats-Unis pourraient après tout éviter une récession.)

S’il n’y avait que les investisseurs financiers qui avaient brutalement abandonné le scénario des taux nuls pour celui des taux positifs, cela ne serait guère troublant : les marchés financiers sont notoirement volatils. Mais un renversement de paradigme plus fondamental pourrait également survenir parmi les économistes universitaires, ce qui survient moins souvent.

Le taux d’intérêt d’équilibre nul

En 2021, plusieurs économistes monétaires estimaient que le taux d’intérêt réel d’équilibre (ou neutre ou "naturel") devait chuter à zéro ou même en-dessous. Le taux d’intérêt neutre a été défini comme le taux d’intérêt que paieraient les obligations sûres si la demande agrégée était égale à la production potentielle et le chômage égal à son taux naturel. (Les banques centrales essayent généralement de maintenir le taux d’intérêt courant à proximité du taux d’intérêt naturel.) Cette perspective a été perçue comme plus ou moins permanente, avec l’exception des fluctuations cycliques occasionnelles, par exemple les hausses temporaires du taux d’intérêt à des instants où la politique budgétaire était inhabituellement expansionniste ou les creux dans les récessions.

Cette perspective de taux nul était importante. Avec une cible de long terme de 2 % pour le taux d’inflation moyen, l’implication semblait être que le taux d’intérêt nominal d’équilibre devait être inférieur à 2 % en moyenne, ce qui ne laisserait pas une marge suffisante pour réduire les taux d’intérêt en temps de récession. Malheureusement, les taux d’intérêt nominaux ne peuvent être poussés bien en-dessous de zéro, en raison de la fameuse borne inférieure zéro (zero lower bound), un exemple de ce que Keynes appelait une trappe à liquidité.

En Europe et au Japon, il est apparu que les taux d’intérêt nominaux pouvaient être poussés un peu en-dessous de zéro : jusqu’à – 0,5 %. Mais ce fut la borne inférieure effective (effective lower bound) : ils ne pouvaient pas être poussés davantage vers le bas. La raison est que, hypothétiquement, si les taux d’intérêt nominaux tombaient à - 1 %, les gens retireraient leur argent de la banque et la garderaient dans des coffres sûrs pour éviter les taux de rendement négatifs. Les coûts mensuels du coffre seraient moindres que la pénalité associée à la détention d’argent sous forme de dépôts bancaires ou d’obligations.

Si le taux d’intérêt réel d’équilibre était parfois négatif et la borne inférieure effective sur les taux d’intérêt nominaux proche de zéro, nous serions en difficulté. Dans cette situation inquiétante, la politique monétaire serait, l’essentiel du temps, trop restrictive pour délivrer le taux de croissance d’équilibre de l’économie réelle. (D’où l’intérêt pour les "politiques monétaires non conventionnelles".) Au mieux, la tâche du maintien au plein emploi aurait à revenir à la politique budgétaire, ce qui était politiquement difficile. C’était l’hypothèse de la stagnation séculaire, ravivée et rendue célèbre par Larry Summers il y a dix ans, en 2013, et soutenue par d’autres.

Les implications pour la dette publique

En ce qui concerne la politique budgétaire, il y avait une implication plus encourageante aux taux d’intérêt chroniquement faibles : ils ont chuté sous le taux de croissance de l’économie (r < g). Cela rendrait soutenables des niveaux élevés de dette publique. Le gouvernement pourrait connaître un déficit primaire (c’est-à-dire un déficit, même une fois les intérêts payés) sans pour autant que la dette soit insoutenable, parce qu’elle serait sur une trajectoire décroissante relativement au PIB. En effet, les taux d’intérêt réels négatifs ont contribué à réduire le ratio dette publique sur PIB des Etats-Unis entre 2020 et 2022.

Il a été suggéré que le meilleur indicateur de la soutenabilité de la dette n’est pas le ratio dette sur PIB, mais la charge d’intérêt sur PIB, c’est-à-dire le ratio dette sur PIB fois le taux d’intérêt. Parce que les taux d’intérêt étaient si faibles, les gouvernements pouvaient continuer à emprunter. On peut considérer que cette vision des choses a sous-estimé la probabilité d’une hausse brutale des taux d’intérêt à l’avenir, une évolution qui rendrait soudainement la dette insoutenable, comme beaucoup de pays émergents le savent.

A présent que les taux d’intérêt sont passés au-dessus du taux de croissance économique, la dette publique américaine est soudainement redevenue un problème. On s’attend à ce que le ratio dette sur PIB retrouve sa trajectoire ascendante (…). C’est l’une des raisons pour lesquelles Fitch Ratings a dégradé la notation de la dette américaine le 1er août, mettant un terme au triple A.

La tendance historique à la baisse des taux d’intérêt

Il n’est pas difficile de voir pourquoi les investisseurs financiers et les économistes concluaient en 2021 que les taux d’intérêt d’équilibre avaient chuté à plus ou moins zéro de façon permanente. Les taux de court terme aux Etats-Unis ont été proches de zéro pendant neuf années (2006-2015 et 2020-2021) au cours des treize années qui ont suivi la crise financière de 2008. De même, pour la zone euro (sous les 1 % depuis 2009 et zéro depuis 2015) et le Japon (sous 0,5 % depuis 1996). Cela ne s’était pas produit auparavant, du moins pas depuis la Grande Dépression des années 1930, l’époque où Alvin Hansen conçut le concept de stagnation séculaire.

Dans les économies majeures, les taux nominaux et réels ont eu tendance à baisser depuis 1992 (et même depuis les années 1980, mais cette décennie peut être expliquée par des facteurs macroéconomiques temporaires). Chose plus surprenante, quand Rogoff, Rossi et Schmelzing ont observé sept siècles de données sur les taux d’intérêt réels de long terme, ils ont trouvé une légère tendance baissière depuis la Renaissance, estimée à environ 1,2 point de pourcentage par siècle (entre 0,6 et 1,8 point de pourcentage), malgré beaucoup de fluctuations de court terme qui peuvent masquer la tendance. L’implication semble être que les taux d’intérêt réels de long terme au vingt-et-unième siècle entrent de façon permanente en territoire négatif. (Une interprétation alternative est que les taux suivent une asymptote tendant à zéro.)

Le déclin des taux d’intérêt réels a été si largement considérée comme permanente que ces études voient leur observation d’une tendance baissière sur sept siècles comme un rejet de la proposition que le déclin est seulement un phénomène propre aux quatre dernières décennies plutôt que comme un rejet de la proposition que le déclin fut seulement temporaire. Mais la dernière hypothèse doit être considérée sérieusement. Statistiquement, l’économétricien doit s’attendre à avoir besoin de cent années de données pour trouver des éléments significatifs montrant que les fluctuations de telles variables sont en fait des écarts transitoires par rapport à un équilibre de long terme.

Qu’est-ce qui pourrait être la cause fondamentale derrière la baisse des taux d’intérêt réels ? Une variété de raisons possibles a été évoquée. Les suggestions pour expliquer les dernières décennies incluent : le ralentissement de la croissance de la productivité (attribuable à un ralentissement du progrès technologique), divers facteurs démographiques (notamment le baby boom d’après-guerre), la hausse de la demande mondiale d’actifs sûrs et liquides (possiblement liée à la hausse des perceptions du risque), la hausse des inégalités (les riches épargnant davantage), un excès mondial d’épargne (attribuable à l’Asie de l’Est à forte épargne), la baisse du prix des biens capitaux, etc. (…) (Je pourrais aussi ajouter la baisse des coûts de transaction sur les marchés financiers, permettant une plus forte concurrence parmi les prêteurs.)

5 % versus zéro

Ce n’est pas que d’éminents économistes ont exclu la possibilité de futures hausses des taux d’intérêt. Ils ont reconnu qu’il y avait une chance que les taux d’intérêt puissent augmenter pendant un certain temps. Mais beaucoup pensaient que ce serait improbable à moyen terme et que ce serait transitoire à long terme. En 2018, Summers écrivait que "nous allons probablement avoir, selon les normes historiques, de très faibles taux pour une très large fraction du temps futur, même durant les bons temps". En 2020, Jason Furman et Summers avaient réitéré : "on s’attend à ce que les taux d’intérêt restent négatifs". En juin 2022, Olivier Blanchard écrivait dans un livre très impressionnant : "le long déclin des taux d’intérêt sûrs découle de puissants facteurs sous-jacents qui ne semblent guère susceptibles de s’inverser de sitôt".

Ce que l’on disait improbable s’est produit. Le taux d’intérêt de court terme est supérieur à 5 %. Peut-être que tous ces économistes monétaires ont raison et que le taux d’intérêt reviendra à zéro dans le futur. Mais il me semble que certains ont été trop hâtifs en extrapolant ce qui s’est passé entre 2008 et 2021. Après tout, jusqu’à 2008 presque personne ne pensait que les taux d’intérêt d’équilibre puissent être nuls. Les macroéconomistes n’ont pratiquement pas réfléchi aux taux d’intérêt nuls avant 2008 (ou 1998 dans le cas du Japon) et ils ne pensaient guère à autre chose après. Si nous avons changé d’avis une fois, nous pouvons encore changé d’avis. En outre, il n’est pas facile d’expliquer en théorie les taux d’intérêt réels d’équilibre nuls ou négatifs, aussi longtemps que les entreprises montrent une croissance de la productivité et les consommateurs une certaine impatience.

Je ne sais pas ce que seront les taux d’intérêt à l’avenir. Mais je doute qu’ils reviennent à zéro. S’ils n’y revenaient pas, ce serait une bonne nouvelle pour la politique monétaire : elle serait moins contrainte que précédemment. Mais ce serait une mauvaise nouvelle pour la politique budgétaire : elle serait de nouveau contrainte par la perspective d’une hausse continue des ratios dette publique sur PIB. »

Jeffrey Frankel, « The end of zero interest rates », in Econbrowser (blog), août 2023. Traduit par Martin Anota

aller plus loin...

« Pourquoi les taux d'intérêt réels sont-ils si faibles ? »

« Larry Summers et la stagnation séculaire »

« Une stagnation supra-séculaire ? »

« Faut-il s'inquiéter de la dette publique lorsque les taux d’intérêt sont faibles ? »

« r < g : peut-on vraiment ne pas se soucier de la dette publique ? »

mardi 20 décembre 2022

Les banques, le crédit et les fluctuations économiques

Par Martin Anota le mardi 20 décembre 2022, 11:00

« (…) L’activité bancaire et les marchés du crédit peuvent connaître des tensions. J’expliquerai très précisément ce que j’entends par "tensions". Celles-ci entraînent une hausse du coût d’emprunt et une réduction de la disponibilité du crédit. La chose importante est que les tensions sur le marché du crédit peuvent avoir des répercussions macroéconomiques très conséquentes. Je proposerai deux études de cas. La première porte sur la Grande Dépression des années 1930 et la seconde sur la crise financière mondiale de 2007-2009. Si j’ai le temps, je parlerai un peu de la façon par laquelle ces idées sont entrées dans la macroéconomie standard relative aux cycles d’affaires ordinaires et à la politique monétaire ordinaire. Elles ont influencé l’analyse standard des situations en dehors des crises, ainsi que des épisodes comme la crise financière mondiale.

Afin d’éclaircir ce que j’entends par "marchés du crédit sous tensions", évoquons l’économie du prêt. Les marchés du crédit sont très différents des autres marchés, par exemple du marché des pommes, parce qu’ils impliquent une information imparfaite et des asymétries d’information, ce qui signifie que l’une des partis à la transaction en sait plus que l’autre à propos du produit qui est échangé. Dans ce cas, les emprunteurs tendent à en savoir plus que les prêteurs à propos de leurs propres capacités financières, de leurs projets, de leurs risques, de ce qu’ils vont faire avec le crédit. (…) Des personnes qui se savent très risquées vont venir emprunter : c’est ce qu’on appelle la "sélection adverse". Des personnes peuvent emprunter et utiliser ce crédit pour faire autre chose que ce qu’elles sont censées faire avec : c’est ce qu’on appelle le "risque moral" ou l’"aléa moral". Vous avez donc besoin des banques (…), parce que les banques surmontent ces problèmes d’information en filtrant les emprunteurs. Elles leur font remplir de nombreux formulaires, elles les surveillent, elles leur imposent des restrictions sur ce qu’ils peuvent faire avec l’argent et elles leur demandent des garanties. Donc, le propre des banques est de surmonter les problèmes d’information qui imprègnent les marchés du crédit.

Ce n’est pas sans coût. Le coût de l’attribution d’un prêt inclut tous les coûts que la banque doit supporter pour filtrer, surveiller les emprunteurs potentiels. Un concept que je vais utiliser tout au long de mon exposé est la "prime de financement externe" (external finance premium). C’est fondamentalement le coût qu’il y a à accorder un crédit en plus du taux d’intérêt sans risque. Considérez-la comme ce que doit obtenir la banque pour faire des prêts plutôt que pour détenir des titres sûrs. (...)

Il est important d’avoir conscience que (…) les banques elles-mêmes empruntent. Elles doivent avoir les fonds qui leur sont nécessaires pour prêter aux emprunteurs ultimes. (…) Elles tendent à emprunter à court terme, des dépôts ou d’autres types de monnaie à court terme, ce qui a de la valeur pour les clients parce que cette monnaie peut être facilement convertie en liquidités quand c’est nécessaire et elle fournit un moyen de transactions de façon à acheter et à vendre. Donc, les banques tendent à dépendre étroitement de financements à court terme, ce qui les rend vulnérables aux ruées bancaires.

Les paniques bancaires sont un vrai danger. Quand des paniques ou des ruées bancaires sont en cours, les banques deviennent très prudentes. Elles arrêtent de prêter aux emprunteurs risqués parce qu’elles veulent maintenir la confiance. C’est ce qu’on appelle la "fuite vers la qualité" (flight to quality) : elles achètent des titres très sûrs comme les bons du Trésor. Le problème est que, si les banques cessent d’accorder des prêts au secteur privé, toutes les compétences qu’elles développent, toute l’information qu’elles ont accumulée, toutes les relations qu’elles ont établies, etc., (…) tout cela est gâché parce qu’elles ne prêtent pas au secteur privé. (...)

Ainsi, la prime de financement externe dépend de la valeur nette des emprunteurs et des prêteurs. Et elle est liée à l’état de l’économie. D’un côté, si la prime de financement externe est très élevée, c’est-à-dire s’il est très coûteux d’accorder des prêts au secteur privé, ce que j’entends par marchés du crédit sous turbulences, (…) le prêt devient rare, le crédit est moins disponible et cela va évidemment ralentir l’économie. D’un autre côté, si l’économie est faible pour une quelconque raison, par exemple en raison d’un choc pétrolier ou de tout autre événement qui affecte la valeur nette, la santé financière des prêteurs et emprunteurs, il devient plus compliqué de faire des prêts. (…) La prime de financement externe est affectée par l’économie ; l’économie affecte la prime de financement externe.

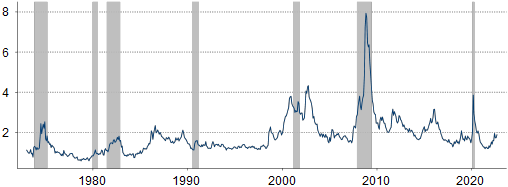

GRAPHIQUE Une mesure de la prime de financement externe

Il y a eu une tentative pour mesurer la prime de financement externe. On la trouve dans un article de Simon Gilchrist et Egon Zakrajšek. Ils ont observé l’écart entre le rendement sur les obligations d’entreprise et celui des titres du Trésor de la même maturité. Cette série remonte jusqu’aux années 1970. C’est un indicateur indirect de la prime de financement externe. Quand cette valeur est élevée, cela indique que les marchés du crédit connaissent d’importantes tensions. Les barres grises se réfèrent aux périodes de récession. Vous remarquez deux choses. D’une part, la prime de financement externe tend à augmenter durant les récessions. D’autre part, elle est devenue plus volatile au fil du temps, en partie parce que les emprunteurs sont devenus plus dispersés. (...)

Faisons une petite étude de cas, celle de la Grande Dépression. Au cours des 25 dernières années, de nombreux travaux ont suggéré que la Grande Dépression des années 1930, un événement majeur, a été provoquée en grande partie par un Etalon-or dysfonctionnel. Avant la Première Guerre mondiale, la plupart des pays ancrèrent leur devise à l’or, ce qui maintint les taux de change fixes et promut le commerce international, etc. L’étalon-or a été suspendu durant la guerre. Après la guerre, on essaya de le reconstruire. Mais (…) le nouvel étalon-or présenta des défauts structurels et, en outre, il y eut beaucoup d’hostilité entre la France et l’Allemagne après la guerre, si bien que ces pays ne coopérèrent pas pour faire fonctionner l’étalon-or. En conséquence, l’étalon-or s’effondra à la fin des années 1920 et au début des années 1930. Cet effondrement entraîna une contraction des offres de monnaie à travers le monde et poussa par ce biais les prix à la baisse (…).

Dans les années 1930, il y a eu de la déflation, les prix chutèrent, et certains travaux empiriques suggèrent que l’étalon-or a joué un rôle important. J’ai moi-même travaillé sur cette question. J’ai pendant longtemps été très intéressé par la Grande Dépression. Les éléments empiriques suggèrent que les pays qui ont quitté relativement tôt l’étalon-or, pour une raison ou une autre, comme la Grande-Bretagne, le Japon et les pays scandinaves, ont connu une reprise plus rapide suite à la dépression que ceux qui restèrent plus longuement dans l’étalon-or, comme la France et la Suisse. Cette idée est devenue centrale dans l’explication de la Grande Dépression, mais il y a toujours des problèmes et des questions qui demandent une réponse.

Quel a été le mécanisme à l’œuvre ? Pourquoi la déflation a-t-elle entraîné de fortes baisses de la production ? Pourquoi la reprise a-t-elle été si lente aux Etats-Unis et dans d’autres pays ? Selon moi, les turbulences sur le marché du crédit, conjuguées à l’Etalon-or, ont été une cause très importante de la dépression. Il y a eu de fortes turbulences sur le marché du crédit dans les années 1930. Aux Etats-Unis, il y avait à l’époque 25.000 banques. Beaucoup d'entre elles étaient de très petite taille, quelques unes étaient de très grande taille. Environ 40 % des banques disparurent entre 1929 et 1933. Pourquoi ont-elles disparu ? Elles firent faillite ou furent absorbées par d’autres banques. Cela a eu lieu parce qu’il y a eu des vagues massives de ruées bancaires. Les gens perdirent confiance envers les banques et en retirèrent leur monnaie. Les banques qui fermèrent ne purent bien sûr pas accorder de prêts et celles qui survécurent devinrent extrêmement réticentes à en accorder. Du côté des débiteurs, il y a eu une vague d’insolvabilité et de défauts de paiement.

(…) Une enquête menée en 1933, observant 22 villes, a montré que les taux de défaut de paiement des propriétaires sur les prêts hypothécaires allaient de 21 % à 62 % (…). Environ la moitié de toute la dette hypothécaire des fermiers était délinquante en 1933. C’est bien pire que ce que nous avons vu durant la crise financière mondiale. Les emprunteurs privés étaient alors en très grande difficulté et ne pouvaient continuer de rembourser leur prêt. Et les enquêtes menées auprès des banques montrent qu’elles essayaient, non pas d’accorder de nouveaux prêts, mais de liquider les prêts existants et qu'elles refusaient tout nouveau prêt, sauf pour les emprunteurs les plus sûrs, qui n’étaient guère nombreux. Donc, entre ce qui est arrivé aux banques, les ruées bancaires et ce qui est arrivé aux emprunteurs, le marché du crédit a été en définitive paralysé.

A présent, cela contribue à expliquer plusieurs faits intéressants concernant la Grande Dépression. (…) Tout d’abord, aux Etats-Unis, les prix ont baissé de 20 % entre 1931 et 1933. Pourquoi cela a-t-il été si dommageable ? L’une des raisons a été l’effet sur les emprunteurs. Imaginez un fermier. Il doit rembourser chaque mois un certain montant pour son crédit immobilier. Or, le prix des choses qu’il récolte baisse de 30 %, de 40%, de 50 %, de 60 %, comment va-t-il continuer de rembourser ? Il risque de ne pas y parvenir. Donc, la chute des prix affecte l’économie en détériorant la situation de nombreux emprunteurs.

Une forte reprise s’amorça en 1933, quand Franklin Roosevelt devint Président. Selon moi, Roosevelt fit deux choses qui améliorèrent l’économie. (…) Il rompit la relation liant le dollar à l’or, sortit les Etats-Unis de l’étalon-or. Voilà ce qui fut important. Mais l’autre chose qu’il fit a été de stabiliser le système bancaire. Rapidement après son arrivée à la présidence, il appela à une fermeture des banques, toutes les banques eurent à fermer. Il promit à la population américaine qu’elles ne rouvriraient pas tant que le gouvernement ne les avait pas inspectées et il se fit confiant à l’idée qu’elles soient viables. Et ensuite le Congrès adopta l’assurance-dépôt, qui garantissait que les petits déposants seraient remboursés si leur banque faisait faillite. Cela stabilisa immédiatement le système bancaire et, comme ce dernier redevint fonctionnel, la reprise s’accéléra.

Pour autant, même après la sortie de l’étalon-or, la reprise fut très lente. (…) En 1941, le taux de chômage était toujours de 15 % aux Etats-Unis, c’est-à-dire à un niveau très élevé. Donc, ce fut une reprise très lente, mais pourquoi ? J’affirmerai que, d’une part, les banques, certes moins en difficulté, restaient très frileuses et les emprunteurs en difficulté. Il leur fallut beaucoup de temps pour sortir de leurs problèmes de dette. Pour cette raison, le crédit resta contraint et cela empêcha l’économie de connaître une reprise plus rapide.

Dans un travail que j’ai réalisé avec Harold James, un historien de Princeton, nous avons étudié 24 pays et avons comparé la sévérité de leurs crises bancaires. Nous avons constaté que, toute chose égale par ailleurs, les pays où le système bancaire resta stable, comme la Suède, le Japon, les Pays-Bas, réalisèrent de meilleures performances que les pays où il y eut de sévères crises bancaires, comme l’Allemagne, l’Autriche et les Etats-Unis. Donc, certains éléments empiriques confortent l’idée que l’effondrement du système bancaire a été une cause de la Grande Dépression.

Ma seconde étude de cas porte sur la Grande Récession de 2007-2009. J’ai affirmé que la Grande Dépression avait été le produit de deux forces principales, l’étalon-or et la crise financière ou l’effondrement des marchés du crédit. Je vais affirmer que l’effondrement des marchés du crédit fut la principale raison pour la récession de 2007-2009 et pour la très lente reprise qui s’ensuivit.

Il y a eu des changements dans le système financier entre 1929 et 2007. Aux Etats-Unis, plusieurs intuitions financières qui n’étaient pas officiellement des banques grossirent : les sociétés de prêt hypothécaire, les sociétés de crédit à la consommation, les banques d’investissements, les fonds monétaires, les véhicules hors bilan de titrisation... Je pourrais poursuive un long moment. Toutes ces sociétés ou véhicules accordaient des prêts ou détenaient des instruments de crédit, mais il ne s’agissait pas de banques. Le fait qu’elles n’étaient pas des banques signifie fait qu’elles n’étaient pas éligibles à l’assurance-dépôt. Or, elles se finançaient en s’endettant à court terme, ce qui les rendait vulnérables à d’éventuelles ruées.

Aujourd’hui, tout le monde connait les prêts subprime et sait à quel point ils furent désastreux, mais pourquoi ont-ils été si désastreux ? L’une des choses qui nous a surpris à la Réserve fédérale était que les prêts subprime ne constituaient pas une large classe d’actifs. L’un d’entre nous estima que si tous les prêts subprime du monde perdirent toute leur valeur en une journée, ce serait comme une mauvaise journée sur le marché boursier, ce ne serait presque rien. Les prêts subprime ont été si dommageables parce qu’ils étaient disséminés dans l’ensemble du système financier : ils étaient détenus dans les portefeuilles des banques et du système bancaire parallèle, beaucoup d’instruments dérivés étaient liés aux prêts subprime, des titrisations incluaient des prêts subprime, etc.

Les investisseurs financiers, en particulier dans le système bancaire parallèle, mais aussi dans les banques commerciales, craignirent soudainement que leur institution soit très exposée au crédit subprime et à d’autres prêts hypothécaires de mauvaise qualité. Ces institutions connurent une ruée, peut-être une ruée lente dans certains cas, ce qui les poussa à vendre leurs actifs parce qu’elles n’avaient pas les liquidités pour faire des prêts : c’est ce qu’on appelle des ventes en catastrophe ou des ventes forcées (fire sales). Celles-ci firent s’écrouler le prix des instruments de crédit, poussèrent à la hausse les taux d’intérêt sur le crédit et amenèrent au bord de l’insolvabilité le système bancaire parallèle et même de très nombreuses banques majeures en Europe et aux Etats-Unis. (...)

Donc, comme lors de la Grande Dépression, les tensions touchant les marchés du crédit ont été à l’origine de la récession très sévère de 2007-2009 et à la lente reprise subséquente. (…) Lors de la crise financière internationale de 2007-2009, ce fut la panique financière qui poussa les marchés financiers et les institutions financières au bord de la faillite, c’est elle qui constitua le facteur le plus important qui explique la sévérité de la récession. En particulier après l’effondrement de Lehman Brothers en septembre 2008, il y a eu une paralysie complète des prêteurs, des institutions financières, et cela a eu des effets très négatifs sur l’économie.

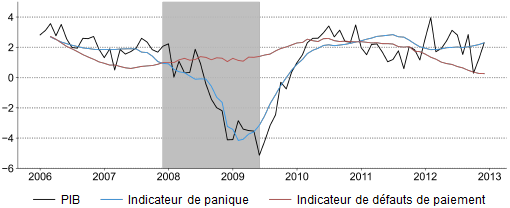

Voici des éléments empiriques tirés d’un article que j’ai écrit en 2018 pour la Brookings Institution. La ligne noire représente la trajectoire suivie par le PIB réel des Etats-Unis, la zone grisée indique la récession. Vous pouvez voir le PIB chuter lors de la récession. La ligne bleue représente ce que j’ai appelé l’indicateur de panique, (…) que l’on obtient lorsque l’on utilise des variables reliées à la panique financière, des choses qui affectent les prêteurs, comme le coût de financement des banques, par exemple, ou le prix de la titrisation du crédit. Comme vous pouvez le voir (…), l’indicateur de panique, c’est-à-dire de turbulences touchant les prêteurs, prévoit extrêmement bien le PIB. Ce que j’appelle l’indicateur de défauts de paiement, qui mesure le taux d’emprunteurs hypothécaires qui ne parviennent plus à rembourser, est corrélé avec le PIB observé, mais plus faiblement. Je ne dis pas qu’il s’agit d’un résultat général, mais, en ce qui concerne cet épisode, la crise touchant Wall Street a été plus importante que les difficultés que connurent les consommateurs et les propriétaires, aussi dangereuses et dommageables qu’elles furent.

Quelles sont les implications de tout cela ? (…) Quand le système financier s’effondra dans les années 1930, avant l’arrivée de Roosevelt au pouvoir, on ne fit rien pour empêcher cet effondrement, si bien qu’il se poursuivit et les marchés du crédit se retrouvèrent paralysés. L’une des leçons que l’on a tirées de la Grande Dépression selon moi est que nous ne pouvons pas laisser cela survenir. La Réserve fédérale et le Trésor ont précisément cherché à stopper la crise financière internationale et à faire en sorte que les institutions financières prêtent à nouveau. C’est ce qu’il faut faire une fois que la crise a éclaté. Le mieux est de ne pas avoir de crise tout court. Comment y parvient-on ? Je pense qu’il est très important d’avoir une réglementation financière qui veille à ce que les institutions financières soient sûres et saines, c’est-à-dire qu’elles aient un bon capital, qu’elles aient des portefeuilles sûrs, qu’elles ne prennent pas de risques excessifs, etc. Et vous devez avoir une approche macroprudentielle, ce qui signifie que vous ne devez pas seulement regarder individuellement les institutions, mais devez également considérer l’ensemble du système et vous demander comment des problèmes touchant un segment du système peuvent en affecter d’autres segments. (...)

Je vais un peu parler de la façon par laquelle ces travaux sont entrés dans la macroéconomie orthodoxe, comment ils devinrent partie intégrante de l’analyse des cycles d’affaires ordinaires (…). Ces modèles de turbulences du crédit peuvent contribuer à expliquer pourquoi les récessions tendent à durer autant qu’elles le font. Même s’il n’y a eu en tout et pour tout qu’un unique choc, une récession va avoir tendance à durer un moment. Et une raison à cela est que, quand un choc touche l’économie, par exemple à nouveau une crise énergétique, cela détériore le revenu et la richesse, cela accroît la prime de financement externe dans l’économie, le marché du crédit devient moins efficace, les difficultés des emprunteurs s’accentuent, les banques deviennent plus frileuses, cela réduit la disponibilité du crédit et tout cela amplifie les effets du choc. L’économie s’en trouve affaiblie plus longtemps que n’a duré le choc initial. Et, dans l’autre sens, s’il y a un choc positif à l’économie, cela améliore la situation des emprunteurs et des prêteurs, cela réduit la prime de financement externe et renforce l’économie. Donc, les facteurs de crédit ou les turbulences sur les marchés du crédit tendent à amplifier les récessions ordinaires et les booms ordinaires, un phénomène que mes coauteurs, Mark Gertler et Simon Gilchrist, et moi avons appelé l’"accélérateur financier" (financial accelerator). Mark, Simon et moi avons créé un modèle macro-économétrique qui incorpore ces facteurs et nous avons constaté que nous pourrions mieux coller aux données, mieux reproduire le comportement effectif de l’économie avec un modèle comme celui-ci.

Nous avons également regardé comment la politique monétaire affecte l’économie. La politique monétaire semble être assez puissante. (…) Et c’est un peu intrigant parce que, par exemple, les études portant sur l'investissement des grosses entreprises montrent que celui-ci n'est pas sensible aux taux d’intérêt de court terme. Donc, qu’est-ce qui fait que l’économie ralentit quand la banque centrale relève ses taux d’intérêt ? Eh bien, ces théories nous donnent quelque chose appelé le "canal du crédit" (credit channel) de la politique monétaire. Si la banque centrale relève ses taux d’intérêt et freine l’économie, cela va avoir tendance à accroître la prime de financement externe en détériorant la situation des emprunteurs et des prêteurs, en réduisant l’emploi, les profits, etc., et cela va déprimer l’économie. Donc, c’est un canal à travers lequel la politique monétaire peut affecter l’économie. Il s’agit donc d’un autre domaine pour lequel ces théories ont contribué, selon moi, à ce que nous comprenions mieux la macroéconomie ordinaire.

(…) Beaucoup de tout cela devrait à présent vous être familier, mais il y a quarante ans, lorsque j’avais 29 ans et que j’écrivais l’article qui fut cité par le Comité Nobel, il y avait très peu d’attention portée à l’instabilité financière en macroéconomie. George Akerlof, un récipiendaire du Nobel, écrivit un très intéressant article historique affirmant que les écoles de pensée en macroéconomie, comme l’école keynésienne, par exemple, ne donnait pas de place à l’instabilité financière comme facteur affectant l’économie. (…) Quand la crise financière éclata en 2008, les modèles de la Réserve fédérale sous-estimaient son impact sur l’économie, parce qu’ils n’étaient pas conçus de façon à prendre en compte le plein effet des turbulences sur les marchés du crédit. Donc, évidemment, pour comprendre les effets des crises financières sur l’économie, nous devons comprendre ces relations. (...) »

Ben Bernanke, « Banking, credit, and economic fluctuations », discours prononcé à la remise du Nobel d’économie, le 9 décembre 2022. Traduit par Martin Anota

aller plus loin...

« Les contributions de Bernanke à la science économique »

« Les répercussions réelles des ruées bancaires »

« Quels sont les canaux de transmission de la politique monétaire conventionnelle ? »

« Endettement, déflation et crises financières »

samedi 5 février 2022

Ce que le « vrai » Schumpeter nous apprend sur le lien entre finance et croissance

Par Martin Anota le samedi 5 février 2022, 21:00

« Joseph A. Schumpeter (1883–1950) est l’un des plus célèbres économistes du vingtième siècle, principalement en raison de son concept de "destruction créatrice" (Schumpeter, 1942). Cependant, ce sont ses analyses de la relation entre système financier et croissance économique qui s’avèrent les plus importantes pour la théorie économique. En conséquence, il est considéré comme le "saint patron" (Solow, 1994) de son champ.

(...) La littérature dominante concernant la relation entre finance et croissance a mésinterprété Schumpeter. (...) Alors que Schumpeter préconisait une approche dans laquelle la monnaie joue un rôle dominant et indépendant (l’"analyse monétaire"), il est présenté comme ayant développé une vision des choses dans laquelle la sphère monétaire est simplement un reflet de la sphère des biens et services (l’"analyse réelle").

Cette mauvaise interprétation s’est révélée être particulièrement coûteuse. Cela explique pourquoi, après des décennies de recherche, la littérature ait des difficultés à expliquer des relations basiques, en particulier la création de liquidité par les banques. En outre, la littérature a jusqu’à présent échoué à fournir des preuves empiriques convaincantes d’effets positifs du système financier sur la croissance dans les pays développés. Elle n’a pas non plus fourni de preuves empiriques démontrant un lien positif entre épargne et croissance du crédit, un lien qui constitue le canal de transmission central de l’analyse réelle.

Nous montrons qu’une interprétation correcte de Schumpeter aide à surmonter les problèmes théoriques et empiriques auxquels la littérature dominante fait face. Avec son approche monétaire, le "vrai Schumpeter" offre un cadre plus réaliste pour analyser le nœud entre finance et croissance. (...)

Les intuitions les plus importantes de l’"analyse monétaire" de Schumpeter sont les suivantes : (i) les banques peuvent créer de façon autonome du crédit et donc de la monnaie (…) ; (ii) les banques jouent un rôle crucial dans le processus de développement économique (…) ; (iii) les épargnants ne sont pas pertinents pour la finance (ou du moins leur rôle dans celle-ci est surévalué), dans la mesure où l’épargne n’est pas nécessaire comme intrant pour le système financier (…) ; (iv) l’"analyse monétaire" ouvre la perspective d’une instabilité financière qui manque dans l’"analyse réelle", où le financement est identique à une hausse du stock de capital (…).

Il est surprenant que, dans la littérature portant sur le lien entre finance et croissance, en particulier dans les publications de Robert King, Ross Levine et Thorsten Beck (...), il y ait des références explicites à Schumpeter comme pionnier théorique sans présenter sa distinction fondamentale entre "analyse réelle" et "analyse monétaire". En fait, les auteurs le présentent même comme un partisan de la théorie des fonds prêtables, dans laquelle les banques agissent simplement comme des intermédiaires entre épargnants et investisseurs. (...) Dans ce qu’on appelle la "théorie de la croissance néoschumpéterienne" (Aghion et Howitt, 1990 ; Aghion et alii, 2015), il n’y a pas de place donnée au banquier, alors que Schumpeter considérait celui-ci comme l’acteur décisif dans le processus d’innovation.

Selon nous, la mésinterprétation de Schumpeter a eu des conséquences négatives pour la recherche sur la relation entre finance et croissance :

- Après des décennies de recherche, Levine (2021) admet que "la littérature n’a toujours pas fourni de réponse définitive aux questions : la finance contribue-t-elle la croissance et, si oui, comment ?" ;

- Il y a de sérieux problèmes dans la littérature avec le concept de "création de liquidité", qui, selon Levine (2021), "est l’un des plus importants services que les banques fournissent à l’économie". Beck et alii (2021) notent qu’il y a "peu de travaux se demandant spécifiquement si et comment la création de liquidité, comme fonction clé des banques pour encourager les investissements de long terme, contribue à la croissance" ;

- Elle a amené la recherche à interpréter le "développement financier" comme un concept statique, à l’inverse de ce que pensaient non seulement Schumpeter (1934), mais aussi Goldsmith (1969), un autre pionnier dans ce champ. Donc, les articles empiriques essayent d’expliquer les effets du système financier sur la croissance avec des variables statiques, notamment le niveau de dette privée relativement au PIB. Alors que des effets positifs peuvent être décelés pour de larges panels dominés par les pays en développement, ce n’est pas le cas pour les pays développés avec des systèmes plus larges et plus développés.

- Les récentes analyses empiriques suggèrent même un effet négatif sur la croissance au-delà d’un certain seul de dette. Levine (2021) note que "les chercheurs n’ont pas expliqué ce qui provoque ces non-linéarités" ;

- Finalement, il n’y a pas non plus d’éléments empiriques pour le rôle crucial que la littérature attribue au système financier comme "mobilisant l’épargne" et pour les effets positifs de l’épargne sur la croissance.

Selon nous, le problème dans la littérature tient à l’usage de l’"analyse réelle", c’est-à-dire de la théorie des fonds prêtables comme cadre théorique :

- A un niveau général, il n’est pas surprenant qu’un modèle dans lequel la sphère financière est identique à la sphère réelle se révèle incapable de comprendre comment la finance affecte la croissance économique dans le système financier moderne, où le système financier est souvent complètement détaché du secteur réel ;

- Comment un modèle dans lequel le rôle des banques se réduit à celui d’intermédiaire d’un bien ordinaire peut-il comprendre le processus de création de liquidité dans la réalité ? La seule approche est le modèle complexe de Diamond et Dybvig (1983), qui se base sur des "hypothèses critiques irréalistes" (Rodrik, 2017). Les articles de la Bundesbank (2017) et des chercheurs de la Banque d’Angleterre (McLeay et alii, 2014) montrent que dans un cadre monétaire, la mécanique de la création de liquidité est relativement simple ;

- Comprendre le rôle des banquiers comme "producteurs de pouvoir d’achat" implique de concevoir le développement financier comme un concept dynamique, si bien que son impact sur la croissance doit être analysé avec les taux de croissance des agrégats financiers. Même la récente analyse de Beck et alii (2021) identifie la "création de liquidité" avec un concept statique de bilan ;

- Puisque le modèle des fonds prêtables suppose que le financement implique toujours une hausse du stock de capital, il se révèle incapable de prendre en compte le "crédit improductif" (Schumpeter, 1939) qui finance la consommation ou l’achat spéculatif d’actifs déjà existants (l’immobilier, les sociétés) ;

- Pour l’analyse monétaire, le manque de lien entre "épargne" et le système financier n’est pas un problème, mais une confirmation que la finance ne se base pas sur l’épargne.

Dans la partie empirique de notre travail, nous avons analysé les effets du système financier sur la base des hypothèses de Schumpeter, en l’occurrence : (i) la croissance du crédit aurait un impact positif sur la croissance du PIB ; (ii) la croissance du crédit serait indépendante de la croissance de l’épargne ; (iii) et la croissance de l’épargne n’aurait pas d’impact sur la croissance du PIB.

En utilisant les données relatives au crédit tirées de la Banque des règlements internationaux (BRI), nous avons testé les hypothèses de Schumpeter. L’importance à utiliser des indicateurs dynamiques pour analyser l’impact de la finance sur la croissance, comme le suggéraient Schumpeter et Goldsmith, apparaît clairement lorsque l’on met en regard les données sur la croissance du PIB et l’indicateur "crédit bancaire sur PIB" versus "croissance du crédit bancaire".

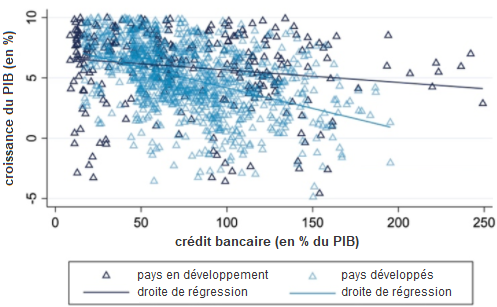

GRAPHIQUE 1 Corrélation entre croissance du PIB et ratio crédit bancaire sur PIB

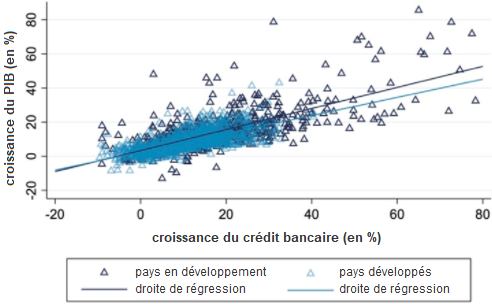

En utilisant les estimations de panel avec diverses spécifications, nous trouvons une forte relation positive entre croissance du crédit et croissance du PIB, à la fois dans les pays développés et en développement (cf. graphiques). Pour les pays développés, cependant, l’effet sur la croissance est seulement significatif dans la période avant 2000. Nous ne trouvons pas d’effets positifs de l’épargne sur la croissance du PIB ou la croissance du crédit.

GRAPHIQUE 2 Corrélation entre croissance du PIB et croissance du crédit bancaire

Pour tester la causalité entre croissance du crédit et croissance du PIB, nous avons ensuite utilisé un modèle VAR pour les Etats-Unis. Les fonctions de réponse aux impulsions suggèrent un effet positif d’un choc d’offre de crédit sur la croissance du PIB, tandis que nous trouvons des effets négatifs et non significatifs pour un choc d’épargne. Finalement, nous avons mené des tests de causalité à la Granger pour 43 pays afin d’analyser l’interaction entre croissance du PIB et croissance du crédit. Les données montrent que la causalité à la Granger va dans les deux sens, ce qui est cohérent avec l’approche de la "seconde vague" de Schumpeter. Comme test de robustesse, nous avons utilisé les décompositions de la variance des erreurs de prévision, qui confortent nos résultats au test de Granger. Les pays où il y a une causalité à la Granger du crédit vers le PIB présentent aussi une forte contribution des chocs de crédit au PIB.

(…) Notre contribution montre que Schumpeter, bien que rituellement célébré dans la littérature, a en fait été de facto ignoré ou, pire, mésinterprété. La littérature sur le lien entre finance et croissance est toujours dominée par la théorie des fonds prêtables ou "analyse réelle", qui est l’opposé direct à l’"analyse monétaire" que proposa Schumpeter. Cette mésinterprétation n’est pas seulement un problème pour l’histoire de la pensée économique ; elle a aussi mené la recherche théorique et empirique sur un mauvais chemin. Rien ne reflète plus cela que son incapacité à expliquer simplement et de façon réaliste le processus de "création de la liquidité". Le manque d’éléments empiriques pour les principaux canaux de transmission évoqués par la littérature et la robustesse des éléments empiriques allant dans le sens du "vrai" Schumpeter ont des implications qui vont bien au-delà du nœud entre finance et croissance. Ce qui est remis en cause, c'est toute la littérature macroéconomique sur la finance (par exemple les travaux de Mian et alii, 2021a ; 2021b), toujours basée sur le paradigme de l’analyse réelle, où la sphère monétaire n’est rien d’autre qu’une sphère réelle travestie. »

Peter Bofinger, Lisa Geißendörfer, Thomas Haas et Fabian Mayer, « Discovering the ‘true’ Schumpeter: New insights on the finance and growth nexus », voxEU.org, 3 février 2022. Traduit par Martin Anota

aller plus loin...

« Les modèles ne saisissent toujours pas ce qu’est une banque »

« La finance est-elle bénéfique à la croissance économique ? »

« La hausse du taux d’épargne stimule-t-elle la croissance ? »

« billets précédents - page 1 de 12