« Aux Etats-Unis, des entreprises comme Google, Amazon et Facebook dominent leurs marchés respectifs comme AT&T et IBM dominaient les leurs à leur apogée. L’essor de ces nouveaux titans a suscité des craintes tout le long du spectre politique, beaucoup s’inquiétant à l’idée que les oligopoles puissent déprimer les salaires et qu’ils pénalisent les consommateurs. Mais ces peurs peuvent être excessives.

Un article publié dans la revue American Economic Journal: Microeconomics confirme que les oligopoles se développent dans plusieurs secteurs, mais que la concentration des marchés est positivement corrélée à la productivité et à la croissance de la production réelle, ce qui est bénéfique pour l’économie dans son ensemble.

"Je pense qu’une grande partie du débat aux Etats-Unis à propos des monopoles et de la concentration de marché ignore les faits sous-jacents à propos de ce qui s’est passé ces quarante à cinquante dernières années", déclare Sharat Ganapati, l’auteur de l’étude, à l’American Economic Association. "Je pense que la chose la plus importante à propos de cet article est qu’il présente ce qui s’est passé du côté des prix, de la concentration, de la production et de la productivité".

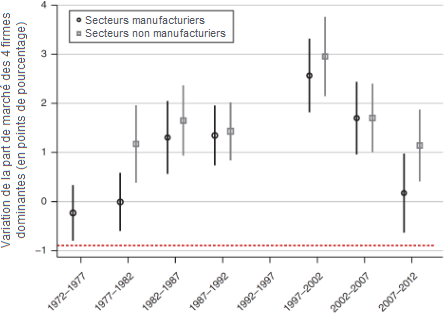

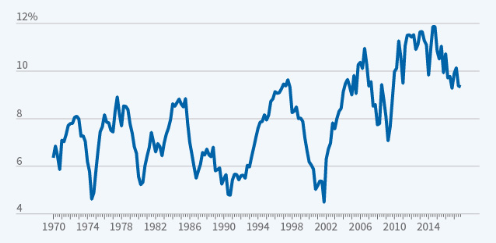

Ganapati a analysé la majorité de l’économie du secteur privé, représentant plus de 75 % de la production brute en 2012, et les données des prix pour la période allant de 1972 à 2012. Le graphique ci-dessous montre la croissance de la part de marché moyenne des quatre plus grosses entreprises dans des intervalles de cinq ans. Par exemple, entre 1997 et 2002, les quatre plus grosses entreprises accrurent leur part de marché d’une moyenne de 2,5 %.

Les données ont révélé quelques schémas qui ne collent pas avec une vision naïve des monopoles économiques. Dans les modèles les plus basiques, si les entreprises sont assez grosses pour influencer le marché, elles essayent de le faire en restreignant la production et en accroissant les prix pour les consommateurs. Or, Ganapati trouve que, lorsque la concentration s’est accrue dans un secteur, elle a en fait eu tendance à s’accompagner d’une plus forte croissance de la production réelle. Une hausse de 10 % de la part de marché nationale des quatre plus grosses entreprises était corrélée à une hausse de 1 % de la production réelle. De plus, les hausses de prix ne furent pas du tout corrélées avec la hausse de la concentration du marché. En d’autres mots, dans le cadre des réglementations antitrust actuelles, l’essor des oligopoles aux Etats-Unis ne semble pas avoir exercé une influence négative sur le marché et les consommateurs ne semblent pas avoir vu leur situation se détériorer. Du côté de l’emploi, les travailleurs dans les secteurs concentrés semblent en fait avoir une meilleure situation que les travailleurs des secteurs moins concentrés. Une hausse de 10 % de la part de marché des quatre plus grosses entreprises était associée à une hausse de 0,4 % des salaires.

Pourquoi la hausse de la concentration ne semble-t-elle pas être un problème ? Les données suggèrent que les sociétés dominantes innovent d’une façon qui les rend plus productives. Une hausse de 10 % de la part de marché des quatre plus grosses firmes était associée à une hausse de 2 % de la productivité du travail. Au niveau des secteurs, quelques meneurs ont accru la productivité, ce qui leur a permis d’accroître la production réelle et de maintenir les prix à la baisse, tout en maintenant ou en réduisant la taille de leur main-d’œuvre.

L’image qui émerge est celle de quelques firmes dites superstars dépassant leurs concurrents à travers une course aux armements technologique. Mais Ganapati dit que ces entreprises ont souvent davantage ressemblé à Walmart et Sysco (un fournisseur international d’aliments) qu’à Google et Facebook. "Walmart est un bon exemple de ce qui se passe. Ils ont dépensé des milliards de dollars dans les années 1980 et au début des années 1990 pour numériser toutes leurs infrastructures", dit Ganapati. "Cela leur a donné une avance de près de vingt ans dans le secteur des magasins de grande surface, leur permettant de tuer des rivaux comme Sears et JCPenney."

Cela ne signifie pas que ces entreprises ont passé tous leurs gains de productivité aux consommateurs, précise Ganapati. Elles sont toujours incroyablement profitables. C’est juste que certains de ces profits sont potentiellement mérités parce que ces entreprises ont investi dans les bonnes idées avant qu’elles ne deviennent profitables. En d’autres termes, les firmes superstars peuvent faire des profits aujourd’hui pour compenser leurs pertes par le passé. En outre, il y a toujours certains secteurs qui ont présenté des symptômes classiques de monopoles traditionnels. En particulier, la concentration de marché dans le secteur des soins de santé a été corrélée avec les hausses de prix.

Le travail de Ganapati montre que plusieurs questions à propos des monopoles sont d'ordre empirique et que les potentiels effets nocifs qu'ils provoquent s’échelonnent sur un spectre. "Au lieu de dire qu’il est mauvais d’être gros, vous devez plutôt dire pourquoi il est mauvais d’être gros. Parce que dans certains cas, la taille mène à un surcroît de productivité. Mais dans d’autres cas, elle mène à un comportement véritablement anticoncurrentiel", ajoute Ganapati. "La vraie question est de savoir comment réguler efficacement les firmes sans détruire le lien à la productivité." »

Tyler Smith, « Consolidation and productivity. Should the United States be worried about its growing monopolies? », American Economic Association, Research Highlights, 17 septembre 2021. Traduit par Martin Anota

aller plus loin...

« L’exubérant pouvoir de marché des firmes américaines »

« Faut-il s’inquiéter de la concentration des marchés aux Etats-Unis ? »

« Pourquoi les barrières à l’entrée se sont-elles renforcées aux Etats-Unis ? »

Marchés et concurrence

lundi 20 septembre 2021

Faut-il s’inquiéter de l’essor des monopoles aux Etats-Unis ?

Par Martin Anota le lundi 20 septembre 2021, 17:00

mardi 20 avril 2021

Football : d’un sport populaire à un spectacle pour les seuls riches

Par Martin Anota le mardi 20 avril 2021, 10:00

« Je devrais avoir une certaine satisfaction. Tout le cinquième chapitre du Capitalisme sans rival expose la marchandisation croissante de tout, notamment du temps de loisirs et de notre vie quotidienne. En novembre dernier, dans un entretien accordé au magazine Forbes, j’avais dit qu’une ligue de football paneuropéenne était inévitable : les clubs sont gérés comme de pures machines à fric, il y a énormément d’argent à se faire et les meilleurs clubs vont insister pour être plus exclusifs et pour ne jouer qu’avec de fortes équipes. Je pensais aussi que c’était une question de temps avant que le football international ne meure. Les propriétaires de club ne veulent pas exposer les joueurs pour lesquels ils ont dépensé des millions d’euros à des efforts inutiles et de possibles blessures en jouant dans des compétitions qui importent peu et qui ne rapportent guère financièrement. Pourquoi devrions-nous nous attendre à ce que certains pans de nos vies ne restent guère marchandisées lorsque tout le reste l’est et que nous participons nous-mêmes fiévreusement à cette puissante marchandisation ? Nous y participons en mettant en location nos logements, nos voitures, en signant des contrats prénuptiaux et de non-divulgation (ce qui, dans ce dernier cas, nous amène à vendre notre droit à la libre expression, au bon prix).

Le football est-il au-dessus ? La réponse est non. Il est exactement ce que nous voulons qu’il soit : marchandisé à l’extrême. Il fait exactement ce que l’expansion incessante du capitalisme hyper-commercialisé requiert. Donc, devrions-nous cesser de nous plaindre ?

Peut-être. Mais même si nous cessions de le faire, nous ne pourrions pas ne pas prendre conscience que ce que les douze clubs se proposent de faire est un saut quantique dans une direction regrettable (et dans une certaine mesure honteuse). Alors que la commercialisation croissante du football se poursuivait, le football avait essayé, du moins formellement, de préserver une apparence d’ouverture. Même quand la Ligue des Champions avait changé son format en cessant d’être ouverte aux meilleurs clubs de tous les pays européens placés sur un pied d’égalité pour allouer davantage de points aux meilleures divisions, elle n’avait pas entièrement fermé la porte. Les petits clubs dans les grandes divisions pouvaient toujours espérer parvenir à atteindre la Ligue des Champions en réalisant de bonnes performances dans la ligue nationale ; les gros clubs dans les petites divisions pouvaient toujours espérer parvenir à atteindre la Ligue des Champions après plusieurs étapes de classification. La porte était fermée à la compétition égale entre grands et petits clubs, mais pas encore totalement.

A présent, elle est close. Nous devrions avoir 12 ou 16 ou 18 équipes se battre à jamais entre elles, sans craindre la relégation et sans incitation, ou plutôt possibilité, pour une autre équipe de rejoindre cet auguste groupe. Il est inutile se souligner à quel point c’est éloigné de ce que le football a signifié le siècle passé, plus exactement de sa singulière marchandisation comme sport international. Il a souvent été le véhicule à des aspirations politiques, sociales, économiques ou nationales ; il fut un lieu de rencontre quand tous les autres espaces étaient clos ; il était l’endroit où vous pouviez chanter des slogans contre le gouvernement en place lorsqu’ailleurs vous étiez chassé par la police ou jeté en prison. Ce fut un lieu de mobilité sociale si vous étiez un joueur ou de mixité sociale si vous étiez dans les tribunes. Ce fut un endroit où les gens se tenaient deux heures sous la pluie ou la neige pour voir les joueurs qu’ils adulaient. Il créait non seulement de grands footballeurs, mais aussi des personnes inestimables avec une singularité, des opinions et des croyances. Maradona n’est pas grand seulement parce qu’il a mis de très impressionnants buts (notamment avec sa main), mais aussi parce qu’il refusait de se taire, de jouer le jeu de l’extrême commercialisation quand les joueurs étaient payés pour courir et ne jamais donner leur opinion, quand ils étaient des modèles semblables à des automates.

Le début de la Super Ligue met un terme formel à tout cela. Ile formalise en effet l’étape à laquelle le football est malheureusement arrivé. Ce n’est pas un coup de tonnerre dans un ciel serein. C’était une tempête bien prévue. Nous devrions avoir, comme au tennis, une ligue de robots, contrôlés par leurs maîtres kleptocratiques internationaux. Ils pourraient jouer seulement dans quelques pays présélectionnés (quatre dans le cas du tennis, peut-être trois ou quatre au football), dans des stades présélectionnés, devant des spectateurs sélectionnés, se voir permis de dire seulement les platitudes les plus triviales. Ce sera la fin du football tel qu’il a essayé d’être pendant plus d’un siècle. Ce sera une sorte de jeu où que nous pourrions présenter à nos usagers, avec des joueurs qui semblent juste être des créatures vivantes. »

Branko Milanovic, « From a people’s game to a game fit for the rich only », in globalinequality (blog), 19 avril 2021. Traduit par Martin Anota

lundi 12 octobre 2020

Paul Milgrom et Robert Wilson, des Nobel en quête de l’enchère parfaite

Par Martin Anota le lundi 12 octobre 2020, 17:00

« Chaque jour, les enchères allouent des valeurs astronomiques entre acheteurs et vendeurs. Les lauréats de cette année, Paul Milgrom et Robert Wilson, ont amélioré la théorie des enchères et inventé de nouveaux formats d’enchères, au bénéfice des vendeurs, des acheteurs et des contribuables à travers le monde.

Les enchères ont une longue histoire. Dans la Rome antique, les prêteurs utilisaient les enchères pour vendre les actifs qu’ils avaient confisqués des emprunteurs qui s’étaient révélés incapables de rembourser leur dette. La plus vieille maison d’enchères au monde, la Stockholms Auktionsverk, a été fondée en 1674, également avec l’objectif de vendre des actifs confisqués.

Aujourd’hui, quand nous entendons le mot "enchère", nous pensons peut-être à des enchères agricoles traditionnelles ou à des ventes d’œuvres d’art, mais il peut aussi s’agir de vendre quelque chose sur internet ou d'acheter un logement via un agent immobilier. Les résultats des enchères sont aussi très importants pour nous, en tant que contribuables et de citoyens. (…) Les prix de l’électricité, qui sont quotidiennement déterminés par les enchères régionales d’électricité, influencent le coût du chauffage de nos logements. La couverture de notre téléphone portable dépend des fréquences radio que les opérateurs téléphoniques ont acquises via des enchères de fréquences. Tous les pays contractent désormais des prêts en vendant des obligations publiques aux enchères. L’objectif de la mise aux enchères des quotas d’émissions par l’Union européenne est d’atténuer le réchauffement climatique.

Donc, les enchères nous affectent tous à différents niveaux. En outre, elles sont devenues de plus en plus fréquentes et de plus en plus compliquées. C’est là où les lauréats de cette année ont produit des contributions majeures. Ils n’ont pas simplement clarifié comment les enchères fonctionnent et pourquoi les enchérisseurs se comportent de telle ou telle façon, mais ils ont aussi utilisé leurs découvertes théoriques pour inventer des formats d’enchères entièrement nouveaux pour la vente de biens et services. Ces nouvelles enchères se sont largement diffusées à travers le monde.

La théorie des enchères

Pour comprendre les contributions des lauréats, nous devons en savoir un peu à propos de la théorie des enchères. Le résultat d'une enchère (…) dépend de trois facteurs. Le premier est les règles de l'enchère, ou format. Les offres sont-elles ouvertes ou fermées ? Combien d'offres les enchérisseurs peuvent-ils faire ? Quel prix paie le gagnant ? leur offre ou la deuxième offre la plus élevée ? Le deuxième facteur tient à l'objet mis aux enchères. A-t-il une valeur différente pour chaque enchérisseur ou valorisent-ils l'objet de la même façon ? Le troisième facteur concerne l'incertitude. Quelle information les différents enchérisseurs ont-ils à propos de la valeur de l'objet ?

En utilisant la théorie des enchères, il est possible d’expliquer comment ces trois facteurs gouvernent le comportement stratégique des enchérisseurs et donc le résultat de l’enchère. La théorie peut aussi montrent comment concevoir une enchère pour créer le plus de valeur possible. Les deux tâches sont particulièrement difficiles quand de multiples objets liés sont mis aux enchères en même temps. Les lauréats du prix en sciences économiques cette année ont rendu la théorie des enchères plus applicables en pratique via la création de formats d’enchères nouveaux, sur mesure.

Différents types d’enchères

Les maisons d’enchères autour du monde vendent habituellement des objets individuels en utilisant les enchères anglaises. Ici, le commissaire-priseur commence avec un prix bas et propose ensuite des prix de plus en plus élevés. Les participants peuvent voir toutes les offres et choisir s’ils veulent placer une offre plus élevée. Quel qu’il soit, celui qui propose l’offre la plus élevée gagne l’enchère et paye le prix de son offre. Mais d’autres enchères ont des règles complètement différentes ; une enchère hollandaise commence avec un prix élevé, qui est ensuite peu à peu réduit jusqu’à ce que l’objet soit vendu.

Les enchères anglaises et hollandaises ont des offres ouvertes, donc tous les participants voient les offres. Dans d’autres types d’enchères, cependant, les offres sont fermées. Dans les marchés publics, par exemple, les enchérisseurs proposent souvent des offres scellées et l'autorité publique choisit le fournisseur qui s’engage à assurer le service au prix le plus faible, tout en respectant les exigences de qualité spécifiques. Dans certaines enchères, le prix final est l’offre la plus élevée (enchères au premier prix), mais dans d’autres formats le gagnant paye la deuxième offre la plus élevée (enchères au deuxième prix).

Quel format d’enchères est le meilleur ? Cela ne dépend pas seulement de son résultat, mais aussi de ce que nous entendons par "meilleur". Les vendeurs privés espèrent surtout obtenir le prix le plus élevé. Les vendeurs publics ont des objectifs plus larges, de façon à ce que les biens soient vendus par l’enchérisseur qui délivre le plus important bénéfice à long terme pour la société dans son ensemble. La quête de la meilleure enchère est un problème épineux qui travaille depuis longtemps les économistes.

La difficulté avec l’analyse des enchères est que la meilleure stratégie d’un enchérisseur dépend de ses croyances quant aux offres des autres participants. Est-ce que certains enchérisseurs croient que l’objet vaut davantage que ne le pensent d’autres ? Est-ce que ces différences de valorisation reflètent le fait que certains enchérisseurs ont une meilleure information à propos des caractéristiques et de la valeur des biens ? Les enchérisseurs peuvent-ils coopérer et manipuler l’enchère afin de maintenir le prix final à un faible niveau ?

Les valeurs privées

Le lauréat en sciences économiques de 1996, William Vickrey, a fondé la théorie des enchères au début des années 1960. Il a analysé un cas spécial, dans lequel les enchérisseurs ont seulement des valeurs privées pour le bien ou service mis aux enchères. Cela signifie que les valeurs des enchérisseurs sont entièrement indépendantes l’une de l’autre. Par exemple, cela peut être une enchère de bienfaisance pour un dîner avec une célébrité (disons un lauréat du Nobel). Le montant que vous seriez prêt à payer est subjectif : votre propre valorisation n’est pas affectée par la valorisation du dîner qu’en ont les autres enchérisseurs. Donc comment devriez-vous enchérir dans un tel type d’enchère ? Vous ne devez pas enchérir plus que la valeur que le dîner a à vos yeux. Mais devez-vous enchérir moins, pour peut-être obtenir le dîner à un prix inférieur ? Vickrey a montré que les meilleurs formats d’enchères connus (comme les enchères anglaises et hollandaises) donnent le même revenu attendu pour le vendeur, à condition que tous les enchérisseurs soient rationnels et neutres au risque.

Les valeurs communes

Les valeurs entièrement privées constituent un cas extrême. La plupart des objets d’enchères (comme les titres, les droits de propriété et d’extraction) ont une considérable valeur commune, ce qui signifie qu’une partie de la valeur est égale à tous les enchérisseurs potentiels. En pratique, les enchérisseurs ont aussi différents montants d’information privée à propos des propriétés de l’objet.

Prenons un exemple concret. Imaginons que vous soyez un diamantaire et que vous, tout comme les autres diamantaires, considériez une offre sur un diamant brut, donc que vous pourriez produire des diamants taillés et les vendre. Votre consentement à payer dépend seulement de la valeur de revente des diamants taillés qui, elle-même, dépend de leur nombre et de leur qualité. Les différents diamantaires ont différentes opinions à propos de cette valeur commune, en fonction de leur expertise, de leur expérience et du temps qu’ils ont eu pour examiner le diamant. Vous pourriez mieux estimer la valeur si vous aviez accès aux estimations des autres diamantaires, mais chaque diamantaire préfère garder ses informations secrètes.

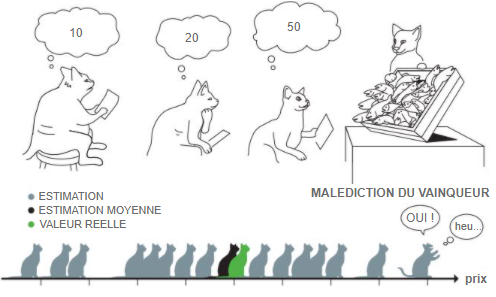

Les enchérisseurs dans les enchères avec valeurs communes courent le risque que les autres enchérisseurs aient de meilleures informations à propos de la vraie valeur. Cela mène au phénomène bien connu des offres basses en enchères réelles, connu sous le nom de malédiction du vainqueur. Imaginons que vous gagniez l’enchère du diamant brut. Cela signifie que les autres enchérisseurs valorisent moins le diamant que vous ne le valorisez, si bien que vous avez très certainement réalisé une perte lors de la transaction.

Robert Wilson a été le premier à créer un cadre pour analyser les enchères avec valeurs communes et à décrire comment les enchérisseurs se comportent en de telles circonstances. Dans trois articles classiques publiés lors des années 1960 et 1970, il décrit la stratégie d’enchère optimale pour une enchère au premier prix quand la vraie valeur est incertaine. Les participants vont proposer des offres plus faibles que leur meilleure estimation de la valeur, pour éviter de faire une mauvaise affaire et donc être touché par la malédiction du vainqueur. Son analyse montre aussi qu’avec une plus grande incertitude, les enchérisseurs vont être plus prudents et le prix final sera plus faible. Finalement, Wilson montre que les problèmes provoqués par la malédiction du vainqueur sont même accrus quand certains enchérisseurs ont de meilleures informations que d’autres. Ceux qui ont un désavantage informationnel vont alors proposer des offres encore plus basses ou complètement s’abstenir de participer à l’enchère.

Les valeurs à la fois privées et communes

Dans la plupart des enchères, les enchérisseurs ont des valeurs à la fois privées et communes. Supposons que vous pensez enchérir dans une enchère pour un appartement ou une maison ; votre consentement à payer dépend alors de votre valeur privée (combien vous appréciez son état, son plan de sol et sa localisation) et de votre estimation de la valeur commune (combien vous pensez récupérer en vendant le logement dans le futur). Un fournisseur d’énergie qui enchérit sur le droit d’extraire du gaz naturel s’inquiète à propos de la taille du réservoir de gaz (une valeur commune) et du coût d’extraction du gaz (une valeur privée, comme le coût dépend de la technologie disponible à la société). Une banque qui enchérit pour des obligations publiques considère le futur taux d’intérêt de marché (une valeur commune) et le nombre de ses clients qui veulent acheter des obligations (une valeur privée). Analyser les offres dans des enchères avec des valeurs privées et communes se révèle être un problème encore plus épineux que les cas spéciaux analysés par Vickrey et Wilson. La personne qui a finalement résolu ce problème a été Paul Milgrom, dans une poignée d’articles publiés autour de 1980.

L’analyse de Milgrom (en partie avec Robert Weber) inclut de nouvelles intuitions importantes à propos des enchères. L’une de ces inquiétudes est de savoir dans quelle mesure différents formats d’enchères permettent de traiter le problème de la malédiction du vainqueur. Dans une enchère anglaise, le commissaire-priseur commence avec un faible prix et le relève. Les enchérisseurs qui observent le prix auquel d’autres enchérisseurs quittent l’enchère obtiennent ainsi des informations à propos de leurs valorisations ; comme les enchérisseurs restants ont alors plus d’informations qu’au départ de l’enchère, ils sont moins enclins à enchérir sous leur valeur estimée. D’un autre côté, une enchère hollandaise, où le commissaire-priseur commence avec un prix élevé et le réduit jusqu’à ce que quelqu’un désire acheter l’objet, ne génère pas de nouvelles informations. Le problème avec la malédiction du vainqueur est donc plus grand dans les enchères hollandaises que dans les enchères anglaises, ce qui se traduit par de plus faibles prix finaux.

Ce résultat particulier reflète un principe général : un format d’enchère fournit plus de recettes si le lien entre les offres et l’information privée des enchérisseurs est renforcé. Par conséquent, le vendeur a un intérêt à fournir aux participants autant d’informations que possible à propos de la valeur de l’objet avant que les enchères commencent. Par exemple, le vendeur d’un logement peut anticiper un prix final plus élevé si les enchérisseurs ont accès à une estimation d’expert (indépendant) avant le début de l’enchère.

Les meilleures enchères en pratique

Milgrom et Wilson se sont non seulement dévoués à la théorie fondamentale des enchères. Ils ont aussi inventé de nouveaux meilleurs formats pour les situations complexes dans lesquelles les formations d’enchères existantes ne peuvent être utilisées. Leur contribution la plus connue est l’enchère qu’ils conçurent la première fois que les autorités américaines vendirent les fréquences radio aux opérateurs télécom.

Les fréquences radio qui permettent la communication sans fil (les appels mobiles, les paiements sur internet ou les vidéoconférences) sont des ressources limitées de grande valeur pour les consommateurs, les entreprises et la société. Ces fréquences sont possédées par le gouvernement, mais les acteurs privés peuvent souvent les utiliser plus efficacement. Les autorités ont donc souvent cherché à allouer l’accès de ces bandes de fréquences à ces acteurs. Ce fut initialement fait via un processus connu sous le nom de concours de beauté, dans lequel les sociétés ont à fournir des arguments justifiant pourquoi elles doivent recevoir une licence. Ce processus a amené les sociétés de télécommunications et de médias à dépenser de larges montants d’argent en lobbying. Les recettes générées par le processus furent cependant limitées.

Dans les années 1990, lorsque le marché de la téléphonie mobile se développait, les autorités responsables aux Etats-Unis, la Federal Communications Commission (FCC), prirent conscience que les concours de beauté n’étaient pas tenables. Le nombre de compagnies de mobiles s’est rapidement accru et la FCC s’est retrouvée submergée de demandes d’accès aux fréquences radio. Après avoir subi des pressions de la FCC, le Congrès américain permit l’usage de loteries pour allouer les bandes de fréquences. Le concours de beauté était donc remplacé par une allocation entièrement aléatoire de licences, qui ne générèrent pourtant qu’un revenu limité pour le gouvernement.

Cependant, les opérateurs mobiles n’étaient pas heureux. Les loteries étaient menées à un niveau local, donc les opérateurs mobiles nationaux n’obtenaient généralement que des réseaux discontinus avec différentes bandes de fréquences dans différentes régions. Les opérateurs essayèrent alors d’acheter et de vendre des fréquences entre eux, menant à l’émergence d’un large marché de l'occasion pour les licences. Entretemps, la dette nationale croissante des Etats-Unis rendit cela de plus en plus politiquement difficile de continuer de distribuer des licences presque gratuitement. La valeur de marché des licences s’élevait à plusieurs milliards de dollars, de l’argent qui finissait dans les mains de spéculateurs de fréquences à la place de bons du Trésor américain (une perte de recettes qui serait en définitive supportée par les contribuables). Finalement, en 1993, il fut décidé que les bandes de fréquences seraient distribuées en utilisant les enchères.

De nouveaux formats d’enchères

Maintenant, un nouveau problème se pose : comment concevoir une enchère qui atteigne l’allocation efficient des bandes de fréquences ratio, tout en bénéficiant un maximum aux contribuables ? Ce problème se révèle être très difficile à résoudre, puisqu’une bande de fréquence a à la fois des composantes de valeur privée et de valeur commune. En outre, la valeur d’une bande de fréquence spécifique dans une région spécifique dépend des autres bandes de fréquences détenues par un opérateur spécifique.

Considérons un opérateur qui cherche à construire un réseau mobile national. Disons qu’un régulateur suédois mette aux enchères des bandes de fréquence une par une, en commençant par la Laponie au nord pour ensuite s’enfoncer peu à peu vers le sud jusqu’à la province de la Scanie. A présent, la valeur de la licence de Laponie dépend de la possibilité pour l’opérateur de réussir à acheter des licences lors des enchères suivantes jusqu’à la Scanie et du prix de ces achats. L’opérateur ne connait pas le résultat des enchères futures, donc il est presque impossible de savoir combien il devra payer pour acquérir la licence. En outre, des spéculateurs peuvent essayer d’acheter la bande de fréquence exacte dont l’opérateur a besoin à la Scanie, afin de la lui vendre à un prix élevé sur le marché de l’occasion.

Cet exemple suédois illustre un problème général. Pour le contourner, la première enchère étasunienne devait allouer toutes les zones géographiques du sceptre radio en même temps. Elle devait aussi gérer de nombreux enchérisseurs. Pour surmonter ces problèmes, Milgrom et Wilson (en partie avec Preston McAfee), inventèrent un format d’enchères entièrement nouveau, l’enchère à plusieurs tours simultanés (simultaneous multiple round auction, SMRA). Cette enchère offre tous les objets (les bandes de fréquences radio dans différentes zones géographiques) simultanément. En commençant avec les prix les plus faibles et en laissant la possibilité d’offres répétées, l’enchère réduit les problèmes provoqués par l’incertitude et la malédiction du vainqueur. Quand la FCC utilisa pour la première fois une SMRA, en juillet 1994, elle vendit 10 licences dans 47 tours d’enchères pour un total de 617 millions de dollars, des objets que le gouvernement américain avait précédemment alloués quasiment gratuitement. La première enchère du spectre utilisant une SMRA a généralement été considérée comme un grand succès. Plusieurs pays (notamment la Finlande, l’Inde, le Canada, la Norvège, la Pologne, l’Espagne, le Royaume-Uni, la Suède et l’Allemagne) ont adopté le même format pour leurs enchères du spectre. Les enchères de la FCC, utilisant ce format, ont rapporté plus de 120 milliards de dollars entre 1994 et 2014 et, globalement, ce mécanisme a généré plus de 200 milliards de dollars des ventes du spectre. Le format SMRA a aussi été utilisé dans d’autres contextes, notamment pour les ventes d’électricité et de gaz naturel.

Les théoriciens des enchères (souvent en travaillant avec des informaticiens, des mathématiciens et des spécialistes du comportement) ont raffiné les nouveaux formats d’enchères. Ils les ont aussi adaptés pour réduire les opportunités de manipulation et de coopération entre enchérisseurs. Milgrom est l’un des architectes d’une enchère modifiée (la combinatorial clock auction) dans laquelle les opérateurs peuvent enchérir sur des « paquets » de fréquences, plutôt que sur des licences individuelles. Ce type d’enchères requiert une forte puissance de calcul, comme le nombre de paquets possibles augmente très rapidement avec le nombre de fréquences en vente. Milgrom est aussi un développeur de premier plan pour un nouveau format avec deux tours (l’incentive auction). Au premier tour, vous achetez les fréquences radio des détenteurs actuels de fréquences. Au second tour, vous vendez ces fréquences à d’autres acteurs qui peuvent les gérer plus efficacement. (…) »

Académie royale des sciences de Suède, « The quest for the perfect auction », Popular science background, 12 octobre 2020. Traduit par Martin Anota

lundi 13 janvier 2020

Economie et politique de la concentration des marchés

Par Martin Anota le lundi 13 janvier 2020, 17:00

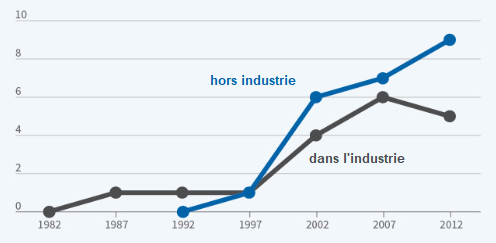

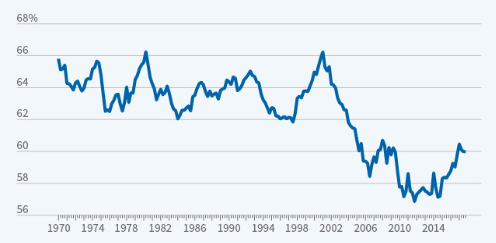

« La concentration des entreprises et les marges de profits se sont accrues dans la plupart des secteurs aux Etats-Unis au cours des vingt dernières années. Le graphique 1 illustre ces tendances ainsi que les déclins de la part du travail et de l’investissement privé. Le ratio profit des entreprises après impôts sur valeur ajoutée a augmenté, passant en moyenne de 7 % au cours de la période allant de 1970 à 2002 à une moyenne de 10 % dans la période consécutive à 2002. Les entreprises avaient auparavant tendance à réinvestir environ 30 cents de chaque dollar de profit ; désormais, elles investissent seulement 20 cents pour chaque dollar de profit.

La bonne concentration versus la mauvaise concentration

Une question cruciale pour la recherche est si ces tendances reflètent un pouvoir de marché et la recherche de rentes ou bien des facteurs plus bénins, tels qu’un changement vers les actifs immatériels avec des effets de rendements d’échelle. La principale difficulté est que la relation entre la concentration et la concurrence est ambiguë.

GRAPHIQUE 1a Ratio de concentration des marchés

La concentration et la concurrence sont positivement reliées l’une à l’autre quand les chocs touchant la concurrence ex post jouent un rôle dominant dans les données. Par exemple, une baisse des coûts de recherche complique la survie des producteurs inefficaces, les force à fusionner ou à sortir du marché et entraîne en définitive une plus forte concentration. Un creusement des écarts de productivité entre les entreprises, souvent en raison des actifs immatériels, peut jouer un rôle similaire. Si ces explications sont les bonnes, les entreprises restantes sur le marché doivent être les plus productives et la concentration doit aller main dans la main avec une forte croissance de la productivité et l’investissement immatériel.

GRAPHIQUE 1b Profits des entreprises après impôts (en % de la valeur ajoutée)

La concentration et la concurrence sont négativement liées l’une à l’autre quand les chocs touchant les coûts d’entrée jouent un rôle dominant dans les données. Cela peut résulter des changements dans l’application de la législation antitrust, des barrières à l’entrée ou de la menace de comportements prédateurs de la part des entreprises en place. Si ces explications-là sont les bonnes, la concentration doit être négativement reliée à la productivité et à l’investissement.

GRAPHIQUE 1c Rémunérations des salariés (en % de la valeur ajoutée brute)

Certains secteurs collent à l’hypothèse de la concentration efficace, tandis que d’autres collent à celle de la recherche de rentes. Ali Hortaçsu et Chad Syverson affirment que l’essor des hypermarchés et du e-commerce reflète les gains d’efficacité dans le secteur de la grande distribution. Le secteur du commerce de gros semble aussi coller à ce schéma. Le secteur des télécommunications, d’un autre côté, colle au schéma de la quête de rentes. Il est devenu de plus en plus concentré et Germán Gutiérrez et moi avons montré que les consommateurs américains payent aujourd’hui deux fois plus pour les services de téléphonie mobile et de haut débit que les citoyens de quasiment tous les autres pays développés. Certains secteurs de haute technologie combinent les aspects des deux types de concentration. L’une des raisons, comme Nicolas Crouzet et Janice Eberly l’affirment, est que le capital immatériel génère simultanément de forts rendements et des rentes élevées.

GRAPHIQUE 1d Investissement net (en % de l'excédent net d'exploitation)

Au cours des vingt dernières années, la concentration négative est cependant devenue relativement plus importante aux Etats-Unis. Les récentes hausses de la concentration ont été associées à une faible croissance de la productivité et à une baisse des taux d’investissement. Les entreprises dans les secteurs où la concentration augmente s’engagent dans des fusions et acquisitions plus profitables et dépensent davantage dans le lobbying. Les profits excessifs ne sont plus annulés par la libre entrée et la rotation des meneurs de chaque secteur a diminué.

L’économie politique de la concentration

Si la "mauvaise" concentration a fini par prévaloir, nous devons comprendre pourquoi. Quelles sont les barrières à l’entrée ? Quel est le rôle respectif de la politique et de la technologie ? Il est difficile d’obtenir une réponse convaincante en regardant seulement les Etats-Unis, mais la comparaison avec d’autres régions (l’Europe en particulier) est assez éclairante. Jusqu’aux années quatre-vingt-dix, les marchés américains étaient plus concurrentiels que les marchés européens. Aujourd’hui, cependant, beaucoup de marchés européens ont de moindres profits excessifs et de moindres barrières réglementaires à l’entrée. Deux secteurs américains illustrent très bien l’évolution de la concentration et des marges au cours du temps : les télécoms et le transport aérien.

Il y a vingt ans, l’accès à internet était moins cher aux Etats-Unis qu’en Europe. En 2018, le coût mensuel moyen d’un haut débit fixe est deux fois plus important aux Etats-Unis qu’en France ou en Allemagne. Le transport aérien est un autre secteur où les Etats-Unis ont reculé. La hausse de la concentration et des profits suit une vague de fusions controversées, notamment la fusion entre Delta et Northwest en 2008, celle entre United et Continental en 2010, celle entre Southwest et AirTran en 2011 ou encore celle entre American et US Airways en 2014. En Europe, au cours de la même période, la croissance des compagnies low cost a accentué la concurrence et poussé les prix à la baisse.

Les secteurs européens ne sont pas devenus moins chers et plus concurrentiels par hasard. Dans tous les cas que j’ai étudiés, il y a eu une action significative de la part des autorités, par exemple le retrait d’une barrière à l’entrée ou une action antitrust. Le secteur des télécoms français, par exemple, était en oligopole avec trois opérateurs historiques qui recouraient à un lobbying intense pour empêcher l’entrée d’un nouveau concurrent. L’oligopole fut remis en cause en 2011 lorsqu’un quatrième opérateur obtint une licence et les prix chutèrent de moitié dans les deux années suivantes.

Ces résultats sont surprenants. L’Europe, avec sa tradition de protection de champions nationaux, n’est pas le lieu où nous nous serions attendus à voir la concurrence s’intensifier. Les Etats-Unis, avec sa tradition de marchés libres, n’est pas le lieu où nous nous serions attendus à voir la concurrence refluer. Comment pouvons-nous alors expliquer ces évolutions ?

L’explication théorique pour l’Europe est en fait relativement simple. Quand les institutions du Marché unique de l’UE ont été conçues au début des années quatre-vingt-dix, les Etats-membres craignaient que chacun essaierait d’imposer son agenda domestique aux régulateurs communs. Gutiérrez et moi montrons que l’équilibre de Nash du jeu de la conception de la réglementation se déroule différemment au niveau de l’UE qu’au niveau national. Au niveau national, les politiciens jouissent de la possibilité d’influencer les régulateurs. Au niveau de l’UE, cependant, ils s’inquiètent de l’influence des autres Etats-membres. Par conséquent, les Etats-membres se sont accordés pour donner aux institutions européennes davantage d’indépendance qu’ils n’en donnent aux institutions nationales. C’est pourquoi l’Europe a fini avec la banque centrale et l’agence antitrust les plus indépendantes au monde. Au cours des vingt années suivantes, la logique du marché unique a peu à peu poussé l’Europe vers des marchés plus libres et plus concurrentiels.

Comprendre comment les marchés américains sont devenus moins concurrentiels est plus compliqué. Il y a plein d’explications possibles. Une partie de l’accroissement de la concentration s’explique par l’accroissement des rendements des actifs immatériels, comme Crouzet et Eberly l’expliquent. Le test crucial tient à la relation entre croissance de la productivité et concentration. Matias Covarrubias, Gutiérrez et moi constatons une corrélation positive entre changements de la concentration et croissance de la productivité dans les années quatre-vingt-dix. Cela suggère que la concentration était soit bénigne, soit le prix à payer pour atteindre une plus forte efficacité. Cependant, la corrélation est devenue négative dans les années deux mille, suggérant une plus forte prévalence de recherche de rentes. Malheureusement, c’est là où le manque de données (…) crée des défis empiriques. Il y a aussi des questions économétriques épineuses quand nous utilisons des données granulaires pour tester cette relation. Il faut reconnaître que nous n’avons pas de certitude ici.

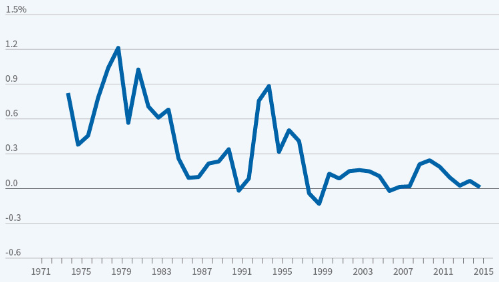

Deux tendances qui sont spécifiques aux Etats-Unis dans les années deux mille nous aident à faire la lumière sur cette question. L’une est ce que Gutiérrez et moi avons qualifié d’échec de libre entrée. Quand les profits augmentent dans un secteur, de nouvelles entreprises doivent entrer dans ce dernier. Quand les profits diminuent, les firmes en place devraient sortir du marché ou se lancer dans des opérations de consolidation. La théorie économique prédit un surcroît d’entrées dans les secteurs où les valeurs boursières sont fortes relativement aux valeurs comptables, un indicateur connu sous le nom de ratio q de Tobin. Intuitivement, le q de Tobin mesure les profits attendus (tels qu’ils sont valorisés par le marché) par unité de coûts d’entrée (les valeurs comptables). Nous étudions si le nombre d’entreprises augmente dans les secteurs où le q de Tobin est élevé et diminue dans les secteurs où il est faible.

Le graphique 2 montre que la libre entrée était bien portante des années soixante aux années quatre-vingt-dix. L’élasticité positive implique, lorsque le q de Tobin médian d’un secteur augmentait, plus les entreprises entraient dans ce secteur. En l’occurrence, une hausse du q de Tobin d’une unité dans un secteur, par exemple de 1 à 2, coïncida avec une hausse du nombre d’entreprises dans ce secteur d’environ 10 % au cours des deux années suivantes. Ce qui est cohérent avec la libre entrée, les entreprises avaient tendance à entrer dans les secteurs à q élevé et à sortir des secteurs avec un faible q.

GRAPHIQUE 2 Élasticité des entrées nettes vis-à-vis du q de Tobin

Mais ce n’est plus le cas. L’élasticité a été quasiment nulle depuis 2000. Cela remet en cause le mécanisme de rééquilibrage fondamental qui était au cœur du raisonnement que développait l’école de Chicago pour conclure qu’il ne fallait pas s’inquiéter à propos de la domination de marché par une poignée de grandes entreprises. Si la libre entrée échoue, le raisonnement du laissez-faire s'écroule.

L’autre tendance frappante aux Etats-Unis durant les années deux mille est l’essor du lobbying de la part des entreprises et des contributions au financement des campagnes. Le lobbying et la réglementation peuvent expliquer l’échec de la libre entrée si les entreprises en place les utilisent pour altérer les règles du jeu. Les entreprises en place peuvent, par exemple, influencer l’application de la législation antitrust et de la législation relative aux fusions-acquisitions aussi bien que des réglementations allant des brevets et de la protection copyright à la réglementation financière, en passant par les accords de non-concurrence, la certification professionnelle et les échappatoires fiscales. Ce qui est cohérent avec ces idées, nous constatons que l’élasticité de l’entrée des entreprises au q de Tobin a davantage diminué dans les secteurs qui ont connu les plus forts accroissements de lobbying et de réglementations.

L’échec de la libre entrée a des implications négatives pour la productivité, l’égalité et le bien-être en général. Si le capital reste piégé dans les secteurs déclinants et n'est pas alloué vers les secteurs prometteurs, l’économie en souffre : la croissance de la productivité est faible, les salaires stagnent et les niveaux de vie peinent à s’améliorer. »

Thomas Philippon, « The economics and politics of market concentration », in NBER Reporter, n° 2019:4. Traduit par Martin Anota

aller plus loin...

« Les marchés européens sont plus concurrentiels que les marchés américains »

« Firmes stars, étoiles montantes ? »

« Faut-il s’inquiéter de la concentration des marchés aux Etats-Unis ? »

« Pourquoi les barrières à l’entrée se sont-elles renforcées aux Etats-Unis ? »

mardi 17 décembre 2019

« Le manque de concurrence a fait perdre 1.250 milliards de dollars aux travailleurs américains »

Par Martin Anota le mardi 17 décembre 2019, 16:00

« (…) ProMarket : Votre livre The Great Reversal est une étude minutieuse de la concentration des secteurs et des implications d’un pouvoir de marché des entreprises incontrôlé, mais il débute avec une question simple : "Pourquoi les forfaits de portables sont-ils bien plus chers aux Etats-Unis qu’en Europe ?"

Philippon : Ce fut l’une des questions fondamentales auxquelles je voulais répondre. Il y a beaucoup de biens et services qui étaient habituellement bien moins chers aux Etats-Unis qu’en Europe. Ils sont tous maintenant bien plus chers aux Etats-Unis. Je voulais comprendre ce qui s’est passé. Il y a une très bonne étude à ce sujet réalisée par Luigi Zingales et Mara Faccio. Ils ont utilisé données différentes de celles que je regardais initialement, mais ils sont arrivés à la même conclusion, à savoir que les prix sont 2,5 fois plus élevés aux Etats-Unis qu’en Europe. C’est fou. Ce n’est pas une différence de 10 % ; c’est une différence de 150 %. Ce n’est pas quelque chose que vous pouvez expliquer en disant que les Etats-Unis sont un peu plus riches et donc que certains biens et services sont plus chers ici.

Initialement, je ne pensais pas qu’il s’agissait d’un schéma large, systémique. Je pensais juste avoir trouvé quelques exemples. Mais ce que j’ai découvert à travers mes travaux avec Germán Gutiérrez, c’est qu’il y en a beaucoup. Il ne s’agit pas seulement des forfaits de portables. Les billets d’avions étaient aussi auparavant bien moins chers et ils sont aujourd’hui bien plus chers aux Etats-Unis qu’en Europe. Il s’agit aussi des télécommunications, un domaine où les Etats-Unis sont particulièrement mauvais : le coût du haut débit est de 68 dollars par mois en moyenne aux Etats-Unis. En France, il est de 31 dollars. En Allemagne et au Japon, il est de 35 dollars ; en Corée du Sud, il est de 32 dollars. Je trouve cela choquant. Je me souviens très bien lorsque j’étais venu aux Etats-Unis en 1999 et qu’il y était bien moins cher de s’y connecter à Internet qu’en Europe.

ProMarket : Qu’est-ce qui explique ce changement ?

Philippon : J’ai une immense dette envers la Brookings et Janice Eberly, qui m’avait demandé d’écrire un article sur les raisons pour lesquelles l’investissement des entreprises aux Etats-Unis a été très faible. C’est une énigme, car les taux de profit aux Etats-Unis sont extrêmement élevés, si bien que les entreprises gagnent beaucoup d’argent. Les taux d’actualisation sont très faibles, donc elles peuvent emprunter à de faibles coûts. Les cours boursiers reflètent cela en atteignant des niveaux très élevés. Ces facteurs tendent habituellement à prédire un investissement élevé, mais nous n’avons pas connu d’investissement élevé.

Il y a deux explications pour ce qui se passe. La première est qu’il y a davantage d’investissement dans les actifs immatériels, or un tel investissement est difficile à mesurer correctement, et cela explique effectivement une partie de la différence. Mais en fait c’est surtout parce que, ce que nous voyons dans les données, c’est que les profits élevés reflètent essentiellement des rentes de monopole. Une fois que vous comprenez cela, alors l’énigme disparaît. Par définition, un monopoleur réalise un taux de profit élevé, mais il ne désire pas accroître ses capacités de production. Cela peut facilement expliquer les fortes valorisations boursières, les flux de trésorerie élevés et le faible investissement. Alors ce qu’il faut alors se demander, c’est pourquoi il y a plus de pouvoir de monopole aujourd’hui qu’il y a vingt ans.

ProMarket : Les Etats-Unis, écrivez-vous, étaient d'habitude présentés comme un modèle pour les marchés concurrentiels, tandis que l’Europe était perçue comme désespérément monopolistique. Quand est-ce que cette relation a commencé à s’inverser ?

Philippon : Les Etats-Unis avaient des marchés hautement concurrentiels à la fin des années quatre-vingt-dix, mais ils allèrent dans la mauvaise direction, tandis que l’Europe partit d’un faible niveau de concurrence, mais alla dans la bonne direction. Quelque part à la fin des années deux mille, leurs niveaux de concurrence convergèrent. Aujourd’hui, beaucoup de marchés sont en fait plus chers et moins concurrentiels aux Etats-Unis qu’en Europe. D’où le "grand renversement" (great reversal).

L’ironie est que toutes les bonnes idées qui contribuèrent à libéraliser les marchés européens sont venues des Etats-Unis. La raison pour laquelle les billets d’avion sont moins chers en Europe est parce qu’il y a des compagnies low-cost en concurrence avec les vieilles grandes compagnies. Ces compagnies low-cost se sont en partie inspirées de ce que le Southwest faisait aux Etats-Unis. Les réglementations européennes en vigueur sur les marchés des biens se sont toutes inspirées des Etats-Unis à la fin des années quatre-vingt-dix. C’est pourquoi nous avons de moindres barrières à l’entrée et pourquoi le nombre de jours qu’il faut pour ouvrir une entreprise en Europe est passé de 30 à 5. Il y a vingt ans, les Etats-Unis étaient bien en avance sur l’Europe à ce niveau. C’est ainsi que nous avons rendu les marchés européens plus concurrentiels : essentiellement en nous inspirant de ce qui marchait aux Etats-Unis et en le reproduisant. L’idée que les marchés libres sont bons, que vous devez avoir de la concurrence, ce ne sont pas des idées propres à l’Europe. Elles viennent des Etats-Unis. (...)

ProMarket : Vous identifiez la période où cours de laquelle l’Europe et les Etats-Unis se sont "inversés" au début des années deux mille. D’autres estiment que la concurrence américaine a commencé à baisser à partir des années quatre-vingt.

Philippon : Je ne suis pas d’accord avec ceux qui affirment que les Etats-Unis ont commencé à perdre en concurrence dans les années quatre-vingt ou même quatre-vingt-dix. Je pense qu’ils se trompent, parce qu’ils oublient que la concentration n’est pas toujours une mauvaise chose. Vous pouvez avoir une bonne concentration et une mauvaise concentration. Nous trouvons de bons exemples de bonne concentration, où vous avez des marchés plus concurrentiels et des firmes meneuses plus efficaces qui accroissent leurs parts de marché. Si vous avez plus de concurrence, alors les producteurs les plus faibles sont évincés du marché et vous vous retrouvez avec un marché à la fois plus concurrentiel et plus concentré. C’est ce qui s’est passé dans une large mesure aux Etats-Unis dans les années quatre-vingt et quatre-vingt-dix. C’était un bon type de concentration.

ProMarket : Ce genre de raisonnement qui permit ce que vous appelez la bonne concentration n’est-il pas similaire au raisonnement qui permit à la mauvaise concentration de prendre le dessus ? N’est-ce pas la "bonne concentration" qui est à l’origine du relâchement du droit antitrust qui conduisit à la "mauvaise" concentration ?

Philippon : Oui. Je me réfère aux marchés effectifs, pas à l’idéologie sous-jacente. Pour le marché concret, je pense que le problème aux Etats-Unis commence à la fin des années quatre-vingt-dix ou au début des années deux mille. Avant, nous avions essentiellement une bonne concentration et aussi une régulation antitrust puissante. Le procès contre AT&T s’est déroulé dans les années quatre-vingt, sous Reagan, et il constitue le plus grand procès antitrust de l’histoire. A la fin des années quatre-vingt-dix, vous avez eu le procès Microsoft. Il n’est pas exact que la mise en application du droit antitrust était très lâche. (…)

Si vous regardez le cœur du raisonnement de l’école de Chicago, vous trouvez l’idée que les hauts profits attirent toujours une nouvelle concurrence. En conséquence, vous n’avez jamais à vous inquiéter du pouvoir de monopole. (…) Vous n’avez pas à vous inquiéter d’un éventuel excès de pouvoir de marché de la part des entreprises si celui-ci mène à des profits excessifs, parce que de nouveaux rivaux vont alors entrer sur le marché. Ces entrées vont maintenir le système à l’équilibre. C’est cela l’idée clé. Le problème est que les membres de l’école de Chicago ont misé sur cette idée sans prendre le temps de se demander si elle était vraiment exacte. Ce que les données montrent, c’est qu’elle était peut-être exacte dans les années soixante-dix et quatre-vingt, quand ils faisaient ce raisonnement, mais qu’elle ne l’est plus aujourd’hui. Depuis 2000, la corrélation entre l’entrée et le profit au niveau sectoriel a cessée de devenir positive pour devenir essentiellement nulle pendant les 15 dernières années. Dans un monde où les entrées n’équilibrent pas les profits excessifs, alors la vision de l’école de Chicago selon laquelle vous n’avez pas à vous inquiéter du pouvoir de marché des entreprises devient inexacte.

L’idée selon laquelle la libre entrée va toujours équilibrer le système était très naïve, je pense. D’un autre côté, l’une des raisons pour lesquelles nous n’avons pas de libre entrée dans plusieurs marchés américains aujourd’hui tient aux réglementations gouvernementales. L’école de Chicago a toujours fait part de ses craintes à l’idée que les politiciens et les régulateurs soient capturés par les lobbyistes. C’est sur ce point que l’école de Chicago a raison selon moi. (...)

ProMarket : Vous avez calculé que le manque de concurrence a appauvri les travailleurs américains de 1.250 milliards de dollars de revenu. Comment êtes-vous parvenu à ce chiffre ?

Philippon : Supposez que vous reveniez au niveau de concurrence que vous aviez aux Etats-Unis en 2000. En cherchant quel impact cela aurait directement sur les prix aujourd’hui, mon estimation est que cela aurait économisé environ 300 dollars par mois pour le ménage américain médian. Etant donné que beaucoup de ménages déclarent ne pas être capables de faire face à une facture inattendue de 500 dollars, c’est énorme. En termes d’économie directe par an pour l’ensemble des ménages américains, c’est quelque chose comme 500 à 600 milliards de dollars d’économie directe chaque année, juste en raison de prix plus faibles. Une fois que vous prenez en compte qu’un surcroît de concurrence et de moindres prix mènent à un surcroît d’activité, d’emploi et d’investissement, alors cela se traduit par une perte du PIB privé équivalente à 1.000 milliards de dollars. Bien sûr, ce ne serait pas neutre. Des prix plus faibles signifient que les profits seraient plus faibles, d’environ 250 milliards de dollars et que le revenu du travail croîtrait de 1.250 milliards de dollars. C’est beaucoup d’argent. (...)

ProMarket : vous consacrez une grande partie du livre à l’utilisation du lobbying par les entreprises en vue d’obtenir des régulations qui protègent leurs rentes de monopole. Quelles tendances que vous décrivez (le faible investissement, les prix élevés, la concentration croissante) résultent du lobbying des firmes contre la concurrence ?

Philippon : Je pense que cela en explique une grande partie, mais il est très difficile d’avoir une estimation précise dans la mesure où les données sur le lobbying ne sont pas très bonnes. Ce qui me frappe est que même avec les données dont nous disposons, les effets du lobbying sont toujours très manifestes au niveau étatique, au niveau fédéral, au niveau sectoriel : lorsque vous voyez une forte poussée du lobbying, les entreprises réussissent à obtenir les régulations qu’elles veulent ou à éviter des poursuites antitrust. Plus nous peaufinons les données, plus c’est cohérent avec cette idée. Mais, bien sûr, les entreprises en place peuvent aussi utiliser des stratégies qui limitent la concurrence sans recourir au lobbying : elles peuvent adopter des stratégies prédatrices ou menacer d’utiliser des stratégies prédatrices, elles peuvent acheter des concurrents naissants, etc. (...)

ProMarket : Vous semblez soutenir la déréglementation. Vous écrivez que la déréglementation stimule la créativité et l’innovation et accroît la demande de travailleurs qualifiés. Beaucoup affirmeraient que la déréglementation a aussi contribué à l’essor de la concentration et du pouvoir de marché.

Philippon : Cela dépend de ce que vous avez en tête quand vous parlez de réglementation et de déréglementation. Vous devez toujours considérer les choses en termes de bonnes et de mauvaises régulations. "Nous devons davantage réglementer", cela n’existe pas. Nous devons bien réglementer. Comme principe, toute nouvelle réglementation considérée aux Etats-Unis devrait être jugée en partie selon la question fondamentale suivante : "va-t-elle créer des barrières à l’entrée ?" Quand vous arrivez au point où le marché est aussi dominé par les grosses firmes, cela devrait être une priorité. Cela signifie qu’à certains moments vous allez vouloir tuer certaines réglementations et qu’à d’autres moments vous voudrez avoir une certaine réglementation à cause de cela. Je vais vous donner un exemple. Imaginons que vous forciez les banquez à avoir une interface que les gens pourraient utiliser pour partager leurs données bancaires. C’est une réglementation qui accroîtrait l’entrée parce que vous permettrez aux entreprises de fintech de concurrencer les banques pour fournir des conseils aux consommateurs. (...) »

Thomas Philippon, « The lack of competition has deprived American workers of $1.25 trillion of income », entretien in ProMarket, 9 décembre 2019. Traduit par Martin Anota

aller plus loin...

« Les marchés européens sont plus concurrentiels que les marchés américains »

« Firmes stars, étoiles montantes ? »

« Faut-il s’inquiéter de la concentration des marchés aux Etats-Unis ? »

« Pourquoi les barrières à l’entrée se sont-elles renforcées aux Etats-Unis ? »

« billets précédents - page 1 de 4