« En mars 1968, l’article “The role of monetary policy” de Milton Friedman (reprenant son allocution présidentielle à l’American Economic Association) a été publié dans l’American Economic Review.. Cinquante ans après, les économistes se penchent à nouveau sur ce célèbre article.

Gregory Mankiw et Ricardo Reis soulignent que les anticipations, le long terme, la courbe de Phillips et les potentiel et limites de la politique monétaire sont toujours des sujets de recherche très actifs. Dans un futur proche, il se pourrait que la faible croissance économique que l’on a connue depuis la récession de 2008-2009 amène à un réexamen de l’hypothèse du taux de chômage naturel de Friedman. A ce point, l’explication la plus simple est que cette stagnation est due à un ralentissement de la productivité qui n’est pas lié au cycle d’affaires. Il se peut aussi, cependant, que cette faible croissance contredise la vision classique du long terme de Friedman, que ce soit via les effets d’hystérèse ou via l’insuffisance chronique de demande globale. De futurs travaux peuvent très bien confirmer la vision de Friedman et se tourner vers la formation des anticipations pour une meilleure compréhension de la courbe de Phillips, visant à un meilleur modèle de référence de ce qui pourrait remplacer tant les anticipations adaptatives que les anticipations rationnelles. Mankiw et Reis affirment que le rôle de la politique monétaire évolue actuellement et s’est éloigné des sujets que Friedman a développés dans son allocution présidentielle. L’avenir promet des progrès dans quatre domaines : l’interaction entre les politiques budgétaire et monétaire, le rôle des réserves bancaires, les taux d’intérêt proches de zéro et la stabilité financière.

Olivier Blanchard s’est demandé si nous devons rejeter l’hypothèse de taux de chômage naturel. L’hypothèse a certes été controversée à l’époque, mais elle a vite été acceptée par une majorité et constitue le paradigme dominant en macroéconomie depuis lors. Elle est partie intégrante dans la réflexion et les modèles utilisés par les banques centrales et elle fonde le cadre du ciblage d’inflation qu’utilisent la plupart des banques centrales aujourd’hui. Récemment, la crise financière mondiale et la récession qui en a résulté ont alimenté les débats autour du réalisme de cette hypothèse, et ce pour deux raisons. Premièrement, le niveau de la production apparaît avoir été irrévocablement affecté par la crise et la récession qui l’a suivie. Deuxièmement, à l’inverse de l’hypothèse accélérationniste, un chômage élevé n’entraîne pas une inflation de plus en plus faible, mais juste une inflation faible. Blanchard considère les preuves macroéconomiques et microéconomiques comme suggestives, mais pas concluantes, pour rejeter l’hypothèse du taux naturel. Les décideurs politiques doivent garder l’hypothèse de taux naturel comme leur hypothèse nulle, mais aussi garder l’esprit ouvert et considérer des alternatives.

Robert Hall et Thomas Sargent affirment que l’effet de court terme de l’allocution a été d’inciter beaucoup à vérifier l’affirmation de Friedman selon laquelle non seulement l’inflation anticipée importe pour l’inflation courante, elle importe aussi point par point dans la détermination de l’inflation courante. Dans la version alors existante de la courbe de Phillips, comme Friedman l’a souligné, la courbe de Phillips de long terme est devenue verticale et le taux de chômage (…) reste insensible aux choix de la banque centrale en matière d’inflation. A plus long terme, l’hypothèse de Friedman d’un déplacement point par point de la courbe de Phillips a été acceptée par de plus en plus d’économistes. L’idée plus générale que les variables réelles telles que le chômage, l’emploi et la production sont insensibles au régime monétaire commença à être acceptée et cette idée s’est généralisée au point de remplacer le concept de neutralité monétaire. Hall et Sargent croient que le principal message de Friedman, en l’occurrence l’hypothèse d’invariance à propos des résultats de long terme, a prévalu au cours du dernier demi-siècle parce qu’elle était confortée par des preuves relatives à plusieurs économies sur plusieurs années. Les travaux ultérieurs ont modifié les idées de Friedman relatives aux effets transitoires et n’ont pas été cléments avec la courbe de Phillips, mais Hall et Sargent affirment que l’hypothèse d’invariance a tenu bien, même si la courbe de Phillips n’a gardé la même place en tant qu’équation structurelle dans les modèles macroéconomiques.

John Cochrane a publié un long billet discutant de la contribution de Friedman, qui selon lui aurait pu avoir pour sous-titre « neutralité et non-neutralité » : la politique monétaire est neutre à long terme, mais pas à court terme. Mais ce que Friedman, l’empiriste, aurait dit aujourd’hui, après avoir vu le comportement sauvage de la vélocité de la monnaie lors des années 1980 et la stabilité surprenant de l’inflation à la borne zéro dans nos rétroviseurs ? Que penserait-il de l’idée de John Taylor selon laquelle varier les taux d’intérêt plus amplement que l’inflation, tout en restant dans le cadre qu’il posa, stabilise le niveau des prix en théorie et, apparemment, dans la pratique des années 1980 ? Cochrane pense que, malgré les événements ultérieurs, la conception de Friedman de la politique monétaire a eu une influence durable, même bien davantage que sa conception de la courbe de Phillips. L’idée selon laquelle les banques centrales sont toutes-puissantes, non seulement pour contrôler l’inflation, mais aussi en tant que principal instrument de gestion macroéconomique, est commune aujourd’hui, mais Friedman nous rappelle qu’elle ne l’a pas toujours été. Aujourd’hui, la Fed est créditée ou accusée d’être la principale cause derrière les variations des taux d’intérêt à long terme, des taux de change, des cours boursiers, des prix des matières premières et des prix de l’immobilier ; en outre, certains à l’intérieur et à l’extérieur de la Fed commencent à observer le taux d’activité, les inégalités et d’autres maux. (…) Cochrane pense que nous devrions prendre du recul et prendre comprendre que la Fed est bien moins puissante que ne le suggèrent tous ces commentaires.

Edward Nelson discute de sept erreurs commises à propos de l’article de Friedman : (1) "The Role of Monetary Policy" n’aurait pas été la première déclaration publique où Friedman a évoqué l’hypothèse du taux naturel ; (2) la courbe de Phillips à la Friedman-Phelps aurait déjà été présente dans l’analyse de Samuelson et Solow (1960) ; (3) la spécification de la courbe de Phillips de Friedman se baserait sur la concurrence parfaite et non sur les rigidités nominales ; (4) Le récit que Friedman (1968) a fait de la politique monétaire lors de la Grande Dépression contredirait celui de l’Histoire monétaire ; (5) Friedman (1968) aurait déclaré qu’une expansion monétaire maintiendrait le taux de chômage et le taux d’intérêt réel sous leurs taux naturels au cours des deux décennies suivantes ; (6) la borne inférieure zéro sur les taux d’intérêt nominaux invaliderait l’hypothèse de taux naturel ; (7) ce qu’a dit Friedman (1968) sur l’ancrage du taux d’intérêt aurait été réfuté par la révolution des anticipations rationnelles. Nelson explique pourquoi ces idées sont fausses et infère les aspects clés de l’analyse sous-jacente de Friedman (1968).

Scott Sumner attire l’attention sur la deuxième note de base de page dans l’article de Friedman de 1968, où il croit y voir Friedman anticiper les raisons pour lesquelles les cibles d’inflation ou du PIB nominal peuvent être supérieurs au ciblage de la monnaie. Sumner a publié un autre billet où il explique pourquoi remplacer le ciblage d’inflation par le ciblage du PIB nominal résoudrait de nombreux problèmes. La relation empirique que Friedman s’est rompue une décennie après la publication de son article : les récessions n’ont plus été précédées par des ralentissements brutaux de la croissance de M2. Sumner affirme que la rupture dans la relation empirique qui a amené Friedman à préconiser le ciblage de l’offre de monnaie contribue à expliquer pourquoi, plus tard dans sa vie, il a soutenu l’approche du ciblage d’inflation de Greenspan : Friedman était un pragmatique, donc lorsque les faits changeaient, il changeait d’avis.

David Glasner note que l’interprétation standard du raisonnement de Friedman est la suivante : puisque les tentatives visant à accroître la production et l’emploi par l’expansion monétaire sont vaines, la meilleure politique qu’une autorité monétaire doit poursuivre doit être une politique stable et prévisible qui maintient l’économie au plus proche de sa trajectoire de croissance optimale à long terme telle qu’elle est déterminée par des facteurs réels. Donc, la meilleure politique consisterait à trouver une règle claire et prévisible pour imposer aux autorités monétaires le comportement qu’elles doivent adopter, pour empêcher qu’une mauvaise gestion monétaire ne devienne par inadvertance une force déstabilisatrice écartant l’économie de sa trajectoire de croissance optimale. Au cours des cinquante ans qui ont suivi l’allocution de Friedman, ce message a été repris par les économistes monétaires et les banques centrales, ce qui a amené à un large consensus en faveur du ciblage d’inflation et, désormais, d’une cible d’inflation annuelle de 2 %. Mais cette interprétation, que Friedman a lui-même fait de son propre raisonnement, ne découle en fait pas de l’idée selon laquelle l’expansion monétaire ne peut affecter la trajectoire de croissance d’équilibre à long terme d’une économie. L’idée de la neutralité monétaire est un pur exercice de statique comparative, qui nous enseigne quelque chose, mais pas autant que Friedman et ses successeurs le pensaient. »

Silvia Merler, « Milton Friedman’s "The role of monetary policy" – 50 years later », in Bruegel (blog), 3 avril 2018. Traduit par Martin Anota

aller plus loin...

« Quel est l’héritage du discours présidentiel de Friedman ? »

« Le taux de chômage naturel, un concept suranné »

Tag - Bruegel

mardi 3 avril 2018

Le discours présidentiel de Friedman, 50 ans après

Par Martin Anota le mardi 3 avril 2018, 17:21 - Monnaie et finance

lundi 19 mars 2018

Que pensent les économistes des droits de douane américains sur l’acier et l’aluminium ?

Par Martin Anota le lundi 19 mars 2018, 15:00

« L’administration américaine a annoncé qu’elle envisageait d’instaurer des tarifs douaniers (de 25 %) sur l’acier et (de 10 %) sur l’aluminium, soi-disant pour des raisons de sécurité nationale. Nous passons en revue ce que les économistes ont pu dire sur ce bouleversement dans la politique commerciale américaine.

Chad Brown pense que ce genre de protection a des répercussions économiques et institutionnelles considérables et généralisées, pour diverses raisons. Premièrement, il réduira un montant significatif d’importations. Les nouveaux tarifs douaniers accroîtront probablement les coûts pour les constructeurs automobiles, les fabricants de conserves, les projets d’infrastructures et même l’industrie de la défense. Deuxièmement, les Etats-Unis n’ont pas déclenché de protection dans le cadre de la loi de la sécurité nationale depuis plus de 30 ans ; Reagan est le dernier à avoir imposé des restrictions dans le cadre de cette loi en 1986. L’instauration de tarifs douaniers sur l’acier et l’aluminium peut amener beaucoup à affirmer que le commerce fait peser d’autres menaces sur la sécurité nationale. Troisièmement, Brown pense que l’enquête amorcée dans le cadre de cette loi n’a pas été transparente (…). Quatrièmement, Brown affirme que la loi accorde au Président la discrétion incroyable de décider unilatéralement de la taille et de la forme de la restriction commerciale aussi bien que de sa durée. Cinquièmement, même si l’OMC permet aux pays d’imposer des restrictions quand la sécurité nationale est menacée, utiliser ce prétexte menace le système commercial basé sur des règles. (...)

Jared Bernstein dit qu’il est certain que les tarifs douaniers vont faire plus de mal que de bien, mais il affirme que cela ne signifie pas qu’il n’y a pas de problème. Il cite un article du Washington Post décrivant les impressionnants gains de productivité dans la production d’acier et se demande alors pourquoi les Etats-Unis, si ces derniers sont si productifs dans l’acier, présentent un tel déséquilibre persistant dans ce secteur. Il se peut que les gains de productivité des autres pays dans la production d’acier aient été plus grands ou que leurs coûts du travail soient plus faibles, mais, du moins dans l’industrie manufacturière dans son ensemble, il ne semble pas que ce soit le cas : les coûts unitaires du travail des Etats-Unis, sur une base dollars, sont inférieurs à ceux de la plupart des partenaires à l’échange, à la fois en niveaux et en termes de croissance. Bernstein pense qu’au cœur du problème, il pourrait y avoir l’énorme contribution de la Chine à l’excès de capacité mondiale, qui neutralise les gains de productivité. (...)

Noah Smith pense que les tarifs douaniers ne sont généralement pas une bonne façon de promouvoir l’industrie domestique. Ils encouragent les producteurs américains à se focaliser sur le marché captif local au lieu de trouver des façons de faire face à la concurrence rude et agité qui s’exerce au niveau mondial. Si les consommateurs américains sont forcés de n’utiliser que les produits domestiques, l’acier et l’aluminium américains risquent de finir par apparaître comme des produits de mauvaise qualité. Et si les métaux sont plus chers, cela risque non pas d’aider mais d’endommager l’industrie. Les défenseurs des tarifs douaniers affirment que l’acier et l’aluminium sont importants pour la défense nationale, mais les constructeurs de navires militaires vont devoir payer des métaux plus chers, notamment les fabricants de tanks, d’avions, d’armes et d’autres équipements cruciaux de défense. Les tarifs douaniers ne vont pas non plus ramener de bons emplois dans les usines d’acier et d’aluminium : depuis 1990, la production de métaux aux Etats-Unis est restée assez constante, mais le nombre de personnes employées dans ce secteur a régulièrement chuté, sous l’effet du progrès technique. Donc Smith pense que les Etats-Unis se sont infligé une sévère blessure en adoptant des tarifs douaniers sur les métaux.

Jeffrey Sachs affirme que cela pourrait être le premier coup tiré dans une guerre commerciale insensée et destructive. Qu’importe ce que les producteurs américains d’acier gagneront d’une guerre commerciale, ce gain sera moindre que les pertes que connaîtront les utilisateurs d’acier et les consommateurs, notamment en raison des coûts sociaux associés à la protection d’emplois non compétitifs. Mais l’essoufflement du marché boursier reflète la possibilité de quelque chose de plus désastreux : le glissement vers une guerre commerciale mondiale dans laquelle tous les pays, notamment les Etats-Unis, seraient perdants. L’économie mondiale a déjà connu un tel scénario par le passé : les guerres commerciales du début des années trente contribuèrent à déclencher, puis aggraver et prolonger la Grande Dépression. Sachs croit que les mesures de Trump reposent sur trois erreurs. Premièrement, Trump pense que les Etats-Unis génèrent des déficits commerciaux avec des pays comme la Chine et l’Allemagne parce que les Etats-Unis se font flouer d’une façon ou d’une autre par ceux-ci. La vraie raison est que les Etats-Unis épargnent trop peu et consomment de trop. Deuxièmement, Trump pense que les barrières commerciales vont protéger les Etats-Unis, mais même si ces mesures peuvent temporairement protéger l’acier américain, elles ne vont pas protéger la société américaine. Troisièmement, Trump croit que les barrières commerciales américaines vont faire ployer la Chine et renforcer la domination économique et militaire des Etats-Unis, mais la Chine et l’Europe vont sûrement riposter.

Martin Wolf écrit dans le Financial Times que ces tarifs douaniers ne sont pas importants en soi, mais que le motif avancé pour les justifier, leur niveau et leur durée, la volonté de cibler les alliés proches et la déclaration du Président selon laquelle « les guerres commerciales sont bonnes et faciles à gagner » présagent un surcroît de protectionnisme. Cette action est susceptible de marquer le début de la fin de l’ordre commercial multilatéral fondé sur les règles que les Etats-Unis avaient eux-mêmes instauré. Un point crucial est que cette action ne vise pas la Chine, qui représente moins de 1 % des importations américaines d’acier. Ses victimes sont des amis et alliés : le Brésil, le Canada, l’Union européenne, le Japon et la Corée du Sud. Ce n’est pas non plus une mesure prise contre une certaine forme de commerce déloyal. C’est une politique purement protectionniste visant à sauver les vieilles industries. Pourtant, même en ce sens, la justification est bien fragile : la production américaine d’acier et d’aluminium stagne depuis plusieurs années. Si cette action fait réellement sens à Trump, qu’est-ce qui ne le fait pas ?

Brad DeLong pense qu’au final les consommateurs américains paieront pour les tarifs douaniers. De telles mesures protectionnistes vont affecter chaque secteur de l’industrie américaine d’une façon ou d’une autre et les industriels qui utilisent l’acier et l’aluminium comme intrants vont certainement répercuter sur leurs prix de vente une partie du surcroît de coûts qu’elles subiront. Donc, Trump a essentiellement proposé une nouvelle taxe sur les résidents américains, en l’occurrence les consommateurs et les industries exportatrices, et ce fardeau sera en grande partie supporté par ses propres partisans au cœur des Etats-Unis et dans la Rust Belt.

Dani Rodrik estime que plusieurs commentateurs ont réagi de façon excessive à la possibilité de tarifs douaniers en prédisant une "guerre commerciale", voire pire, mais la réalité est que les mesures commerciales de Trump, du moins celles qu’il a adoptées jusqu’à présent, ne représentent pas grand-chose. En l’occurrence, elles ne pèsent pas lourd, que ce soit en termes d’échelle et d’ampleur, par rapport aux mesures adoptées par l’administration de Ronald Reagan dans les années quatre-vingt. Les politiques de Trump violent l’esprit, si ce n’est la lettre, des accords commerciaux d’aujourd’hui, les restrictions commerciales de Reagan ont exploité les lacunes des accords alors en vigueur. Même si leur impact global reste limité, les restrictions commerciales de Trump ont une teneur plus unilatérale, directe. Une autre différence avec les mesures adoptées sous Reagan, c’est que nous vivons une étape plus avancée de la mondialisation que les problèmes qui l’ont accompagnée sont plus grands et que les forces du nationalisme et du nativisme sont probablement plus puissantes aujourd’hui qu’à toute autre époque depuis la fin de la Seconde Guerre mondiale. Alors que les politiques de Trump visent prétendument à restaurer de l’équité dans le commerce mondial, elles exacerbent ces problèmes plutôt qu’elles ne les améliorent. Un tel protectionnisme est un artifice, pas un programme sérieux pour la réforme commerciale. »

Silvia Merler, « Are we steel friends? », in Bruegel (blog), 12 mars 2018. Traduit par Martin Anota

dimanche 11 mars 2018

Les femmes sont encore bien sous-représentées parmi les professeurs d’économie

Par Martin Anota le dimanche 11 mars 2018, 12:00

« Une observation de la représentation des femmes dans les facultés d’économie les plus prestigieuses en Europe montre qu’il y a encore beaucoup de progrès à faire pour que ces dernières se rapprochent de l’égalité des sexes…

La question de l’équilibre entre les sexes en économie a reçu ces derniers temps beaucoup d’attention. (…) Malgré la forte sous-représentation des femmes en économie, nous pouvons faire (et nous avons fait) d’importants progrès dans ce sens. (…)

Dans le cadre de cette démarche, nous avons cherché avril dernier combien de femmes sont effectivement devenues professeures dans les départements d’économie les plus prestigieux des universités européennes. Pour ce faire, nous avons utilisé le Classement mondial des universités (…). Une analyse similaire a été faite par The Economist il y a quelques mois, portant sur la représentation des femmes dans le champ économique dans les universités européennes et américains. Nous avons pris les 20 universités européennes les plus prestigieuses dans le domaine de l’économie et de l’économétrie et nous avons vérifié combien de femmes étaient professeures dans les départements d’économie.

Cependant, il semble également important de vérifier la proportion de l’ensemble des personnels universitaires qui ne sont pas des professeurs titulaires (les professeurs assistants, les professeurs associés, les chargés d’enseignement et les maîtres de conférence, les lecteurs et les chercheurs) aussi bien que la proportion de femmes titulaires d’un doctorat. Cela nous donne une meilleure idée de la représentation du genre dans l’ensemble des parcours professionnels vers le professorat à plein temps dans les facultés d’économie. Nous avons alors contacté les départements d’économie en question pour confirmer les données.

Le pourcentage moyen d’étudiantes en doctorat dans les 20 plus grands départements d’économie en Europe s’élève à 35,13 %. Ce chiffre est inférieur à la moyenne de 47 % observée pour l’ensemble des domaines d’études dans l’Union européenne par She Figures (une étude sur les liens entre, d’une part, le genre et, d’autre part, la recherche et l’innovation publiée par la Commission européenne publiée tous les trois ans) pour les titulaires d’un doctorat en 2012 pour l’ensemble des disciplines.

La proportion de femmes dans l’ensemble des effectifs universitaires (les professeurs qui ne sont pas titulaires) est légèrement inférieure, puisque les femmes représentent 25,86 % de ceux-ci, tandis que la proportion de femmes qui travaillent parmi le personnel administratif dans les 20 plus grands départements d’économie s’élève à 79,41 %. Les hommes présents dans le personnel administratif travaillent principalement dans les TIC, tandis que les femmes tendent à entreprendre des tâches qui relèvent de la communication ou de la gestion de projets. Lorsque nous remontons les grades universitaires, la proportion de femmes passe d’un tiers au niveau doctoral à seulement un huitième au niveau des professeurs. Les femmes ne représentent en moyenne que 12,87 % des professeurs titulaires.

Ces chiffres sont tout à fait similaires à ceux obtenus par les diverses études réalisées autour des facultés d’économie, notamment celle réalisée aux Etats-Unis par l’American Economic Association, qui a constaté que seulement 23,5 % des personnels universitaires (titulaires et assistants) sont des femmes. Par grade, les femmes représentent 15 % de l’ensemble des professeurs titulaires dans les départements d’économie et 31 % des personnels de facultés d’économie au niveau des assistants. Bayer et Rouse (2016) sont allés plus loin dans leur analyse, en regardant au niveau des économistes minoritaires à l’université ; ils ont constaté que seulement 6,3 % des économistes titulaires ou assistants sont identifiés comme Afro-Américains ou Hispaniques, alors que ceux-ci représentent 30 % de l’ensemble de la population aux Etats-Unis. D’autres études montrent que les écarts entre les sexes parmi les taux d’obtention de postes permanents et de taux de promotion dans les facultés d’économie sont plus importants que ceux observés pour l’ensemble des sciences sociales ; Ginther et Kahn (2014) notaient par ailleurs l’existence d’un écart entre les sexes de 20 % dans l’obtention des postes permanents.

Comprendre quelles sont les raisons qui expliquent ces chiffres est la première chose à faire pour répondre au déséquilibre. Diane Coyle a récemment affirmé dans le Financial Times que l’on peut considérer le manque de modèles comme l’un des principaux facteurs contribuant à ce qu’une faible proportion de femmes désire débuter une carrière universitaire en économie. Plus les femmes économistes seront visibles, plus il y aura de femmes qui verront l’économie comme un plan de carrière réaliste, profitable, attractive et réalisable. Il y a toujours beaucoup de choses à faire de ce côté. »

Ariane Giraneza Birekeraho et Paola Maniga, « How many female economics professors in top European Universities? », in Bruegel (blog), 7 mars 2018. Traduit par Martin Anota

lundi 12 février 2018

Autour de la récente chute des cours boursiers

Par Martin Anota le lundi 12 février 2018, 19:00 - Monnaie et finance

« Les valeurs boursières ont chuté la semaine dernière, ce qui a amené beaucoup à se poser des questions et suscité des débats, notamment à propos des causes sous-jacentes. Nous passons en revue les avis des économistes sur la question...

John Cochrane a publié un long billet visant à expliquer les fluctuations boursières, où il examine en profondeur les prix d’actifs, le ratio cours sur dividende, la prime de risque et la volatilité. La question qui se pose est la suivante : est-ce que les taux d'intérêt réels de long terme augmentent enfin (et reviennent à ce qui rapproche de la norme historique) et, si oui, pourquoi ? La bonne nouvelle, affirme Cochrane, est que nous arrivons dans une période de plus forte croissance. Cela augmenterait la croissance réelle, avec une petite baisse des cours boursiers, mais avec aussi des rendements boursiers plus élevés et des rendements obligataires en hausse. Il y a aussi une mauvaise nouvelle : après avoir voté une réduction d’impôts qui va creuser les déficits (…), les meneurs du Congrès viennent de se mettre d’accord pour accroître les dépenses publiques de 200 milliards de dollars. Cochrane affirme qu’à un certain moment les marchés obligataires disent "non" et que les taux réels augmentent parce que la prime de risque augmente. La bonne nouvelle nous amène à anticiper une certaine inflation si l'on croit en la courbe de Phillips ; avec la mauvaise nouvelle, on peut s'attendre à une stagflation en raison de la situation budgétaire.

Tyler Cowen estime que le déclin des prix d’actifs peut être une bonne chose (...). Il affirme que ce niveau élevé des prix d’actifs reflète une réalité de la création de richesses, c’est-à-dire le fait qu’il y ait un déséquilibre entre la richesse mondiale et les moyens sûrs de transférer cette richesse dans le futur. Les marchés boursiers de Chine et de Russie ne sont pas sûrs et pas très bien développés et plusieurs autres pays émergents, comme la Turquie et le Brésil, ont été affaiblis par l’incertitude et les désordres politiques. Donc, en termes relatifs, les actifs de haute qualité, fortement liquides et habituellement sûrs sont devenus chers et nous nous retrouvons avec des price-earning ratios particulièrement élevés et des rendements négatifs sur les titres publics sûrs. Comme les rapports positifs se multiplient concernant l’économie américaine, les actifs sûrs peuvent devenir moins importants en tant que réserves de valeur relativement sûres et donc leur prix peut chuter. Cette dynamique des prix ne traduit pas forcément la présence de bulles mais, dans un monde où la richesse est créée plus rapidement que ne s’améliorent les institutions, elle peut signaler que la prime de risque est peut-être plus importante qu’on ne le pense.

Paul Krugman dit que, d’un côté, nous ne devrions pas supposer qu’il y a une bonne raison à l’origine de la chute du marché ; quand les cours boursiers se sont effondrés en 1987, il s’agissait d’une panique auto-réalisatrice. D’un autre côté, nous ne devons pas non plus supposer que la chute des cours boursiers nous dise grand-chose à propos des perspectives économiques futures ; le krach de 1987, par exemple, a été suivi par une croissance solide. Pourtant, les turbulences sur le marché doit nous amener à nous pencher plus sérieusement sur les perspectives économiques. S’il y a une nouvelle derrière la chute, c’est bien la publication du dernier rapport sur l’emploi, qui a montré une hausse, certes significative, mais pas énorme, des salaires. Krugman affirme que c’est une bonne nouvelle (elle suggère en effet que l’économie américaine est proche du plein emploi), mais cela signifie aussi que la croissance américaine ne pourra plus venir du retour des chômeurs à l’emploi. Il affirme que l’économie américaine risque certainement de voir sa croissance ralentir et que les analyses disponibles suggèrent que la croissance au cours de la prochaine décennie tournera autour de 1,5 % par an, soit la moitié de ce qu’avait promis Trump.

Matthew Klein, du Financial Times, se penche sur la crainte des marchés qu’une accélération de la croissance des salaires alimente l’inflation des prix à la consommation ou, tout du moins, que la Fed réagisse à une telle perspective en resserrant sa politique monétaire. Il affirme que les derniers chiffres ne valident pas pour l’heure ce que croient les participants du marché. Si l’on prend une moyenne sur six mois, il semble que la croissance des salaires ait ralenti depuis la seconde moitié de 2016. Il y a aussi des raisons qui nous amènent à douter que cette croissance des salaires puisse se traduire par une hausse des prix à la consommation : en général, ce sont surtout les personnes à faibles revenus qui tendent à davantage dépenser et à moins épargner, donc ceux qui s’inquiètent qu’une hausse des salaires puisse stimuler le pouvoir d’achat des consommateurs et éroder les marges doivent se focaliser sur les secteurs à faibles rémunérations, or la croissance salariale y a ralenti. Klein souligne aussi l’importance du secteur financier au regard de la croissance salariale. Il estime que ce serait ironique si les agents financiers se convainquaient de vendre leurs actions en raison de la publication d’une unique donnée, en l’occurrence une donnée qui a été perturbée par la hausse agressive de leurs propres rémunérations, une hausse qu’ils ont justifié par l’évolution du marché, elle-même en partie justifiée par la stabilité de l’inflation.

Stephen Williamson (…) pense qu’il n’y a pas réellement de signe d’excès inflationniste dans les données. Il y a, par contre, des signes que l’inflation et l’inflation anticipée sont très proches de ce qui est cohérent avec une cible d’inflation de 2 %, pour un futur indéfini. Il pense qu’il peut y avoir un risque en termes de décisions de politique monétaire, néanmoins, comme la Fed est aussi proche (…) d’atteindre ses objectifs. L’inflation est arrivée récemment, lorsque les taux d’intérêt nominaux ont augmenté. C’est cohérent avec la logique néo-fisherienne, celle selon laquelle il faut augmenter le taux d’intérêt nominal si l’on veut davantage d’inflation. Bien sûr, l’inflation était faible en 2014-2015 en partie en raison d’une chute du prix du pétrole brut. Néanmoins, certains ont affirmé que l’inflation ralentirait en conséquence des hausses du taux directeur de la Fed et ce n’est pas ce qui s’est passé. Le problème est que la Fed pourrait continuer d’accroître les taux d’intérêt alors même que ce n’est pas nécessaire, ce qui va amener l’inflation à dépasser sa cible, ce qui incitera en retour la Fed à relever davantage ses taux et continuera d’éloigner l’inflation de sa cible. Heureusement, c’est une route politiquement difficile à emprunter, donc il doute que cela arrive.

Dambisa Moyo affirme que, malgré la récente chute des valeurs boursières, l'atmosphère haussière qui soutient les actions reste déconnectée de la réalité et reste sourde aux réserves exprimées par les dirigeants politiques, tandis que le marché évalue mal les défis structurels, en particulier l’endettement mondial croissant et insoutenable et la piètre perspective budgétaire, notamment aux Etats-Unis, où le prix de cette reprise est une dette croissante. En 2018, les chefs d’entreprises et les participants de marché doivent garder en tête (…) que nous nous rapprochons de la date où il faudra payer la facture pour la reprise actuelle. Les fluctuations qu’ont connues les marchés des capitaux ces derniers jours suggèrent qu’ils prennent conscience de cet inévitable règlement. »

Silvia Merler, « The stock market slide », in Bruegel (blog), 12 février 2018. Traduit par Martin Anota

samedi 3 février 2018

Cinq ans d’Abenomics

Par Martin Anota le samedi 3 février 2018, 10:00 - Croissance, cycles et crises

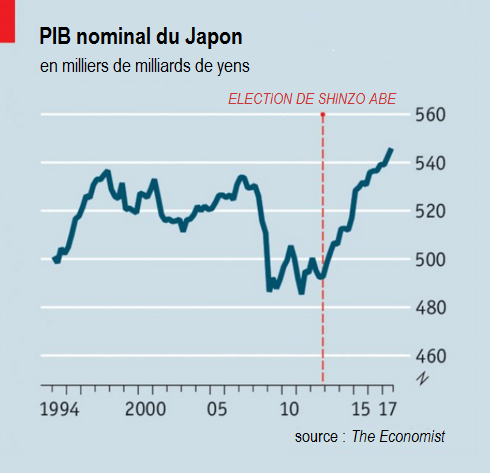

« Cinq ans ont passé depuis que le Premier ministre Shinzō Abe a été élu en 2012 et a commencé à mettre en œuvre ce qu’on qualifie d’"Abenomics", c’est-à-dire un ensemble de mesures macroéconomiques basées sur "trois flèches" : l’assouplissement monétaire, la relance budgétaire et les réformes structurelles. Cinq ans après, peut-on dire que l’Abenomics a été efficaces ? Nous passons en revue plusieurs commentaires qui ont récemment été tenus à ce sujet.

The Economist note que la devise du Japon s’est dépréciée d’environ vis-à-vis du dollar depuis novembre 2012 et que l’indice boursier Nikkei 225 a augmenté de plus 150 % sur la même période. Cela a contribué à relancer l’économie et le PIB japonais a augmenté sans discontinuité ces sept derniers trimestres, soit pour la plus longue période de croissance ininterrompue depuis 16 ans. Les exportations ont beaucoup contribué à cette performance, mais l’investissement privé a aussi augmenté de plus de 18 % en termes nominaux au cours des cinq dernières années. 2,7 millions d’emplois nets ont été créés, malgré une démographie défavorable. Pourtant, l’inflation ne s’est pas vraiment accélérée : l’indice des prix (si l’on exclut les aliments frais) a augmenté de seulement 0,7 % dans l’année qui précéda septembre 2017. La faible performance en matière d’inflation peut notamment s’expliquer par le fait que les salaires n’ont pas augmenté aussi rapidement qu’on ne l’attendait, en partie parce que la majorité des travailleurs japonais ont des contrats permanents et que leur salaire suit principalement le coût de la vie. Une seconde raison pourrait être la hausse de la population active, dans la mesure où davantage de femmes, de personnes âgées et dans une certaine mesure aussi de travailleurs étrangers sont entrés sur le marché du travail. En outre, là où le coût de la vie a augmenté, certaines firmes ont trouvé des façons d’accroître la productivité plutôt que les prix, en investissant dans des technologies économes en travail.

Scott Sumner (…) est d’accord à l’idée que l’impact le plus important de l’Abenomics a été sur le PIB nominal, ce dernier ayant suivi une tendance à la baisse jusqu’à l’élection d’Abe. Selon la théorie du monétarisme de marché, un PIB nominal élevé peut être utile pour répondre à deux problèmes : les excès d’endettement et un chômage cyclique élevé. L’Abenomics a été très efficace sur les deux fronts. Le chômage a chuté à 2,7 %, le niveau le plus faible en 23 ans ; et le ratio dette publique sur PIB a atteint un palier, après avoir explosé et atteint un taux dangereux ces dernières décennies. Les prix sont à la hausse ces cinq dernières années et la dynamique est certainement meilleure que la déflation qui que le Japon connaissait avant le déploiement de l’Abenomics, mais l’inflation est toujours inférieure à la cible de 2 %.

(…) Sumner affirme aussi qu’une inflation de 1 % est trop faible et que la Banque du Japon doit assouplir sa politique monétaire, pour deux raisons. Premièrement, Japon a fixé une cible d’inflation officielle de 2 % et une fois qu’une cible d’inflation cible est fixée, elle doit être atteinte pour que la politique monétaire reste crédible (la crédibilité étant cruciale pour la gestion des futures crises). Deuxièmement, Sumner pense que la Banque du Japon s’est trompée en utilisant les taux d’intérêt comme instrument de politique monétaire, parce que même une inflation de 2 % au Japon ne suffit probablement pas pour éviter la borne zéro lors d’une récession. Donc le Japon est dans une étrange situation où il n’a pas besoin de relance monétaire, mais où la Banque du Japon doit néanmoins adopter une relance monétaire parce que, si elle ne le faisait pas, le Japon pourrait chuter dans une récession à l’instant où la Banque du Japon perdrait en crédibilité.

Erik Norland (…) pense que l’Abenomics n’a pas encore pleinement dévoilé ses effets. L’économie japonaise s’est améliorée depuis 2012, mais elle a ralenti depuis début 2015 et l’expérience de la Banque du Japon avec les taux d’intérêt négatifs de court terme ne semble pas avoir été une réussite (Norland affirme que les taux négatifs ont empêché le Japon de retrouver des taux d’inflation positifs). Environ la moitié de la hausse temporaire de l’inflation en 2013-2014 peut être attribuée au passage de la TVA de 5 % à 8 % et, bien que cela n’ait pas été un thème majeur de la campagne, il faudra faire attention au possible relèvement de la TVA de 8 % à 10 %, qui accroîtrait l’activité préachat mais pourrait temporairement ralentir l’activité après la hausse. Une autre question qui a été évitée durant la compagne est celle de l’énergie nucléaire. Le gouvernement d’Abe a permis un retour progressif et partiel au nucléaire, qui doit limiter le déficit budgétaire du Japon et réduire la croissance de la demande de pétrole brut et de gaz naturel. Globalement, le Japon bénéfice actuellement d’un contexte international favorable, en l’occurrence de la première croissance mondiale synchronisée depuis 2007 ; mais la Chine pose un risque majeur, comme 25 % des exportations du Japon dirigées vers la Chine ou Hong Kong et qu’ils ont tous deux accumulé d’amples dettes. Norland pense que les niveaux de dette élevés du Japon vont probablement le laisser à de faibles taux d’intérêt de court terme ces prochaines années, malgré une meilleure performance économique.

Lechevalier et Monfort affirment que, au cours des cinq dernières années, les politiques proactives poursuivies dans le cadre de l’Abenomics ont joué un rôle décisif dans l’inversion d’une des causes du ralentissement japonais, en l’occurrence l’incohérence des politiques économiques, et qu’elles rapportent maintenant leurs premiers résultats. Cependant ils soulignent que, dans cinq ans, les performances ont été en-deçà des objectifs, en particulier en ce qui concerne l’inflation et la croissance du PIB. Ils sont plus critiques au regard des questions de long terme et pensent que l’Abenomics peut en définitive échouer en raison de l’incapacité à clairement définir un modèle de croissance pour la nation au cours des deux prochaines décennies. Selon Lechevalier et Monfort, le problème n’est pas tant le manque de réformes structurelles que leur capacité limitée à relever le potentiel de croissance du pays.

Un point similaire a été souligné par Shaori Shibata, qui affirme que les remèdes de style keynésien qui font partie intégrante de l’Abenomics n’ont pas été capables de répondre au problème de faible demande que connaît le Japon à plus long terme, en particulier en termes de consommation privée. C’est en grande partie à cause des mesures de libéralisation qui forment également partie intégrante de l’Abenomics et qui ne sont pas compatibles avec les remèdes keynésiens qui ont été adoptés. Alors que l’Abenomics a le potentiel (du moins à court et moyen termes) pour améliorer la profitabilité des entreprises, en l’absence d’une mesure visant à redistribuer la richesse des entreprises au travail, l’Abenomics représente aussi à l’avenir un danger pour la croissance économique du Japon.

Heizo Takenaka écrit que les performances économiques ont beau s’être clairement améliorées, il demeure toujours plusieurs défis sérieux. Les efforts pour la consolidation budgétaire et la revitalisation des économies régionales sont lents ; le creusement des écarts de revenu n’a pas été traité ; malgré les progrès économiques, la compétitivité du Japon relativement au reste du monde s’est davantage détériorée ; et les universités japonaises continuent de perdre des places dans les classements internationaux. En fin de compte, il est vrai que l’Abenomics a significativement stimulé l’économie, mais qu’elle peine à faire face aux changements rapides qui ont lieu dans le reste du monde. (…) »

Silvia Merler, « Abenomics, five years in », in Bruegel (blog), 8 janvier 2018. Traduit par Martin Anota

aller plus loin...

« Quelle est l’efficacité de l’Abenomics ? »

« La politique budgétaire est-elle efficace au Japon ? »

« billets précédents - page 4 de 5 - billets suivants »