« Le lundi 18 mars, le monde a appris la disparition à 58 ans d'Alan Krueger, (…) professeur d’économie politique à l’Université Princeton et l’un des économistes les plus influents de notre époque. Peu de temps après avoir appris cette tragique nouvelle, un ami m’a demandé : "quand as-tu rencontré pour la première fois Alan ?" Sur le coup, je ne m’en souvenais plus. Cela semblait que cela remontait il y a très longtemps. Donc je suis retourné dans ma correspondance avec Alan et j’ai trouvé que nous nous sommes rencontrés pour la première fois en personne assez récemment, en l’occurrence à la conférence de la Society of Labor Economists qui s’est tenue à Vancover en 2011, où nous avions parlé d’une étude que j’avais présentée et qui mesurait l’impact des salaires minima sur la rotation du personnel. J’ai trouvé cela assez surprenant, dans la mesure où j’ai ressenti la présence intellectuelle d’Alan durant l’essentiel de ma vie d’adulte. En effet, peu de gens ont eu autant d’influence qu’Alan sur la façon par laquelle je m’attaque à la recherche économique. (…)

Alan a contribué aux efforts visant à faire de l’économie une science empirique, quelque chose qui a touché chaque pan de la discipline. Vous pouvez ne pas suivre étroitement les études autour du salaire minimum, les rendements de l’éducation, les monopsones sur le marché du travail, l’économie du rock’n’roll ou tout autre domaine spécifique où Alan a réalisé d’importantes contributions. Mais si vous croyez que l’économie comme discipline doit chercher à répondre aux questions relatives ai fonctionnement de l’économie via des études crédibles et sans jamais substituer sacrifier l’empirique à l’idéologie, vous avez une grande dette envers Alan Krueger.

Pour beaucoup des plus jeunes économistes aujourd’hui, c’est comme une seconde nature de se focaliser sur des cadres de recherche transparents pour rechercher des liens causaux. Cependant, ce n’était pas le cas quand j’ai commencé à étudier la science économique au début des années quatre-vingt-dix. La "révolution de la crédibilité" en science économique était un combat difficile à mener en vu de pousser la discipline dans une autre direction. Cela peut sembler surprenant pour certains ; après tout, pourquoi quelqu’un ne voudrait-il pas de preuves empiriques qui soient fiables ?

Comme Alan le savait, la révolution de la crédibilité était profondément sujette à controverses et l’est toujours dans une certaine mesure. "L’idée de faire de l’économie une véritable science empirique, où les théories centrales peuvent être rejetées, est une grande idée révolutionnaire", m’avait-il écrit sur Twitter l’année dernière. Le courage intellectuel d’Alan se retrouvait dans sa volonté de laisser l’empirique nous mener là où il peut nous mener, en toute liberté vis-à-vis de nos idées reçues. Et peut-être qu’aucun autre travail n’illustre mieux cette volonté que le livre qu’il a publié en 1995 avec David Card, Myth and Measurement, qui envoya des ondes de choc à l’ensemble de la communauté des économistes.

Dans ce livre, Card et Krueger soutiennent avec force que les preuves empiriques selon lesquelles le salaire minimum détruit des emplois (une idée largement acceptée jusqu’alors) étaient étonnamment fragiles. Leur propre étude de cas (déjà publiée dans la revue American Economic Review) comparait les restaurants de fast-food dans le New Jersey et en Pennsylvanie après une hausse du salaire minimum dans le New Jersey. Ils constatèrent que l’emploi avait augmenté dans le New Jersey après la hausse du salaire minimum. Ce résultat était cohérent avec celui d’une autre étude qu’Alan avait réalisée avec Lawrence Katz, un économiste de Harvard qui était l’un de ses collaborateurs de longue date. Mais Myth and Measurement était bien plus que cela. Ce livre fournissait un vaste éventail de preuves empiriques sur des questions plus larges relatives au travail et poursuivait en affirmant que la totalité des preuves empiriques suggéraient que le modèle simple d’offre et de demande était inadéquat pour comprendre le marché du travail des bas salaires. Card et Krueger affirmaient que les employeurs avaient un certain pouvoir pour décider de leurs politiques salariales et ne se voyaient pas entièrement dicter leurs décisions par les forces invisibles du marché. Ils peuvent augmenter leurs salaires pour améliorer leur capacité à recruter et retenir les travailleurs, même si cela se traduit par des coûts du travail plus élevés. Ils appelaient cela le modèle de monopsone dynamique et ils affirmaient que celui-ci collait mieux aux données que le modèle simple d’offre et de demande.

Globalement, le livre visait à utiliser les meilleures preuves empiriques disponibles pour tester les théories fondamentales relatives au marché du travail. Et c’était une chose courageuse à faire : aller contre de ce qui faisait consensus en science économique à l’époque. En effet, la réaction de la part de certains économistes a été incroyablement hostile. Cependant, elle apporta une nouvelle énergie à la discipline. L’idée selon laquelle les preuves empiriques peuvent être utilisées pour tester différentes théories sur le fonctionnement de l’économie m’a enthousiasmé lorsque j’avais lu, encore étudiant, Myth and Measurement au milieu des années quatre-vingt-dix et cet ouvrage m’emmena dans ce champ. Et c’était également le cas pour beaucoup d’autres.

Un quart de siècle riche en événements s’est écoulé depuis la publication de Myth and Measurement. Selon moi, ses principaux constats ont plutôt bien résisté à l’épreuve du temps et restent en accord avec l’essentiel des analyses empiriques réalisées dans les études ultérieures. Cependant, même si l’on est en désaccord avec les preuves empiriques concernant le salaire minimum et l’emploi, on ne peut contester le fait que Myth and Measurement a exercé une énorme influence sur la discipline et qu’il a permis de mettre en avant un programme de recherche fructueux. Premièrement, il a aidé à catapulter le cadre de recherche « quasi-expérimental » (une approche qui se focalise sur l’utilisation de modifications exogènes de politique et qui soigne particulièrement la constitution de groupes de contrôle) au devant de l’analyse économique. Deuxièmement, ce livre permit de considérer un ensemble plus large de modèles du marché du travail. En d’autres mots, il contribua à pousser la science économique dans la direction où nous considérons la théorie fondamentale comme vérifiable, et non comme quelque chose découlant de la seule déduction. Et si l’essor de la littérature sur la concurrence imparfaite au cours des dernières années est un guide, Myth and Measurement a été un franc succès.

Alan a réalisé d’autres contributions à la fois méthodologiques et de substance, qui ont permis à la science économique de progresser. Un thème commun connectant l’essentiel de ses travaux est la combinaison de sa curiosité intellectuelle avec sa capacité à glaner des preuves empiriques à partir de sources inattendues. En 1991, avec son collègue de Princeton Orley Ashenfelter, il visita le seizième festival annuel de la journée des jumeaux à Twinsburg, dans l’Ohio, pour collecter des données sur des jumeaux identiques avec différents niveaux d’éducation. Ce fut une façon ingénieuse de contrôler les différences de capacité qui pourraient biaiser les estimations du taux de rendement de l’éducation. Son article avec Alex Mas, un autre collègue de Princeton, utilisa les bandes de roulement des pneus Firestone produits à la suite d’une grève au cours de laquelle l’entreprise remplaça les travailleurs grévistes pour montrer l’importance des relations de travail sur la qualité du produit. Son travail avec Stacy Dale de la Mathematica Policy Research utilisa de l’information à propos des diverses universitaires auxquelles chaque étudiant est admis de façon à prendre en compte les facteurs inobservés qui pourraient affecter le salaire de chacun. En procédant ainsi, ils aboutirent à un constat surprenant : dans plusieurs cas, aller dans une université d’élite n’accroît pas la rémunération future. Dans un travail antérieur avec Josh Angrist (désormais au MIT), il utilisa des bizarreries comme le trimestre de naissance ou la loterie de l’époque du Vietnam pour estimer l’effet causal de l’éducation sur les rémunérations. Ces études ont suscité de nombreux travaux postérieurs, notamment des études qui ont pu être en désaccord avec leurs constats. Mais c’est exactement la façon par laquelle la science progresse et Alan a contribué à nous pousser dans cette direction. (…) »

Arindrajit Dube, « Alan Krueger was the rare economist whose work improved the lives of millions », in Slate, 19 mars 2019. Traduit par Martin Anota

Epistémologie et histoire de la pensée

jeudi 28 mars 2019

Alan Krueger est l’un des rares économistes dont les travaux ont amélioré la vie de millions de personnes

Par Martin Anota le jeudi 28 mars 2019, 15:00

jeudi 21 février 2019

Pouvons-nous (toujours) compter sur la science économique ?

Par Martin Anota le jeudi 21 février 2019, 11:00

« Le magazine Foreign Policy considère mon ami Fareed Zakaria comme l’un des dix plus importants penseurs dans le domaine de la politique étrangère de la dernière décennie. Farred a célébré cette reconnaissance méritée en y publiant un essai intitulé "The End of Economics", où il fait part de ses doutes quant à la pertinence et à l’utilité de la science économique et des économistes. Parce que Fareed tient des propos réfléchis et fait écho à des arguments fréquemment avancés, il mérite une réponse tout aussi réfléchie.

Fareed ignore de grands pans de la pensée économique, il ignore que les économistes ont été à l’origine de la plupart des critiques avancées à l’encontre des précédentes théories économiques, il s’en prend à des hommes de paille et il n’offre pas vraiment d’alternative aux approches économiques de la politique publique.

Plusieurs critiques de l’économie saisissent l’échec des économistes à prédire la crise financière comme motif d’inculpation. Cet argument échoue à tenir compte d’une idée centrale qui est enseignée dans chaque cours sur les fondamentaux en finance. Les effondrements de marchés sont intrinsèquement imprévisibles, parce que si l’on parvenait à en prédire un, il surviendrait plus tôt, comme tout le monde vendrait ses actifs par anticipation. De plus, plusieurs économistes, notamment Janet Yellen, Raghuram Rajan et Robert Shillerand, ont fait part de leurs inquiétudes quant aux risques pesant sur le système financier et l’économie réelle dans les années et les mois qui précédèrent la crise.

Fareed cite les propos que Paul Krugman a pu avoir concernant "l’aveuglement face à la possibilité qu’il y ait des défaillances catastrophiques dans une économie de marché" dont feraient preuve les économistes. Pourtant, Fareed ne cite pas tous les propos de Krugman. Ce dernier se montre en effet critique envers la science économique, mais il a aussi affirmé pendant des années que la théorie macroéconomique telle qu’elle est présentée dans les manuels peut expliquer l’essentiel de la crise financière et de ses répercussions, mais aussi que les principaux échecs en matière de politique économique après la crise (en l’occurrence, l’insuffisance de la relance et les inquiétudes excessives à propos de l’inflation et des déficits publics) tiennent justement à une méconnaissance de la science économique (…). J’ai longtemps partagé les idées de Paul sur la fétichisation excessive de l’élégance mathématique en macroéconomie, mais cela ne revient pas à rejeter la macroéconomie des manuels qui s’est être révélée des plus pertinentes.

En faisant écho à d’autres critiques, Fareed s’attaque à l’utilisation par les économistes du PIB pour évaluer la performance économique nationale. C’est une inquiétude justifiée. Pourtant, tous les efforts sérieux visant à aller au-delà du PIB se fondent sur des travaux réalisés par d’éminents économistes. Pensez à James Tobin et à William Nordhaus avec leur ouvrage "Measure of Economic Welfare" écrit il y a un demi-siècle, à Partha Dasgupta sur la soutenabilité, à Amartya Sen sur les mesures du développement humain ou à Tony Atkinson et à Thomas Piketty sur les inégalités.

On affirme que l’hypothèse économique commune selon laquelle chaque agent est rationnel et présente un comportement maximisateur est peu cohérente avec les faits. C’est vrai. C’était déjà un thème majeur dans la recherche économique avant même que je naisse, par exemple avec Milton Friedman qui a écrit un célèbre article évoquant les raisons pour lesquelles les gens jouent à la loterie. Andrei Shleifer et moi-même avons passé en revue il y a plus d’un quart de siècle la littérature, déjà bien imposante à l’époque, sur les "spéculateurs bruyants" (noise traders), et l’idée selon laquelle les prix spéculatifs ne sont pas pleinement rationnels et reflètent l’avidité, la peur et l’émotion humaine apparaît clairement dans les écrits de bien d’autres économistes comme Charles Kindleberger, Robert Shiller, Richard Thaler et Brad DeLong. L’hypothèse d’individus rationnels maximisateurs est seulement utilisée comme une approximation de la réalité et les bons économistes en comprennent les limites. Plusieurs des plus grandes intuitions en économie comportementale ont été avancées il y a plusieurs décennies et elles font partie intégrante de la théorie et de la pratique économiques modernes. Les idées en matière de politique économique comme les taxes sur les transactions et les "nudges" qui se fondent sur l’irrationalité proviennent pour l’essentiel des économistes.

Fareed affirme aussi que les pays ne cherchent pas à maximiser un profit, comme s’il s’agissait d’une critique de l’économie. Je ne connais pas d’économistes qui ait affirmé que les pays maximisaient un profit. Et contrairement à son affirmer, je ne connais pas d’économistes qui aient affirmé que le revenu était le principal déterminant du comportement électoral.

Une évaluation des changements dans la pertinence de la science économique doit aussi considérer les domaines où l’analyse économique est devenue de plus en plus importante. Les questions de choix scolaire et d’écoles de charte tout d’abord étudiées par les économistes sont centrales aux débats à propos de la politique éducative. Les systèmes de paiement pour résultats plutôt qu’intrants, qui ont le potentiel de révolutionner le remboursement de soins de santé, sont le fruit du raisonnement et de la recherche économiques. Les débats de politique environnementale tournent autour de schémas basés sur le marché pour décourager la pollution et encourager des formes plus propres de la production. Peu de domaines de la société ne sont pas influencés par les big data et l’apprentissage automatique qui sont la dernière incarnation de l’économétrie.

La science économique ne peut perdre le rôle qu’elle joue que s’il y a quelque chose pour la supplanter. Fareed est enthousiaste à propos de ce que les autres disciplines peuvent apporter. Je partage son espoir, mais je note qu’il ne met pas en avant d’idées ou cadres spécifiques émanant des autres disciplines qui auraient aurait contribué à la politique publique au cours des dernières décennies. Il y a certainement des exemples de recherches des autres sciences sociales qui ont eu un impact important sur le débat public, mais sûrement pas assez pour suggérer que la science économique puisse être reléguée à la marge.

Je conclurai en étant très explicite sur un point. Je ne remets pas en question l’importance de l’évolution de la réflexion au regard de la politique publique qui a pris place depuis l’ère de Reagan-Thatcher ou même depuis l’ère Clinton-Blair. Pour des raisons qui tiennent à la fois des avancées dans la compréhension du monde et des changements dans sa structure, la plupart des économistes (…) s’intéressent davantage aux questions de la redistribution, de la régulation, des monopoles et de la gestion de la demande globale qu’ils ne l’étaient il y a un quart de siècle. Comme le disait Keynes, "lorsque les faits changent, je change d’opinion. Et vous ?".

La gestion de la mondialisation, le soutien d’une classe moyenne à l’ère des intelligences artificielles et la préservation de la planète doivent être considérés comme des défis majeurs, voire comme les principaux défis, de notre ère. Si ce n’est pas de l’économie, il est difficile de voir d’où les solutions pourraient provenir. Chacun (qu’il apprécie la science économique ou ressente de la défiance à son égard) a intérêt à ce que la discipline soit pertinente et fructueuse pour aller de l’avant. »

Lawrence Summers, « Has economics failed us? Hardly ». Traduit par Martin Anota

samedi 24 novembre 2018

Ce que Solow pense de l’offensive de Friedman

Par Martin Anota le samedi 24 novembre 2018, 09:00

« La fameuse allocution présidentielle de Milton Friedman en 1967 porte explicitement sur les usages et la conduite de la politique monétaire. Mais cela entrait dans un objectif plus large. Il cherchait à saper le keynésianisme américain éclectique des années cinquante et soixante, (…) celui auquel Joan Robinson donna l’étiquette (…) de keynésianisme "bâtard".

En fait, si j’emploie l’adjectif "éclectique", c’est pour vous rappeler que ce n’était pas une doctrine axiomatique unifiée, mais plutôt une collection d’idées à travers lesquelles des gens comme James Tobin, Arthur Okun, Paul Samuelson et d’autres (notamment moi-même) ont évoqué des événements et politiques macroéconomiques. Ils pensaient généralement qu’un déséquilibre entre la demande agrégée et l’offre agrégée (ou "potentiel") était possible, mais aussi que les mécanismes équilibreurs étaient tellement lents et faibles qu’une tel déséquilibre était susceptible de persister. Quand la demande est insuffisante par rapport au potentiel, une certaine version du modèle Is-LM était utilisée, à laquelle on pouvait ajouter des extensions et des raffinements quand c’était nécessaire. En temps utile, une variante ou une autre de la courbe de Phillips était intégrée dans l’appareillage standard. Les chocs d’offres et leurs conséquences furent ensuite pris en compte.

Dans la section où il explique "ce que la politique monétaire ne peut pas faire", Friedman (…) affirme tout d’abord que la banque centrale, en l’occurrence la Fed, ne peut "fixer" (peg) le taux d’intérêt réel. (Cette idée de "fixation" va se révéler importante.) Ce devait être le taux d’intérêt réel s’il s’agissait d’affecter l’investissement et d’autres dépenses. Le but ici est de remettre en cause la courbe LM standard. Ces jours-ci, il est pratique courante de remplacer la vieille courbe LM avec un M donné par une fonction de réaction de la banque centrale de base qui spécifie une taux directeur réel comme fonction du niveau de l’activité économique. Dans ce cadre, l’affirmation de Friedman est qu’il peut ne pas avoir une telle fonction de réaction. La Fed peut fixer le taux de fonds fédéraux, mais pas le taux d’intérêt réel.

La raison fondamentale est que la Fed contrôle une variable nominale, la taille de son propre bilan, et qu’elle peut utiliser ce contrôle pour déterminer une autre quantité nominale, mais pas réelle. (Les keynésiens américains éclectiques pensaient que ces territoires étaient remplis de rigidités, de retards et d’irrationalités, si bien que les événements nominaux pouvaient facilement avoir des conséquences réelles.) Mais Friedman explique plus concrètement l’essence de son raisonnement. Supposons que la Fed essaye d’atteindre un taux d’intérêt réel plus faible (en partant depuis une certaine position d’équilibre initiale), des achats de titres vont accroître leur prix et réduire leur rendement nominal. Mais comme le niveau des prix ne répond pas instantanément, le taux d’intérêt réel chute aussi. Comme Friedman le dit, c’est seulement le début du processus, pas la fin. De plus faibles taux d’intérêts et de plus amples détentions de liquidité vont stimuler l’investissement et peut-être d’autres dépenses. (C’est ce qui semblait être l’objectif de la Fed en premier lieu.) Les plus fortes dépenses vont accroître la demande de crédit, pousser les prix à la hausse et donc réduire les détentions de liquidité, et ainsi de suite. Après une brève discussion, Friedman en vient au point que je veux souligner. "Ces (…) effets vont annuler la pression baissière sur les taux d’intérêts assez promptement, disons, en moins d’un an. Ensemble, ils vont tendre plus tard, disons, après une année ou deux, à ramener les taux d’intérêt au niveau qu’ils auraient sinon atteint" (Friedman, p. 6). Maintenant, nous savons ce que la "fixation" signifie.

Ces affirmations à propos du calendrier ne sont pas anecdotiques. L’objectif, souvenez-vous, est de réfuter la conception que se faisait le keynésianisme américain éclectique de la politique monétaire contracyclique (…). Si la Fed peut avoir une influence significative seulement pendant un ou deux ans au maximum, alors elle joue sûrement un jeu perdant, en particulier à la vue de ces "délais longs et variables". Est-ce vraiment le cas ? Un esprit chevronné peut facilement imaginer une économie qui fonctionne ainsi ; la question est de savoir si notre économie fonctionne comme cela.

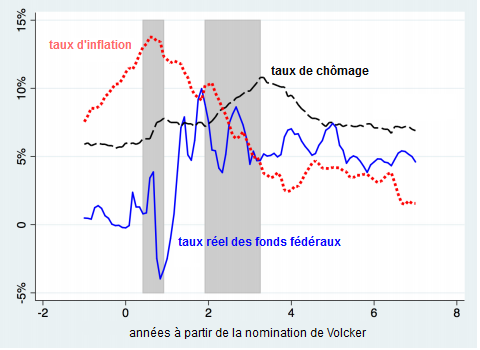

Dans un récent article bien caustique ("The Trouble With Macroeconomics", qui sera bientôt publié dans l’American Economist), Paul Romer a montré (dans son graphique n° 2) ce qui s’est passé pour le taux réel des fonds fédéraux dans les années juste avant et juste après la nomination de Paul Volcker à la tête de la Réserve fédérale. Le taux réel des fonds a fluctué autour de zéro au cours de l’année précédente. Après une brève récession, il a ensuite grimpé brutalement à 5 % et fluctué autour de ce niveau pendant les six années suivantes, lorsque le diagramme de Romer s’arrête. Cette hausse soutenue de 5 points de pourcentage du taux réel des fonds fédéraux n’est pas un événement aléatoire. Ce fut le résultat d’une intervention délibérée, visant à mettre un terme à l’inflation "à deux chiffres" des années soixante-dix, et celle-ci y parvint, avec de réels dommages collatéraux. Cette chaîne d’événements peut ne pas avoir fonctionné via un quelconque mécanisme de "perception erronée", il n’y avait pas de secret à propos de ce que faisait la Fed de Volcker.

source : Romer

Donc, la Fed était en fait capable de contrôler (fixer) son taux directeur réel, non pas sur un an ou deux, mais pendant au moins six ans, certainement assez longtemps pour que la conduite normale de la politique monétaire contracyclique soit efficace. L’histoire de la Fed de Bernanke et de Yellen est bien plus compliquée, en raison de la borne inférieure zéro (zero lower bound), mais elle ne soutient clairement pas la conception de Friedman. La Fed était apparemment capable de réduire le taux réel des bons du Trésor à dix ans une demi-douzaine d’années, entre 2011 et 2016. (…) La différence entre "une année ou deux" et une "demi-douzaine d’années" n’est pas une mince affaire. Cette partie du projet de démolition de Friedman semble avoir échoué en tant qu’économie pragmatique, bien qu’elle ait pu avoir réussi à séduire la profession.

La deuxième contribution, plus marquante, de l’allocution présidentielle de 1967 a été l’introduction du "taux de chômage naturel" par Friedman avec la courbe de Phillips verticale à long terme et ses implications accélérationnistes. Selon la formule bien connue, le taux naturel est celui "qui résulterait de l’équilibre général walrasien, en tentant compte des caractéristiques structurelles des marchés des biens et du travail, notamment des imperfections de marché, de la variabilité stochastique des demandes et des offres, du côté d’obtention d’informations à propos des postes vacants ou des disponibilités en main-d’œuvre, des coûts de mobilité, et ainsi de suite" (p. 8). (Etait-ce ironique ? Y a-t-il une personne sur Terre qui soit capable de dire ce que pourrait être le taux naturel ce trimestre ou le suivant ?)

Je n’ai pas besoin de rappeler la discussion classique de Friedman des conséquences si la Fed (ou quelqu’un d’autre) cherche à pousser le taux de chômage sous le taux naturel : une plus forte expansion monétaire, qui accroît tout d’abord les dépenses, la production et l’ample, comme les prix s’ajustent avec retard au nouvel état de la demande. Mais au final, le taux d’inflation, qu’importe son niveau antérieur, s’accroît et cela est pris en compte dans les anticipations. "Les salariés vont commencer à prendre conscience de la hausse des prix des choses qu’ils achètent et à demander de plus hauts salaires nominaux à l’avenir" (Friedman, p. 10). Donc la Fed doit créer encore une plus forte croissance monétaire pour soutenir le taux de chômage plus faible et vous connaissez la suite. Une fois encore, nous pouvons imaginer un tel monde ; ce que Friedman affirme, c’est que nous vivons dans un tel monde. (…)

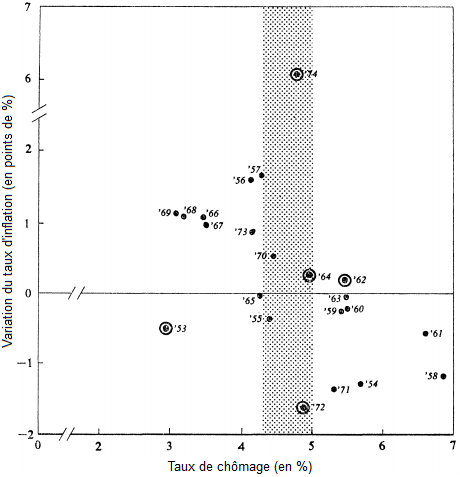

Pendant une brève période de temps dans les années soixante-dix et au début des années quatre-vingt, le modèle accélérationniste le plus simple semblait bien fonctionner : si vous représentiez la variation du taux d’inflation et le taux de chômage (cf. Modigliani et Papademos, 1975), vous obteniez un nuage de points qui tendait à se regrouper autour d’une droite décroissante croisant l’axe des abscisses à un taux naturel (ou NAIRU) assez bien défini. A d’autres époques, pas vraiment.

source : Modigliani et Papademos (1975)

Par exemple, Olivier Blanchard (2016) a récemment observé soigneusement et impartialement la période après 1980 et il a abouti aux conclusions suivantes. Premièrement, il y a toujours une courbe de Phillips, dans le sens où l’inflation réagit au chômage. Deuxièmement, les anticipations d’inflation sont devenues de plus en plus "ancrées", ce qui signifie de moins en moins dépendantes de l’expérience courante et récente. Donc (…) nous sommes plus ou moins retournés à la courbe de Phillips de Phillips où le taux d’inflation, non la variation du taux d’inflation, dépend du taux de chômage. (Une telle ancre n’est pas susceptible de survivre lorsque l’inflation dévie significativement et durablement par rapport à l’expérience courante. C’est dans le moyen terme que nous vivons.) Troisièmement, la pente de la courbe de Phillips s’est aplatie, depuis les années quatre-vingt, et elle est désormais assez faible. Et enfin, l’écart-type autour de la courbe de Phillips est large ; la relation n’est pas bien définie dans les données.

Combinés, ces deux derniers constats impliquent qu’il n’y a pas de taux de chômage naturel bien défini, que ce soit statistiquement ou conceptuellement. (…). Entre 2009 et 2016, le taux de chômage national a chute assez régulièrement de 9,3 % à 4,9 % tandis que l’inflation (du PIB en chaîne) est passée de 0,8 % à 1,3 % par an, sans tendance claire.

C’est très différent de l’histoire que l’on entend être récitée avec tant de confiance et d’aisance dans l’allocution de 1967. (…) L’allocution présidentielle de Friedman (…) a certainement contribué à mener la macroéconomie vers son étant actuel de non-pertinence épurée. La crise financière et la récession qui suivit celle-ci a peut-être planté certains doutes, mais nous ne pouvons même pas être certains de cela.

Certains des grands échecs comme ceux que j’ai notés dans cette note peuvent ne pas suffire pour rejeter la doctrine de Friedman et de ses divers successeurs. Mais ils suffisent certainement pour justifier qu’on se montre sceptique, en particulier parmi les économistes, pour qui le scepticisme devrait de toute façon être l’état mental par défaut. Donc pourquoi (…) ces idées ont-elles vogué pendent si longtemps sans rencontrer beaucoup de résistance ? Je n’ai pas de réponse définitive.

On peut spéculer. Peut-être qu’un patchwork d’idées comme celles du keynésianisme américain éclectique, tenues ensemble avec du ruban adhésif, constitue toujours un désavantage par rapport à une doctrine monolithique qui a une réponse pour tout et la même réponse pour tout. Peut-être que cette même doctrine monolithique s’est renforcée et a été renforcée par le déplacement général des préférences politiques et sociales vers la droite que l’on a pu observer au cours du temps. Peut-être que ce morceau d’histoire intellectuelle était essentiellement une concaténation accidentelle d’événements, de personnalités et de dispositions. Et peut-être que c’est la sorte de question dont il vaut mieux discuter en grillant des marshmallows autour d’un feu de camp mourant. »

Robert Solow, « A theory is a sometime thing », in Review of Keynesian Economics, vol. 6, n °4, 2018. Traduit par Martin Anota

aller plus loin...

« La courbe de Phillips est-elle bien morte ? (édition américaine) »

L’élaboration et la réception du discours présidentiel de Friedman

« Quel est l’héritage du discours présidentiel de Friedman ? »

« Gordon et l’hypothèse du taux de chômage naturel »

« Le taux de chômage naturel, un concept suranné »

jeudi 18 octobre 2018

La croissance et l’environnement au menu du prix Nobel d’économie 2018

Par Martin Anota le jeudi 18 octobre 2018, 13:00

« Le prix de la Banque de Suède en sciences économiques en mémoire d'Alfred Nobel a été attribué cette année à William Nordhaus et à Paul Romer pour avoir intégré le changement climatique et l’innovation technologique à l’analyse macroéconomie de long terme. Nous passons en revue les réactions de plusieurs économistes à cette annonce.

Sur VoxEU, Kevin Bryan a évoqué comment les lauréats du prix Nobel d’économie de cette année ont élaboré leurs contributions et comment ces dernières sont liées entre elles. Cela faisait plusieurs années que l’on s’attendait à ce que Nordhaus et Romer reçoivent cette récompense, mais c’est le fait qu’ils l’aient reçue en même temps qui a surpris : Nordhaus est surtout connu pour ses travaux en économie environnementale et Romer pour sa théorie de la croissance endogène. Mais après réflexion, les liens entre leurs travaux apparaissent évidents.

Avec Romer, nous avons un modèle d’équilibre général pour réfléchir aux raisons pour lesquelles les gens produisent de nouvelles technologies. La connexion avec Nordhaus se fait avec un problème qui est à la fois provoqué et résolu par la croissance. La croissance en tant qu’objectif de politique économique n’était pas remise en cause dans les années soixante, mais au début des années soixante-dix les inquiétudes environnementales font leur apparition. Les « modèles d’évaluation intégrés » ont de l’épargne endogène à la Solow et précisent l’arbitrage entre croissance économique et changement climatique, mais met aussi en évidence l’importance critique du taux d’escompte social et des micro-estimations du coût d’ajustement au changement climatique. (…)

Martin Sandbu affirme qu’au cours de notre existence, les changements technologique et environnemental ont transformé la façon par laquelle nos économies fonctionnent. La prochaine fois que nous nous émerveillerons à propos de notre application de smartphone favorite ou que nous nous inquiéterons de la plus grande fréquence des intempéries, affirme Sandbu, nous devrons avoir une pensée pour Romer et Nordhaus. Grâce à eux, nous sommes mieux armés pour trouver les bonnes politiques pour traiter avec la question de l’innovation ou du changement climatique. Ils méritent leur prix.

Peter Dorman a voulu parler d’une personne qui n’a pas reçu le prix Nobel et dont l’absence de consécration est lourde de signification. Nordhaus a passé plusieurs années à débattre avec Martin Weitzman, qui rejetait l’approche en termes de coût social du carbone au motif qu’une bonne politique doit se baser sur le principe d’assurance visant à éviter le pire scénario. Son "théorème lugubre" démontre que, sous certaines hypothèses, la probabilité d’événements extrêmes ne baisse pas aussi rapidement que s’élève de catastrophe augmente, si bien que leur coût attend s’accroît sans limite ; et cela s’applique aux scénarii du changement climatique.

Les travaux de Weitzman sont souvent invoqués par ceux qui croient qu’une action plus agressive est nécessaire pour limiter le réchauffement climatique. Par conséquent, quand les économistes spéculaient sur l’identité du prochain lauréat du prix Nobel et considéraient l’hypothèse d’une attribution de la récompense à Nordhaus, ils pensaient que Weitzman serait son colistier. Selon Dormans, le combo Nordhaus-Romer est si artificiel et si peu convaincant qu’il est difficile de penser que le prix qui n’a pas été attribué à Weitzman est aussi important que celui qui a été attribué à Nordhaus et qu’il s’agit clairement d’un message politique sur la bonne façon de gérer le changement climatique et la mauvaise façon de gérer le changement climatique.

Timothy Terrell n’est pas du même avis. Il pense que le comité Nobel a promu la réglementation environnementale avec son dernier choix. Les deux lauréats appellent à un plus grand rôle pour l’Etat : Romer lorsqu’il suggère que le gouvernement doit investir dans la recherche-développement et utiliser la réglementation des brevets pour stimuler la croissance économique ; Nordhaus lorsqu’il indique que le gouvernement doit agir pour empêcher un changement climatique pernicieux. (…)

David Warsh affirme que Nordhaus et Romer ont beau avoir travaillé sur des problèmes apparemment différents et n’ont que rarement été cités ensemble, leurs travaux se combinent pour donner lieu à un argument convaincant. En s’efforçant de modéliser le plus finement possible l’interaction entre la présence de carbone dans l’atmosphère, le changement climatique et la croissance économique, Nordhaus a rendu possible l’estimation des dommages provoqués par la hausse des températures. Une taxe carbone (que Nordhaus et bien d’autres économistes considèrent comme préférable au système de marchés de droits à polluer comme celui de l’Accord de Paris) peut empêcher les dommages les plus sérieux : elle doit tout d’abord être fixée à un faible niveau pour ensuite augmenter et ce tant qu’il le faut pour contenir les dommages. Romer, de son côté, a créé un cadre analytique dans lequel l’anticipation d’une telle taxe conduit à une vague d’innovations qui permettraient de réduire les émissions de carbone. (…)

Noah Smith écrit que, en plus d’honorer deux chercheurs dont les contributions ont profondément influencé leur champ respectif, la récompense fait écho à quelque chose dont le monde commence à manquer, en l’occurrence la croissance économique. Dans la mesure où la croissance ralentit et où la productivité stagne dans le monde riche, les intuitions de Romer sont plus importantes que jamais. »

Silvia Merler, « The 2018 Nobel prize: Growth and the environment », in Bruegel (blog), 15 octobre 2018. Traduit par Martin Anota

aller plus loin... lire le résumé des travaux de Nordhaus et Romer par l'Académie des sciences de Suède et la synthèse d'Alexandre Delaigue

lundi 8 octobre 2018

Innovation, croissance et changement climatique. Petit résumé des travaux de Nordhaus et Romer

Par Martin Anota le lundi 8 octobre 2018, 14:40

« Le prix en sciences économiques de cette année récompense la conception de méthodes qui contribuent à répondre à certains enjeux les plus fondamentaux et pressants de notre époque : la croissance soutenable à long terme de l’économie mondiale et du bien-être de la population mondiale.

L’étude de la façon par laquelle l’humanité gère des ressources limitées est au cœur de la science économique et, depuis sa constitution comme science, l’économie a reconnu que les plus importantes contraintes sur les ressources concernent la Nature et le savoir. La Nature dicte les conditions dans lesquelles nous vivons et le savoir définit notre capacité à gérer ces conditions. Cependant, malgré leur rôle central, les économistes n’ont généralement pas étudié comment la Nature et le savoir sont affectés par les marchés et les comportements économiques. Les lauréats de cette année, Paul M. Romer et William D. Nordhaus, ont élargi le champ de l’analyse économique en concevant des outils qui nous permettent d’examiner comment l’économie de marché influence à long terme la Nature et le savoir.

Le savoir. Pendant plus d’un siècle, l’économie mondiale a crû à un rythme remarquable et assez régulier. Quand quelques pourcents de croissance économique par an s’accumulent sur plusieurs décennies, voire plusieurs siècles, cela bouleverse vraiment la vie des gens. Cependant, la croissance a progressé bien plus lentement durant l’essentiel de l’histoire humaine. Elle varie aussi d’un pays à l’autre. Donc, qu’est-ce qui explique pourquoi la croissance survient à un tel moment et à tel endroit ? La réponse qu’avancent habituellement les économistes est le progrès technique, à travers lequel des volumes croissants de savoirs sont incarnés dans les technologies créées par des inventeurs, des ingénieurs et des scientifiques. Au début des années quatre-vingt, quand il était un étudiant en doctorat à l’Université de Chicago, Paul Romer a commencé à développer la théorie de la croissance endogène, où les avancées technologiques ne proviennent pas simplement de sources externes – exogènes -, comme le supposaient jusqu’alors les modèles économiques. En fait, elles sont créées par des activités marchandes. Les constats de Romer nous permettent de mieux comprendre quelles sont les conditions de marché qui favorisent la création de nouvelles idées pour des technologies rentables. Ses travaux nous aident à concevoir des institutions et des politiques qui peuvent améliorer la prospérité humaine en instaurant les bonnes conditions pour le développement technologique.

La Nature. William Nordhaus a commencé ses travaux dans les années soixante-dix, après que les scientifiques aient commencé à se préoccuper à l’idée que la combustion des énergies fossiles puisse entraîner un réchauffement climatique et des effets pernicieux d’un tel changement climatique. Nordhaus s’est donné la tâche immense d’examiner les liens de causalité bidirectionnels entre l’activité humaine et le climat, en combinant théories fondamentales et résultats empiriques tirés de la physique, de la chimie et de l’économie. Il n’a donc pas simplement considéré la Nature comme une contrainte sur l’activité humaine, mais il a également pris en compte le fait que la première soit en retour grandement influencée par cette dernière. Nordhaus est la première personne à concevoir des modèles simples, mais dynamiques et quantitatifs, du système économique-climatique mondial, désormais appelés "modèles intégrés d’évaluation" (integrated assessment models, IAM). Ses outils nous permettent de simuler comment l’économie et le climat évolueront dans le futur selon des hypothèses alternatives à propos des fonctionnements de la Nature et de l’économie de marché, notamment à propos des politiques mises en œuvre. Ses modèles apportent des réponses à des questions à propos de la désirabilité de différents scénarii mondiaux et différentes interventions politiques.

Les imperfections dans le marché mondial. Les deux lauréats ont mis en lumière les effets de débordement (spillover effects) dans la société, c’est-à-dire les conséquences sur autrui qui ne sont pas prises en compte par les individus, notamment les innovateurs et les pollueurs. Toute idée de nouvelle technologie, qu’importe là où elle apparaît, peut être utilisée pour la production de nouveaux biens et de nouvelles idées ailleurs, aujourd’hui ou dans le futur. De même, l’émission d’une unité supplémentaire de carbone se diffuse rapidement dans l’atmosphère et contribue au changement climatique, affectant toute l’humanité aujourd’hui et dans le futur. Les économistes parlent d’"externalités" pour qualifier ces effets de débordement. Les externalités étudiées par Romer et Nordhaus ont une portée mondiale et des conséquences à long terme. Comme les marchés non régulés vont générer des conséquences inefficaces en présence de telles externalités, le travail de Romer et de Nordhaus fournit des arguments convaincants pour l’intervention publique.

L’innovation technologique

Motivation. Les différences de long terme dans les taux de croissance ont d’énormes conséquences. Si deux économies commencent avec le même PIB par tête, mais que l’une d’entre elles croît à un rythme annuel supérieur de 4 points de pourcentage à la seconde, alors elle sera presque cinq fois plus riche que la seconde au bout de 40 ans. Un modeste écart de croissance de 2 points de pourcentage permet à la première économie d’être deux fois plus riche que la seconde au bout de 40 ans.

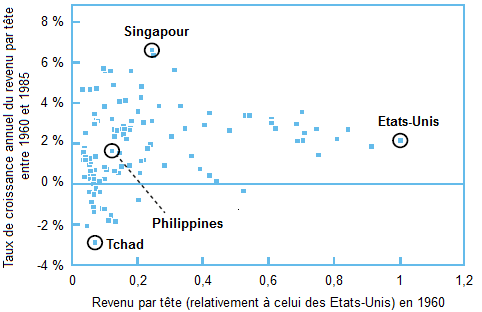

A la fin des années quatre-vingt, Romer a constaté que les taux de croissance du revenu dans les données observées variaient grandement d’une économie à l’autre. Le graphique 1, basé sur l’un des articles de Romer, représente le revenu par tête en 1960 et la croissance moyenne pour les 25 années suivantes pour plus de 100 pays ; un graphique avec des données actualisées lui ressemblerait fortement. Chaque carré représente un pays. Comme le graphique le montre, les écarts de taux de croissance typiques entre des pays s’élevaient à plusieurs points de pourcentage et il y a un grand écart (autour de 10 points de pourcentage) entre les pays ayant la plus forte croissance et les pays ayant la plus faible croissance. De plus, le graphique ne montre pas de relation systématique entre le revenu initial et la croissance : certains pays pauvres croissent rapidement, tandis que d’autres décroissent. Romer en conclut qu’il était crucial de comprendre les causes de tels écarts persistants et significatifs entre les taux de croissance et il commença à rechercher une explication.

GRAPHIQUE Revenu par tête (relativement à celui des Etats-Unis) et croissance annuelle subséquente du revenu par tête

source : Romer (1987)

Des zones d’ombre empiriques et théoriques. Comme Romer l’a noté, la théorie de la croissance qui dominait à l’époque (le modèle de croissance de Solow, qui fut couronnée par le prix Nobel de sciences économiques en 1987) pouvait expliquer plusieurs aspects de la croissance économique, mais pas des écarts amples et durables dans les taux de croissance entre les pays. Le modèle de Solow prédit que les pays les plus pauvres devraient croître plus rapidement les pays riches et rattraper ces derniers assez rapidement, ce qui n’est pas ce que suggère le graphique 1. Dans ce modèle, une économie peut croître en accumulant du capital physique, par exemple des machines ou des infrastructures, mais la croissance tirée par le capital peut s’essouffler à long terme ; pour toute technologie donnée, tout supplément de capital accroît de moins en moins la production. Pour qu’il y ait une croissance durable à long terme (et des écarts de croissance) dans le modèle, l’hypothèse était que les travailleurs deviennent de plus en plus productifs grâce aux avancées technologiques, bien qu’à des rythmes différents d’un pays à l’autre. Par conséquent, le modèle de Solow n’explique pas ces tendances, parce que les changements technologiques n’y arrivent que de façon exogène, depuis une "boîte noire".

L’une des percées majeures de Romer est d’avoir ouvert cette boîte noire et d’avoir montré comment les idées pour les nouveaux biens et services (produits par de nouvelles technologies) peuvent être créées dans l’économie de marché. Il a aussi montré comment un tel changement technologique endogène peut influencer la croissance économique et quelles politiques sont nécessaires pour que ce processus fonctionne bien. Les contributions de Romer ont eu un énorme impact dans le champ de la science économique. Ses explications théoriques ont posé les fondations pour la recherche sur la croissance endogène et les débats suscités par ses comparaisons internationales de croissance ont ouvert la voie à de nouvelles et prometteuses recherches empiriques.

Qu’y a-t-il de spécial à propos de la croissance tirée par les idées ? Pour répondre à cette question, nous devons comprendre comment les idées diffèrent des biens comme le capital physique ou du capital humain. Romer nous apprend à considérer les biens en utilisant deux dimensions (…).

Dans la première dimension, le capital physique et le capital humain sont des biens rivaux. Si une machine ou un ingénieur formé sont utilisés dans une usine, cette machine ou cet ingénieur ne peuvent être utilisés simultanément dans une autre usine. Par contre, les idées sont des biens non rivaux : une personne ou une entreprise utilisant une idée n’empêchent pas les autres de l’utiliser également.

Dans la seconde dimension, ces biens peuvent être excluables (ou exclusifs) si les institutions ou régulations permettent d’empêcher quelqu’un de les utiliser. Pour certaines idées, telles que les résultats tirés de la recherche fondamentale, c’est difficile, voire impossible : pensez à des outils mathématiques comme le théorème de Pythagore. Pour d’autres idées, cependant, les utilisateurs peuvent être exclus via des mesures techniques (telles que le cryptage) ou la réglementation des brevets. L’un des articles de Romer a montré comment la rivalité et l’excluabilité des idées déterminaient la croissance économique.

Romer croyait qu’un modèle de marché pour la création d’idées devait prendre en compte le fait que la production de nouveaux biens (qui se base sur les idées) puisse avoir des coûts déclinant rapidement : la première ébauche a un énorme coût fixe, mais la réplication a de faibles coûts marginaux. Une telle structure des coûts implique que les entreprises doivent avoir une marge, c’est-à-dire fixer le prix au-dessus du coût marginal, de façon à ce qu’elles puissent récupérer le coût fixe initial. Les entreprises doivent donc avoir un certain pouvoir de monopole, ce qui n’est possible que pour des idées suffisamment excluables. Romer a aussi montré que la croissance tirée par l’accumulation d’idées, à la différence de la croissance tirée par l’accumulation de capital physique, ne présente pas forcément de rendements décroissants. En d’autres termes, la croissance tirée par les idées peut rester soutenue à long terme.

Les imperfections de marché et la politique économique. En principe, le nouveau savoir créé par une recherche-développement fructueuse peut profiter aux entrepreneurs et aux innovateurs partout dans le monde, maintenant et dans le futur. Cependant, les marchés ne récompensent en général pas totalement les créateurs de nouveaux savoirs pour tous les bénéfices de leurs innovations, ce qui signifie que (aussi longtemps que le nouveau savoir est socialement bénéfique), il y aura trop peu de recherche-développement. De plus, comme les incitations de marché pour la recherche-développement prennent la forme de profits de monopole, il n’y aura typiquement pas de provision adéquate de nouvelles idées une fois qu’elles auront été inventées. La recherche subséquente a montré comment les résultats de marché peuvent aussi entraîner trop de recherche-développement : soit lorsque les nouvelles idées conduisent à l’éviction de trop nombreuses entreprises existantes lors du processus de destruction créatrice, soit lorsque les nouvelles idées augmentent les technologies socialement néfastes, par exemple en permettant une extraction ou un usage excessifs de carburants fossiles, ce qui nuit au climat.

Pour résumer, Romer a montré que des marchés non régulés vont générer un changement technologique, mais qu’ils tendent à ne pas fournir assez de recherche-développement, donc pas assez de nouveaux biens. Pour répondre à cette insuffisance, il faut des interventions publiques bien conçues, comme les subventions à la recherche-développement et la réglementation des brevets. Son analyse dit que de telles politiques sont vitales pour la croissance à long terme, pas simplement dans un pays, mais au niveau mondial. Elle fournit aussi un guide pour la conception des politiques : le système de brevets doit parvenir à établir un bon équilibre entre les incitations à créer de nouvelles idées (en accordant à leurs concepteurs certains droits au monopole) et la capacité des autres à les utiliser (en limitant ces droits au monopole dans le temps et dans l’espace).

Le changement climatique

L’activité humaine a contribué à une hausse rapide des températures mondiales moyennes au cours du dernier siècle. Même s’il y a une certaine ’incertitude autour de l’ampleur à laquelle cela va affecter le climat dans le futur, le consensus en sciences naturelles est que ce sera "selon toute probabilité un impact significatif".

Motivation. Dans les années soixante-dix, quand il était un jeune étudiant à l’Université de Yale, William Nordhaus a étudié en profondeur les données naissantes sur le réchauffement climatique et ses causes probables et il en conclut qu’il devait faire quelque chose. Sa crainte l’a amené à développer de nouveaux outils pour nous aider à comprendre comment l’économie peut générer un changement climatique, ainsi que les conséquences sociétales du changement climatique. Il voulait développer un cadre qui permette d’analyser le changement climatique en termes de coûts et bénéfices.

Un défi de taille. Comme Romer, Nordhaus étendit le modèle de croissance de Solow avec un important ensemble d’effets de débordement en incluant le réchauffement climatique provoqué par les émissions de carbone. Dans ce cas, les externalités en question étaient essentiellement négatives. Surtout, les mécanismes et causes du changement climatique anthropique impliquent des processus étudiés dans les sciences naturelles. Une analyse globale du changement climatique requiert donc une approche vraiment intégrée, dans laquelle la société et la Nature interagissent.

Prenant conscience de la nécessité d’une telle approche, Nordhaus est à l’origine du développement des modèles intégrés d’évaluation (integrated assessment models). (…)

Des recommandations en matière de politique. Selon les travaux de Nordhaus, le remède le plus efficace pour les problèmes provoqués par les émissions de gaz à effet de serre serait un dispositif mondial de taxes carbone qui soient imposées uniformément dans tous les pays. Cette recommandation s’appuie sur un résultat formulé dans les années soixante par un économiste britannique, Arthur Cecil Pigou, à savoir que chaque émetteur paye le coût social du dommage provoqué par ses émissions via un prix approprié. Un système mondial de droits d’émission peut parvenir au même résultat, à condition que les quotas soient fixés à un niveau suffisamment faible pour entraîner un prix du carbone suffisamment élevé.

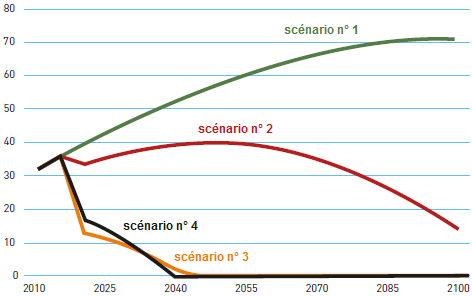

Cependant, les modèles IAM ne fournissent pas seulement des résultats qualitatifs. Ils nous permettent de calculer des trajectoires quantitatives pour la meilleure taxe carbone et montrent comment ces trajectoires dépendent crucialement d’hypothèses à propos des paramètres : par exemple, la sensibilité de la température mondiale à la concentration de carbone dans l’atmosphère, la durée pendant laquelle celui-ci reste dans l’atmosphère et l’ampleur des dommages provoqués par le changement climatique. Une récente étude de Nordhaus offre une bonne illustration de la façon par laquelle les modèles IAM peuvent être utilisés pour analyser la politique. Il simule quatre politiques dans la dernière version de son modèle DICE en utilisant les meilleures estimations pour les paramètres du changement climatique :

GRAPHIQUE Emissions de CO2 (en gigatonnes par an) selon différents scénarii

Dans le scénario n° 1, il n’y a pas de mesures de politique climatique de plus que celles déjà en place en 2015. Dans le scénario n° 2, les taxes carbone maximisent le bien-être mondial, selon des hypothèses économiques conventionnelles à propos de l’importance du bien-être des générations futures. Dans le scénario n° 3, les taxes carbone maximisent le bien-être mondial en donnant un plus grand poids au bien-être des générations futures que dans le scénario n° 2, comme le suggère The Economics of Climate Change: The Stern Review de 2007. Dans le scénario n° 4, les taxes carbone sont suffisamment élevées pour maintenir le réchauffement climatique en-deçà des 2,5°C tout en réduisant le coût en bien-être mondial.

Le graphique montre l’évolution des émissions de CO2 au cours du temps dans chacun de ces quatre scénarii. Les différentes trajectoires pour les taxes carbone signifient que les émissions (et donc l’ampleur du changement climatique) sont très différentes d’un scénario à l’autre. Dans le scénario n° 2, les taxes débutent à environ 30 dollars la tonne de CO2 et augmentent au cours du temps à peu près au même rythme que le PIB mondial. Dans les scénarii n° 3 et 4, qui simulent des réductions d’émissions plus fortes, les taxes sont six à huit fois plus importantes.

De grandes incertitudes. Dans les sciences naturelles et dans les sciences sociales, il y a des incertitudes à propos de plusieurs aspects du changement climatique. Par exemple, nous ne savons pas exactement à quel point le climat est sensible aux émissions de gaz à effet de serre ou quel est la probabilité que l’on atteigne un point tournant mondial au-delà duquel le climat échappe à tout contrôle. De même, nous ne savons pas tout à propos des dommages économiques et humains provoqués par le changement climatique et du coût de la décarbonisation.

Naturellement, les IAM développés par Nordhaus ne peuvent éliminer cette incertitude. Cependant, ses modèles peuvent analyser comment le prix approprié du carbone est affecté par différentes possibilités, par exemple une plus forte sensibilité du climat ou une plus forte probabilité d’un point tournant mondial dangereux à 2° C de réchauffement. (...) »

Académie royale des sciences de Suède, « Integrating nature and knowledge into economics », 8 octobre 2018. Traduit par Martin Anota

« billets précédents - page 4 de 16 - billets suivants »